(CLO) Το εργαλείο μετατροπής ομιλίας σε κείμενο του OpenAI, το Whisper, διαφημίζεται ως «ανθεκτικό και ακριβές σχεδόν ανθρώπινου επιπέδου», αλλά έχει ένα σημαντικό μειονέκτημα: Είναι επιρρεπές στην κατασκευή αποσπασμάτων κειμένου ή ακόμα και ολόκληρων προτάσεων!

Μερικά από τα κείμενα που κατασκευάζει, γνωστά στον κλάδο ως παραισθησιογόνα, μπορεί να περιλαμβάνουν φυλετικά σχόλια, βία, ακόμη και φανταστικές ιατρικές θεραπείες, λένε οι ειδικοί.

Οι ειδικοί λένε ότι τέτοιες κατασκευές είναι σοβαρές, επειδή το Whisper χρησιμοποιείται σε πολλές βιομηχανίες σε όλο τον κόσμο για τη μετάφραση και μεταγραφή συνεντεύξεων, τη δημιουργία κειμένου και βίντεο με υπότιτλους.

Ακόμα πιο ανησυχητικό είναι ότι τα ιατρικά κέντρα χρησιμοποιούν εργαλεία που βασίζονται στο Whisper για την καταγραφή των συμβουλών ασθενών-γιατρών, παρά την προειδοποίηση του OpenAI ότι το εργαλείο δεν πρέπει να χρησιμοποιείται σε «περιοχές υψηλού κινδύνου».

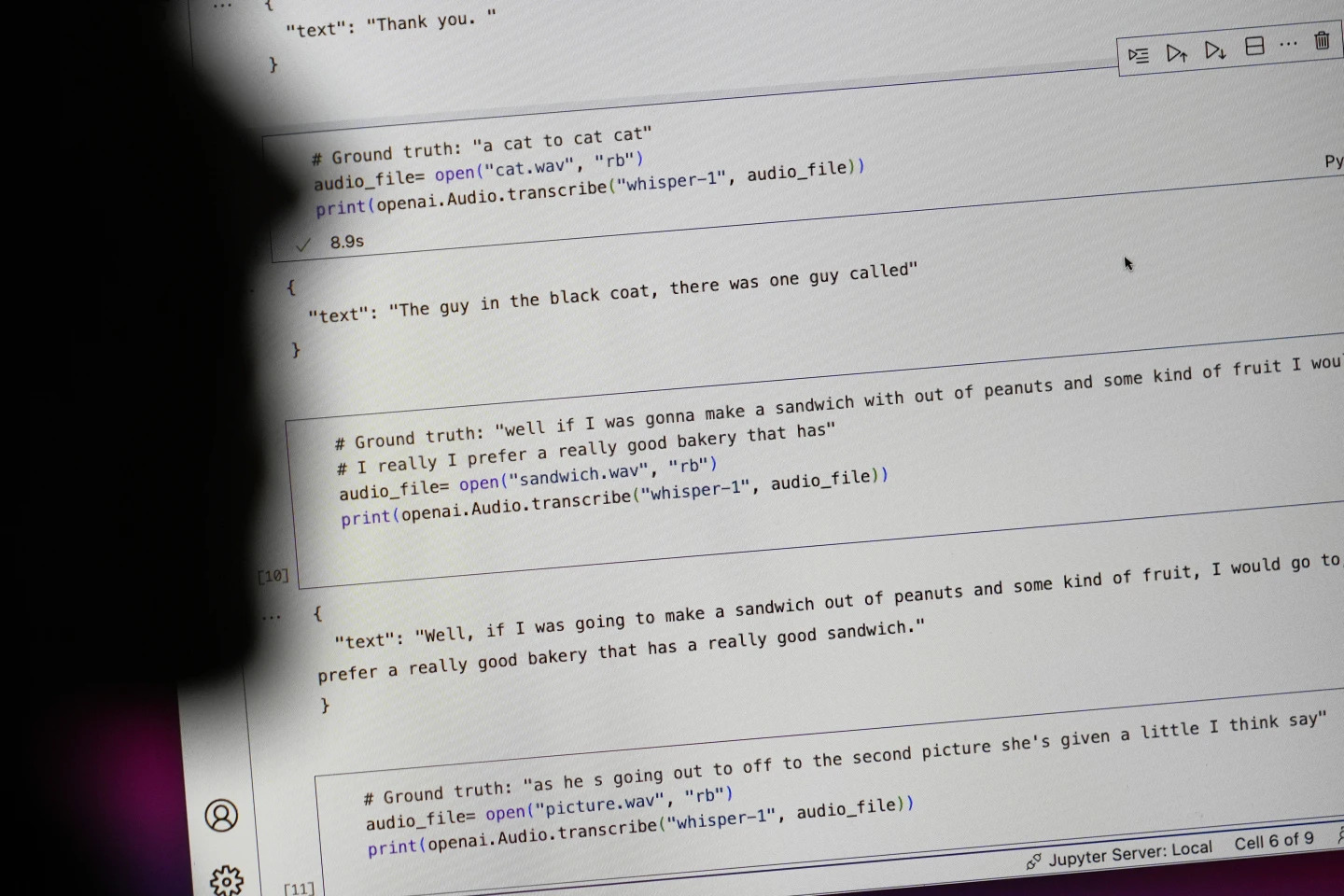

Οι προτάσεις που ξεκινούν με "#Ground truth" είναι ό,τι ειπώθηκε στην πραγματικότητα, οι προτάσεις που ξεκινούν με "#text" είναι ό,τι μετέγραψε ο Whisper. Φωτογραφία: AP

Ερευνητές και μηχανικοί λένε ότι το Whisper προκαλεί συχνά παραισθήσεις κατά τη χρήση. Για παράδειγμα, ένας ερευνητής του Πανεπιστημίου του Μίσιγκαν είπε ότι βρήκε παραισθήσεις σε οκτώ από τις 10 ηχογραφήσεις που εξέτασε.

Ένας πρώιμος μηχανικός μηχανικής μάθησης βρήκε χειραγώγηση σε περίπου τις μισές από τις περισσότερες από 100 ώρες μεταγραφών του Whisper που ανέλυσε. Ένας τρίτος προγραμματιστής είπε ότι βρήκε παραισθήσεις σε σχεδόν κάθε μία από τις 26.000 μεταγραφές που δημιουργήθηκαν με το Whisper.

Η ψευδαίσθηση επιμένει ακόμη και σε σύντομα, καλοηχογραφημένα ηχητικά δείγματα. Μια πρόσφατη μελέτη από επιστήμονες υπολογιστών διαπίστωσε 187 παραμορφώσεις σε περισσότερα από 13.000 καθαρά ηχητικά αποσπάσματα που εξέτασαν.

Αυτή η τάση θα οδηγούσε σε δεκάδες χιλιάδες σφάλματα σε εκατομμύρια ηχογραφήσεις, ανέφεραν οι ερευνητές.

Τέτοια λάθη μπορούν να έχουν «πραγματικά σοβαρές συνέπειες», ειδικά σε νοσοκομειακό περιβάλλον, δήλωσε η Αλόντρα Νέλσον, καθηγήτρια στη Σχολή Κοινωνικών Επιστημών στο Ινστιτούτο Προηγμένων Σπουδών.

«Κανείς δεν θέλει να του γίνει λανθασμένη διάγνωση. Πρέπει να υπάρχει ένα υψηλότερο όριο», είπε ο Νέλσον.

Οι καθηγήτριες Άλισον Κένεκ του Πανεπιστημίου Κορνέλ και Μόνα Σλόαν του Πανεπιστημίου της Βιρτζίνια εξέτασαν χιλιάδες σύντομα αποσπάσματα που ανέκτησαν από το TalkBank, ένα ερευνητικό αρχείο που φυλάσσεται στο Πανεπιστήμιο Κάρνεγκι Μέλον. Διαπίστωσαν ότι σχεδόν το 40% των ψευδαισθήσεων ήταν επιβλαβείς ή ενοχλητικές επειδή ο ομιλητής θα μπορούσε να παρερμηνευτεί ή να παρουσιαστεί λανθασμένα.

Ένας ομιλητής σε μια ηχογράφηση περιέγραψε «δύο άλλα κορίτσια και μια γυναίκα», αλλά ο Whisper κατασκεύασε πρόσθετα ρατσιστικά σχόλια, προσθέτοντας «δύο άλλα κορίτσια και μια γυναίκα, εεε, που ήταν μαύρη».

Σε μια άλλη μεταγραφή, ο Whisper εφηύρε ένα ανύπαρκτο φάρμακο που ονομάζεται «αντιβιοτικά με αυξημένη δράση».

Ενώ οι περισσότεροι προγραμματιστές αναγνωρίζουν ότι τα εργαλεία μεταγραφής μπορούν να κάνουν ορθογραφικά λάθη ή άλλα σφάλματα, οι μηχανικοί και οι ερευνητές λένε ότι δεν έχουν ξαναδεί ένα εργαλείο μεταγραφής με τεχνητή νοημοσύνη τόσο παραισθησιογόνο όσο το Whisper.

Το εργαλείο είναι ενσωματωμένο σε διάφορες εκδόσεις του ChatGPT, του κορυφαίου chatbot της OpenAI, και αποτελεί μια ενσωματωμένη υπηρεσία στην πλατφόρμα cloud computing της Oracle και της Microsoft, εξυπηρετώντας χιλιάδες εταιρείες παγκοσμίως. Χρησιμοποιείται επίσης για τη μεταγραφή και μετάφραση κειμένου σε πολλές γλώσσες.

Νγκοκ Αν (σύμφωνα με το AP)

[διαφήμιση_2]

Πηγή: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Φωτογραφία] Έναρξη της 13ης Συνδιάσκεψης της 13ης Κεντρικής Επιτροπής του Κόμματος](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/6/d4b269e6c4b64696af775925cb608560)

![[Φωτογραφία] Ο Πρωθυπουργός Φαμ Μινχ Τσινχ προεδρεύει της διαδικτυακής διάσκεψης της κυβέρνησης με τους τοπικούς φορείς](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/5/264793cfb4404c63a701d235ff43e1bd)

![[Φωτογραφία] Ο Πρωθυπουργός Φαμ Μινχ Τσινχ ξεκίνησε μια εκστρατεία εξομοίωσης κορυφής για την επίτευξη επιτευγμάτων, κατά τον εορτασμό του 14ου Εθνικού Συνεδρίου του Κόμματος](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/5/8869ec5cdbc740f58fbf2ae73f065076)

Σχόλιο (0)