A continuación se presentan las opiniones de dos expertos de la Universidad RMIT sobre los efectos nocivos de los deepfakes y las soluciones propuestas a este problema:

|

| El Dr. Jonathan Crellin (izquierda) y el Dr. Nguyen Van Thang Long (derecha). (Fuente: Universidad RMIT) |

Los ciberdelincuentes explotan las nuevas tecnologías de maneras imprevistas.

Dr. Jonathan Crellin, Jefe de Seguridad de la Información, Facultad de Ciencias , Ingeniería y Tecnología, Universidad RMIT :

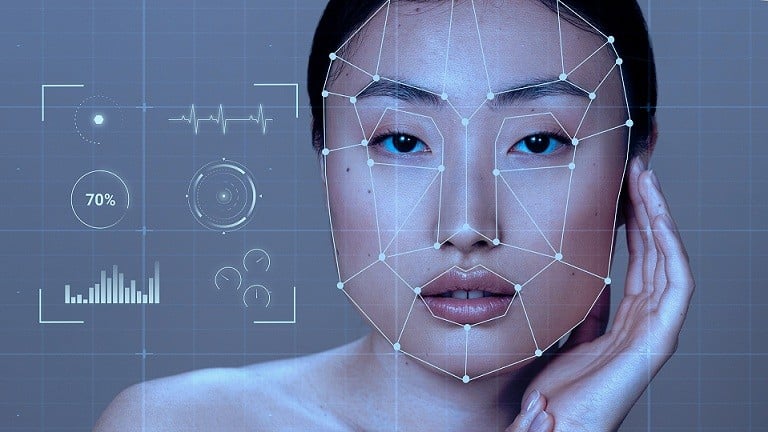

Deepfake es una imagen generada por máquina que puede combinar imágenes o vídeos de múltiples fuentes, creando una imagen, vídeo o incluso audio muy realista.

La técnica deepfake se basa en una técnica de inteligencia artificial llamada aprendizaje automático, que puede reemplazar e integrar elementos como el rostro de una persona en otra imagen o vídeo.

Un ejemplo del uso de deepfakes es la combinación de contenido pornográfico con fotos de Taylor Swift para crear imágenes falsas.

Para ello, el cerebro detrás de todo necesitaba una serie de imágenes para que el software pudiera aprender sobre las expresiones faciales de la cantante, y luego combinarlas con contenido pornográfico para crear fotos obscenas, dañando así la imagen de la cantante.

De hecho, se rumorea que estas fotos fueron publicadas por un grupo de Telegram y creadas utilizando la herramienta Microsoft Designer con soporte integrado de IA.

Cualquiera puede convertirse en víctima, ya que los delincuentes solo necesitan una fotografía, un vídeo o una grabación de audio de la persona a la que están suplantando.

Las noticias falsas, en sus diversas formas, tienen el potencial de utilizarse para crear noticias falsas, y es seguro decir que las próximas elecciones presidenciales de Estados Unidos estarán plagadas de este tipo de noticias falsas.

Actualmente, legisladores de todo el mundo buscan promulgar leyes contra este tipo de imágenes.

En Estados Unidos se están empezando a adoptar diversos enfoques legislativos, como el recurso a demandas civiles o leyes para abordar “la difusión de imágenes sexualmente explícitas de una persona generadas por IA sin su consentimiento”.

China también introdujo nuevas regulaciones que permitirían el enjuiciamiento de quienes difundan imágenes generadas por IA.

El Reino Unido ha tipificado como delito la difusión de contenido deepfake en virtud de su ley de seguridad en línea.

¿Cómo detectarlo o prevenirlo?

El primer paso es reducir la cantidad de fotos, videos o grabaciones de audio que tienes en línea. Asegúrate de compartirlos solo con personas que conoces y no los publiques en internet. Una vez que algo está en internet, es casi imposible eliminarlo.

La segunda opción es acordar una palabra secreta con tu familia para autenticar la llamada, reduciendo así el riesgo de caer en la trampa de una llamada falsa.

Las imágenes, especialmente los vídeos, pueden contener errores extraños (que parecen artificiales); si detecta estos errores, existe una alta probabilidad de que la imagen o el sonido hayan sido falsificados.

Otra técnica que se puede utilizar es buscar “imagen inversa” en Google u otros motores de búsqueda, para determinar la fuente de la imagen original.

La lección final es: no creas ciegamente lo que ves, ¡la cámara (o la IA) puede mentir!

Los deepfakes suponen una enorme amenaza para famosos y políticos.

Dr. Nguyen Van Thang Long, Profesor Titular, Facultad de Comunicación y Diseño, Universidad RMIT :

Ante la proliferación de noticias falsas procedentes de deepfakes, los equipos de comunicación de famosos y políticos necesitan disponer de recursos para controlar y responder con prontitud a las noticias falsas o corregirlas continuamente.

Si los deepfakes se combinan sistemáticamente con formas organizadas de "relaciones públicas sucias", esta tarea se vuelve aún más difícil debido a la proliferación de información contradictoria, y las noticias falsas y negativas siempre se compartirán más que las positivas.

Normalmente, cuando ven noticias compartidas en redes sociales, las personas suelen tener la costumbre de verificar la información a través de canales de comunicación oficiales.

Con la proliferación de contenido deepfake en las redes sociales, resulta cada vez más difícil y laborioso verificar la veracidad de las noticias convencionales, lo que requiere una investigación exhaustiva y técnicas de verificación.

Cuanto más tardemos en verificar las noticias y las fuentes, mayor será la probabilidad de que se difunda información falsa, fabricada o engañosa debido a la rapidez con que se comparten y comentan las noticias en las redes sociales.

Esto agrava el problema subyacente y tiene el potencial de generar disturbios sociales, especialmente si el contenido se relaciona con el discurso político, la religión, el género, las estrategias empresariales o las cuestiones macroeconómicas.

En el contexto de la proliferación de deepfakes, la estrategia de gestión de riesgos más eficaz sigue siendo mantener canales de comunicación constantes, a través de plataformas de redes sociales populares, sitios web o reuniones cara a cara, entre empresas, celebridades, políticos y partes interesadas clave como fans, prensa, comunidades y empleados.

|

El creciente uso de la IA trae consigo tanto beneficios como nuevos problemas inesperados. Foto ilustrativa. (Fuente: Freepik) |

Al mantener estos canales de comunicación, la recepción de información relacionada con los deepfakes se vuelve más rápida, lo que permite una corrección oportuna y eficaz de los rumores, exponiendo la desinformación desde el principio.

Sin embargo, las empresas, las celebridades y los políticos deben desarrollar un plan de gestión de crisis específico para los deepfakes. Por ejemplo, quién informa, a través de qué canales de comunicación, los criterios para verificar la información mediante pruebas y fuentes fiables, establecer un cronograma para gestionar los rumores y definir una estrategia para recuperar la reputación.

Con un plan metódico y bien preparado, gestionar la crisis de los deepfakes será más factible, minimizando las desafortunadas consecuencias que puedan producirse.

Fuente

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, mantiene conversaciones con el presidente de la Asamblea Nacional de Corea del Sur, Woo Won Shik.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763629724919_hq-5175-jpg.webp&w=3840&q=75)

![[Foto] Lam Dong: Vista panorámica de la cascada Lien Khuong, que ruge como nunca antes.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763633331783_lk7-jpg.webp&w=3840&q=75)

![[Foto] El presidente Luong Cuong recibe al presidente del Senado de la República Checa, Milos Vystrcil](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763629737266_ndo_br_1-jpg.webp&w=3840&q=75)

![Dominar el conocimiento para reducir la pobreza: [Lección 3] Vivir saludablemente con pitaya](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/18/1763433780787_dsc09493-065032_269-094015.jpeg)

Kommentar (0)