(CLO) La herramienta de conversión de voz a texto Whisper de OpenAI se promociona como "casi a nivel humano, robusta y precisa", pero tiene un inconveniente importante: ¡es propensa a fabricar fragmentos de texto o incluso oraciones completas!

Algunos de los textos que fabrica, conocidos en la industria como alucinatorios, pueden incluir comentarios raciales, violencia e incluso tratamientos médicos imaginarios, dicen los expertos.

Los expertos dicen que estas invenciones son graves porque Whisper se utiliza en muchas industrias alrededor del mundo para traducir y transcribir entrevistas, generar textos y subtitular vídeos.

Lo que es más preocupante es que los centros médicos están utilizando herramientas basadas en Whisper para registrar las consultas entre pacientes y médicos, a pesar de la advertencia de OpenAI de que la herramienta no debe utilizarse en "zonas de alto riesgo".

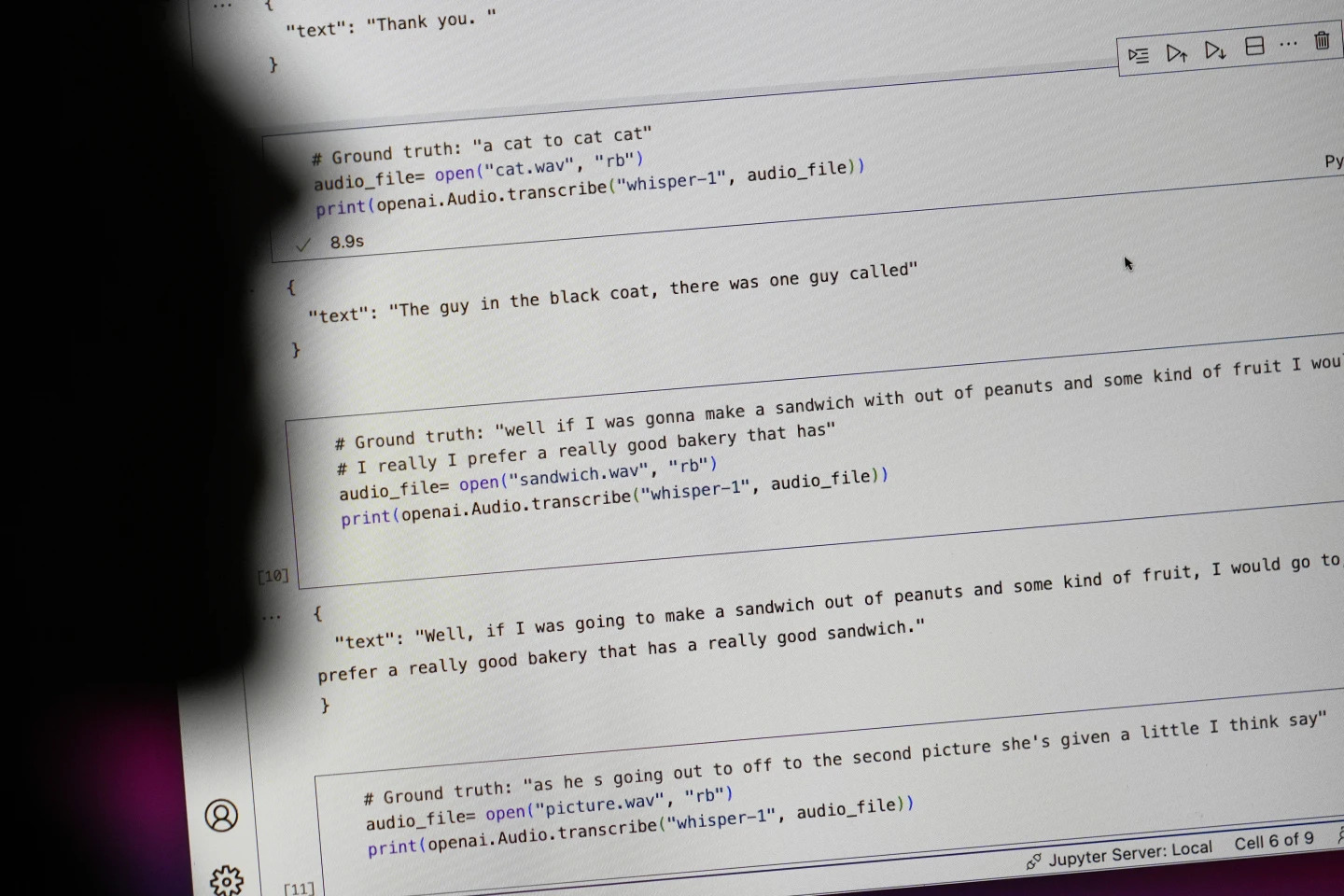

Las frases que empiezan con "#Groundtruth" son lo que realmente se dijo; las frases que empiezan con "#text" son lo que Whisper transcribió. Foto: AP

Investigadores e ingenieros afirman que Whisper produce alucinaciones con frecuencia durante su uso. Por ejemplo, un investigador de la Universidad de Michigan afirmó haber encontrado alucinaciones en ocho de cada diez grabaciones que examinó.

Un ingeniero de aprendizaje automático pionero detectó manipulación en aproximadamente la mitad de las más de 100 horas de transcripciones de Whisper que analizó. Un tercer desarrollador afirmó haber encontrado alucinaciones en casi todas las 26.000 transcripciones creadas con Whisper.

La ilusión persiste incluso en muestras de audio cortas y bien grabadas. Un estudio reciente realizado por informáticos detectó 187 distorsiones en más de 13 000 clips de audio nítidos que examinaron.

Esa tendencia daría lugar a decenas de miles de errores en millones de grabaciones, dijeron los investigadores.

Estos errores pueden tener “consecuencias realmente graves”, especialmente en un entorno hospitalario, dijo Alondra Nelson, profesora de la Escuela de Ciencias Sociales del Instituto de Estudios Avanzados.

“Nadie quiere que le diagnostiquen mal. Es necesario que haya una barrera más fuerte”, dijo Nelson.

Las profesoras Allison Koenecke, de la Universidad de Cornell, y Mona Sloane, de la Universidad de Virginia, examinaron miles de fragmentos breves que recuperaron de TalkBank, un archivo de investigación de la Universidad Carnegie Mellon. Determinaron que casi el 40 % de las alucinaciones eran dañinas o perturbadoras porque el hablante podía ser malinterpretado o tergiversado.

En una grabación, un orador describió a "otras dos niñas y una mujer", pero Whisper inventó comentarios raciales adicionales y agregó: "otras dos niñas y una mujer, eh, que era negra".

En otra transcripción, Whisper inventó un fármaco inexistente llamado "antibióticos con actividad aumentada".

Si bien la mayoría de los desarrolladores reconocen que las herramientas de transcripción pueden cometer errores ortográficos u otros errores, los ingenieros e investigadores dicen que nunca han visto una herramienta de transcripción impulsada por IA tan alucinógena como Whisper.

La herramienta está integrada en varias versiones del chatbot insignia de OpenAI, ChatGPT, y es un servicio integrado en la plataforma de computación en la nube de Oracle y Microsoft, que presta servicio a miles de empresas en todo el mundo. También se utiliza para transcribir y traducir texto a numerosos idiomas.

Ngoc Anh (según AP)

[anuncio_2]

Fuente: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

Kommentar (0)