Llamadas fraudulentas deepfake: una estafa nueva y muy sofisticada

Un caso típico es el de la Sra. VTM (26 años, Long Bien, Hanói ), quien recibió un mensaje de un familiar en el extranjero pidiéndole que transfiriera 75 millones de VND a una cuenta determinada. En ese momento, la Sra. VTM pensó que se trataba de un familiar, así que no dudó en transferir el dinero.

La Sra. VTM dijo que cuando recibió un mensaje pidiéndole dinero prestado a un familiar, volvió a llamar con cuidado para verificar el video y vio que la imagen era efectivamente de su amiga. Confió en ella y transfirió el préstamo. Pero después de un tiempo, vio una publicación en la página personal de su familiar que anunciaba que un estafador había pirateado su cuenta de Facebook para pedirle dinero prestado a algunos amigos y familiares. La Sra. VTM volvió a llamar a su familiar y descubrió que la habían estafado.

O la situación del Sr. VDC (42 años, residente de Co Nhue, Hanói), quien afirmó haber sido estafado con 30 millones de VND mediante una videollamada falsa. Específicamente, recientemente, un familiar en el extranjero le envió un mensaje de texto solicitando un préstamo por un asunto urgente. Inmediatamente después, la Sra. Tam recibió una videollamada a través de la aplicación Messenger de Facebook.

La llamada solo duró unos segundos, pero vi el rostro de mi ser querido y su forma familiar de dirigirse a él, pero la llamada era intermitente. Luego recibí un mensaje diciendo que la señal era débil y que no podía continuar la videollamada, así que cambié a mensajes de texto para mayor comodidad. Confié en él y transferí el dinero según las instrucciones, relató el Sr. VDC.

Al comentar sobre este tema, el experto en tecnología Ngo Minh Hieu, del Centro Nacional de Monitoreo de Ciberseguridad (NCSC), afirmó que la inteligencia artificial (IA) está siendo de gran ayuda en la vida de las personas. Sin embargo, los cibercriminales la han aprovechado para crear imágenes que imitan la voz, desde secuestrar cuentas de Facebook e Instagram, analizar mensajes, formas de tratamiento e historial de transacciones, hasta crear llamadas falsas y estafar a familiares de la cuenta secuestrada, o llamar directamente a la víctima para generar situaciones urgentes que requieren transferencias de dinero.

“Después de apoderarse del Facebook de la víctima, el estafador le envió un mensaje de texto para pedirle dinero prestado, luego le hizo una videollamada proactiva con un video Deepfake y colgó unos segundos, luego dijo que perdió la señal de su teléfono... En este punto, la víctima confió en él y le transfirió el dinero porque la otra parte necesitaba pedir dinero prestado urgentemente”, comentó el experto en tecnología Ngo Minh Hieu.

El Sr. Ngo Tuan Anh, presidente del consejo de administración y director ejecutivo de Smart Cyber Security Joint Stock Company, afirmó que el fraude en línea se divide actualmente en dos métodos principales: la suplantación de identidad de agencias de investigación y tribunales, y el aprovechamiento de la codicia de las personas, como la obtención de grandes recompensas y el lucro fácil. Con estas dos formas de fraude, existen diversos escenarios, incluyendo la posibilidad de que se recomiende a los usuarios verificar la información mediante una videollamada. Fueron los estafadores quienes idearon este método de "neutralización" para estafar a las víctimas.

¿Cómo funciona el deepfake?

Según la Policía de la ciudad de Hanoi, Deepfake es una tecnología que aplica inteligencia artificial (IA) para crear productos de tecnología de audio, imagen y video que falsifican objetos de la vida real con mucha precisión.

A partir de la imagen del rostro y la voz de una persona real, Deepfake utiliza algoritmos para recrear el rostro y la voz de forma que coincidan con los rasgos y expresiones faciales de otra persona; posteriormente, crea un video que imita completamente al sujeto real. A través de internet, los sujetos recopilan imágenes y voces de usuarios en redes sociales y, utilizando la tecnología Deepfake, crean animaciones y videos falsos de usuarios hablando en línea con el mismo rostro, tono de voz y forma de dirigirse.

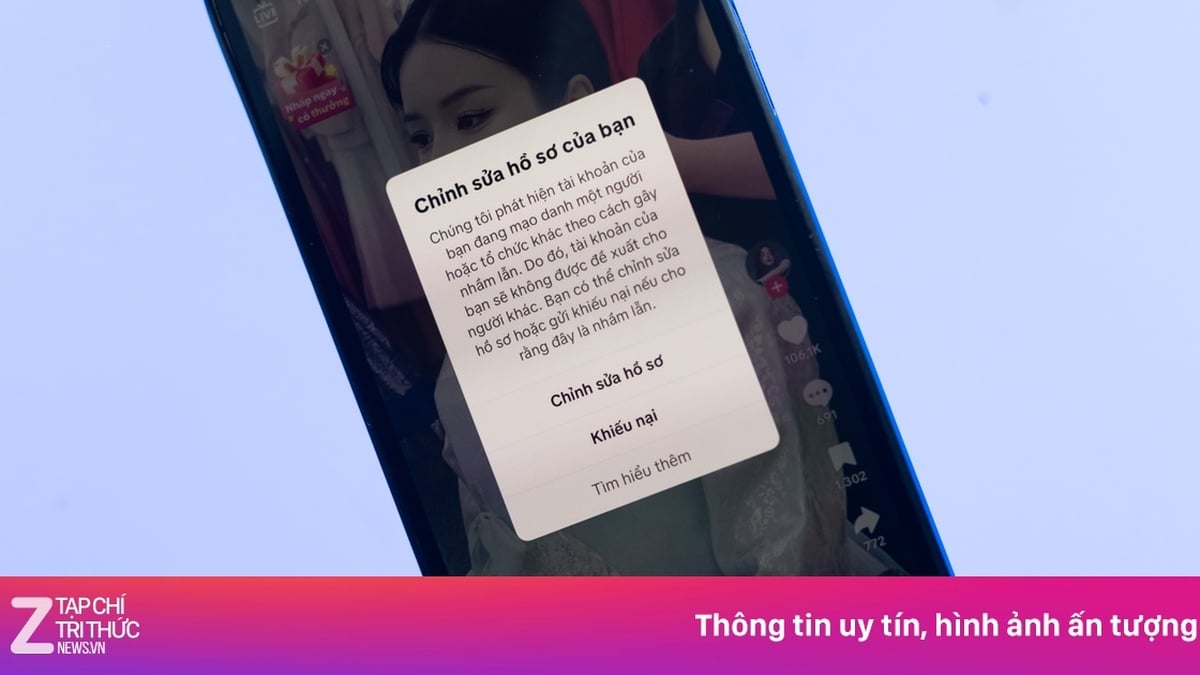

El sujeto crea cuentas falsas en redes sociales con la misma información y fotos de perfil que el usuario, se hace amigo de la víctima en su lista de amigos y le envía mensajes para pedirle dinero prestado según una situación preexistente. En algunos casos, el sujeto piratea la cuenta de redes sociales del usuario para enviar mensajes directos a las víctimas de su lista de amigos. Para ganarse la confianza de la víctima, sube videos deepfake existentes a la videollamada, lo que le permite reconocer la imagen y la voz de un conocido y transferir dinero rápidamente según su solicitud.

La Policía de la Ciudad de Hanói añadió que, con la tecnología Deepfake, los videos falsos tienen una alta precisión, lo que dificulta distinguir entre lo real y lo falso. Sin embargo, los videos creados por el sujeto suelen tener un contenido general que no se corresponde completamente con el contexto real de la comunicación con la víctima, lo que puede despertar sospechas y ser detectado. Para encubrir estas deficiencias, los sujetos suelen crear videos con sonido difícil de escuchar e imágenes borrosas, similares a videollamadas con señal inestable realizadas en zonas con poca cobertura móvil o wifi. Se trata de una estafa muy nueva y sofisticada.

¿Cómo evitar el robo de datos faciales y de voz?

Según el experto en tecnología Ngo Minh Hieu, la mejor forma de evitar Deepfake es que los usuarios limiten el intercambio de imágenes o vídeos personales en línea y siempre aseguren las cuentas de redes sociales y correo electrónico con contraseñas de alto nivel.

Si compartes videos o clips en línea, debes distorsionar tu voz y reemplazarla con una voz de robot o IA para evitar que los malos conozcan tu voz real.

Si se falsifica un Deepfake, los usuarios deben notificar inmediatamente a todos e informar a las autoridades en canhbao.ncsc.gov.vn o informar al proyecto chongluadao https://chongluadao.vn; al mismo tiempo, es necesario crear conciencia sobre el reconocimiento de fraude en el ciberespacio en: dauhieuluadao.com.

La Policía de la Ciudad de Hanói recomienda a las personas estar alertas al recibir mensajes o videollamadas que incluyan préstamos o préstamos de dinero a través de redes sociales. Es importante mantener la calma al recibir mensajes o videollamadas que incluyan préstamos o préstamos de dinero a través de redes sociales y luego llamar o contactar directamente a sus familiares para verificar la información (no llamar a través de redes sociales como Zalo, Messenger, Viber, Telegram, etc.). Si sospechan que alguien se hace pasar por familiares en redes sociales para defraudar o apropiarse de bienes, deben denunciarlo de inmediato a la policía más cercana para recibir apoyo oportuno y combatir, prevenir y tratar a estos individuos estrictamente de acuerdo con la ley.

Al compartir cómo prevenir y combatir las llamadas fraudulentas, el Sr. Ngo Tuan Anh señaló que es necesario estar alerta y no hacer clic en enlaces desconocidos. Si se transfiere dinero, existe una forma sencilla y eficaz de verificarlo: revisar la aplicación de banca por internet del banco para comprobar si la información de familiares y amigos es correcta al ingresar el número de cuenta antes de realizar la transferencia.

El experto en tecnología Ngo Minh Hieu dijo que una señal para reconocer y evitar las llamadas Deepfake es que el rostro del personaje en el video carece de emoción y es bastante "indiferente" al hablar, o la postura es incómoda, poco natural, o la dirección de la cabeza y el cuerpo del personaje en el video son inconsistentes entre sí.

Según las empresas de seguridad, Deepfake es una combinación de "profundo" (deep learning) y "falso". El aprendizaje profundo consiste en el uso de métodos avanzados de IA que aplican numerosos algoritmos para sintetizar gradualmente características avanzadas a partir de los datos de entrada. A partir de ahí, esta tecnología tiene la capacidad de sintetizar y aprender de los datos que los usuarios introducen, como rostros humanos, movimientos físicos y voces. Deepfake puede asignar el rostro de una persona a otra en un vídeo con gran autenticidad. |

ESTILO DE OFICINA

[anuncio_2]

Fuente

![[Noticias Marítimas] Más del 80% de la capacidad mundial de transporte de contenedores está en manos de MSC y las principales alianzas navieras.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Kommentar (0)