El juez P. Kevin Castel declaró que los abogados actuaron de forma irresponsable. Sin embargo, reconoció las disculpas y las medidas adoptadas por ambos abogados, y explicó por qué no eran necesarias sanciones más severas para evitar que otros abogados siguieran el ejemplo.

Foto: CNYB

“Los avances tecnológicos son normales, y no hay nada de malo en usar una herramienta de IA confiable para obtener ayuda”, escribió el Sr. Castel. “Pero la normativa actual exige que los abogados garanticen la exactitud de los registros que presentan”.

El juez dijo que los abogados y el bufete Levidow & Oberman “abdicaron de su responsabilidad al emitir opiniones judiciales inexistentes con citas falsas generadas por la herramienta de inteligencia artificial ChatGPT”.

En un comunicado, el bufete afirmó que acataría la orden del juez, pero añadió: «Discrepamos rotundamente de la insinuación de que alguien en nuestro bufete actuó de forma irresponsable. Nos hemos disculpado con el Tribunal y con nuestros clientes. Esta es una situación sin precedentes para el poder judicial, y cometimos el error de no creer que la tecnología pudiera inventar casos inexistentes».

En una audiencia a principios de este mes, un abogado dijo que utilizó un chatbot impulsado por inteligencia artificial para ayudar a encontrar precedentes legales que respaldaran la demanda de un cliente contra la aerolínea colombiana Avianca por una lesión ocurrida en un vuelo de 2019.

El juez dijo que una de las decisiones falsas generadas por el chatbot “tenía algunas características que parecían consistentes con decisiones judiciales reales”, pero contenía “tonterías”.

Quoc Thien (según AP)

[anuncio_2]

Fuente

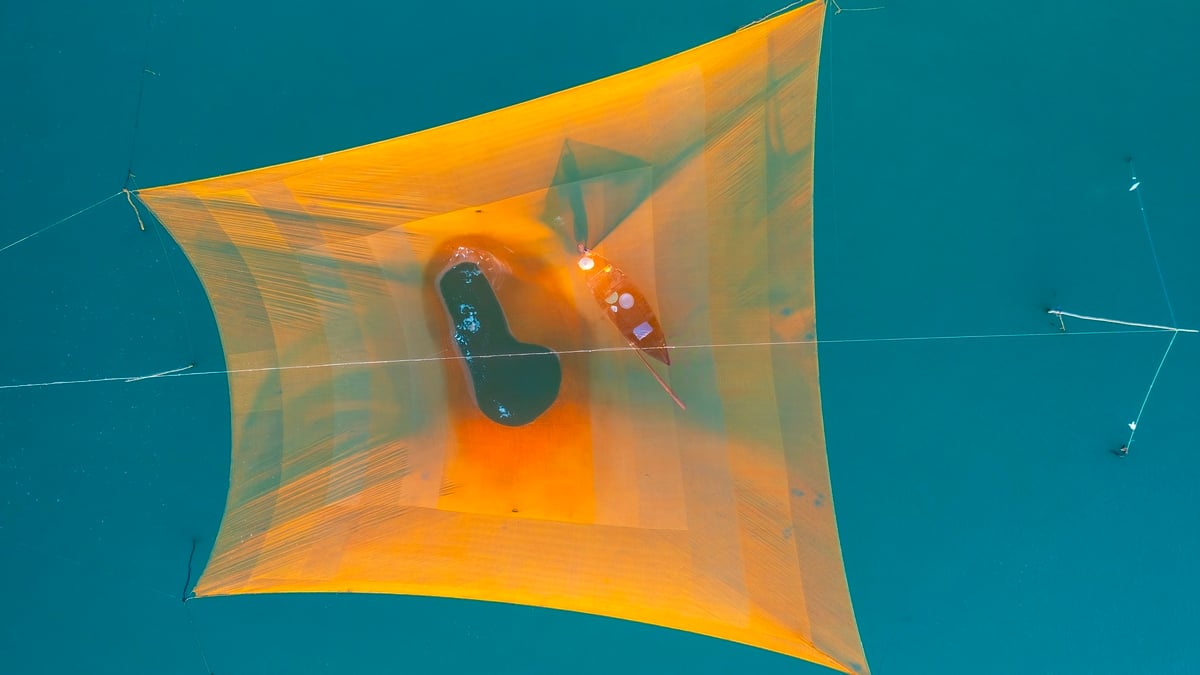

![[Foto] Descubre la "maravilla" bajo el mar de Gia Lai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

![[Foto] Nghe An: La carretera provincial 543D está gravemente erosionada debido a las inundaciones.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/5/5759d3837c26428799f6d929fa274493)

Kommentar (0)