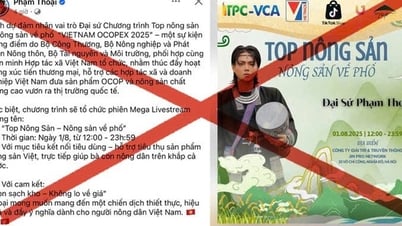

Las fotos falsas de famosos están muy extendidas

Nunca ha sido tan fácil crear imágenes que parecen increíblemente realistas, pero que en realidad son falsas. Cualquiera con conexión a internet y acceso a una herramienta con inteligencia artificial puede crear fotos realistas en segundos y luego difundirlas en redes sociales a una velocidad increíble.

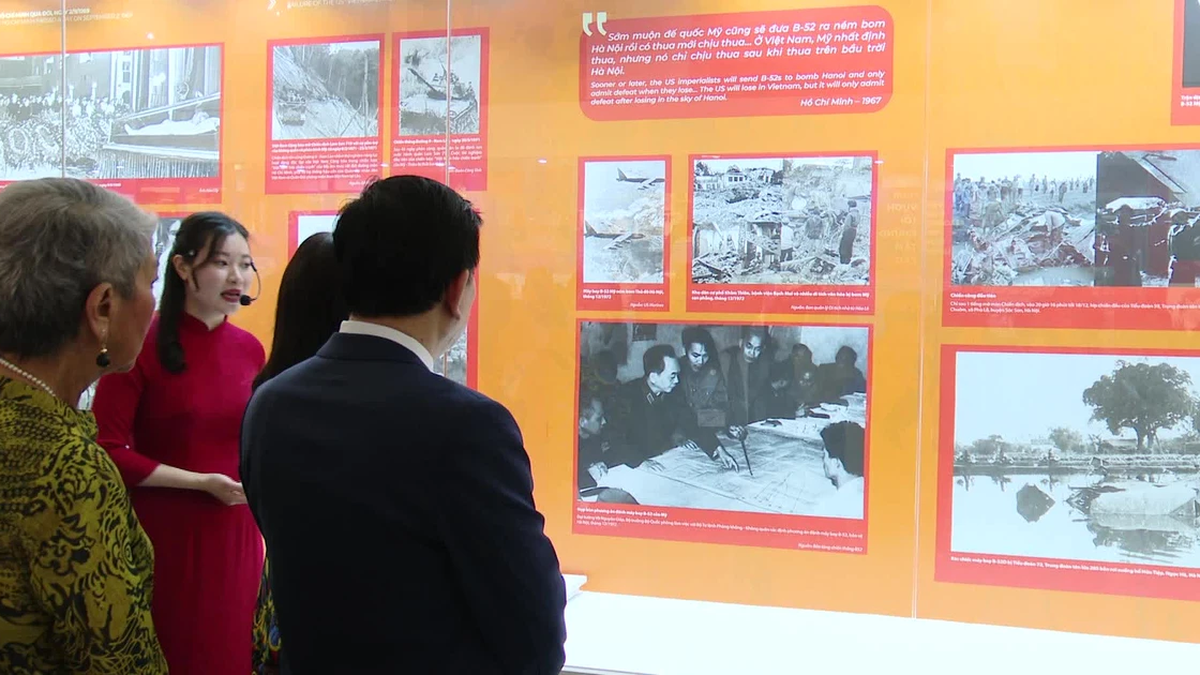

Una fotografía falsa generada por inteligencia artificial pretende mostrar a Elon Musk "saliendo" con la directora ejecutiva de GM, Mary Barra.

En los últimos tiempos, muchas de estas imágenes se han vuelto virales: como la del expresidente Donald Trump y el presidente Vladimir Putin siendo arrestados falsamente o la del multimillonario Elon Musk “pasando el rato” con la directora ejecutiva de General Motors (GM), Mary Barra.

El problema es que las imágenes de IA representan eventos que nunca sucedieron. Y aunque algunas de estas imágenes puedan ser graciosas y parecer irreales, los expertos afirman que aún pueden representar peligros reales en términos de desinformación, incluso difundiendo noticias falsas.

Las imágenes de arrestos de políticos como el expresidente estadounidense Donald Trump pueden ser verificadas con bastante rapidez por los usuarios si consultan medios de comunicación fiables. Sin embargo, el experto en inteligencia artificial Henry Ajder declaró a DW que otras imágenes son más difíciles de identificar, como aquellas en las que la persona que aparece en la foto no es tan famosa.

El peligro de las fotos falsas de eventos

Según Ajder, no son solo las imágenes de personas generadas por IA las que pueden difundir desinformación. Añadió que ha habido ejemplos de usuarios que crearon eventos que nunca ocurrieron, como el gran terremoto que supuestamente sacudió Estados Unidos y Canadá en 2001.

Pero el terremoto nunca ocurrió, y las imágenes compartidas en Reddit fueron generadas por IA. Y ese, dice Ajder, es el problema. «Si la IA genera un paisaje, puede ser más difícil de localizar», explica.

Aun así, las herramientas de IA cometen errores, incluso a pesar de su rápida mejora. En abril de 2023, programas como Midjourney, Dall-E y DeepAI presentaban fallos, especialmente con imágenes que mostraban a personas.

A continuación se ofrecen algunos consejos para verificar imágenes generadas por IA, pero los expertos se apresuraron a advertir que solo reflejan la situación actual, ya que las herramientas de inteligencia artificial evolucionan cada día, incluso cada hora:

Amplíe y encuentre la fuente de la imagen.

Muchas imágenes generadas por IA parecen reales a primera vista. Por eso, la primera sugerencia de los expertos es observar la foto con más atención. Para ello, busque la resolución más alta posible y luego amplíe los detalles.

Al ampliar la imagen se revelarán inconsistencias y errores que pueden pasar desapercibidos a primera vista.

Si no estás seguro de si una imagen es real o generada por IA, intenta buscar su origen. Puedes obtener información sobre dónde se publicó originalmente leyendo los comentarios de otros usuarios debajo.

También puedes hacer una búsqueda inversa de imágenes. Para ello, sube la imagen a herramientas como Google Image Reverse Search, TinEye o Yandex y encontrarás su fuente original.

Los resultados de estas búsquedas también pueden mostrar enlaces a verificaciones de hechos realizadas por medios de comunicación confiables que brindan contexto adicional.

Preste atención a las proporciones corporales y a los errores de visualización.

No es raro que las imágenes generadas por IA presenten diferencias de proporción. Las manos podrían ser demasiado pequeñas o los dedos demasiado largos. O la cabeza y las piernas podrían no coincidir con el resto del cuerpo.

Actualmente, las manos son una fuente importante de error en programas de imágenes de IA como Midjourney o DALL-E. Es frecuente que las personas tengan dedos de más o de menos, como en las fotos falsas del Papa Francisco.

Foto falsa del Papa Francisco generada por IA.

Otros errores comunes en las imágenes generadas por IA incluyen personas con demasiados dientes, gafas con formas extrañas u orejas con formas poco realistas. Las superficies reflectantes, como las viseras de los cascos, también plantean problemas para los programas de IA.

Sin embargo, el experto en inteligencia artificial Henry Ajder advierte que las versiones más nuevas de programas como Midjourney están mejorando en la generación de manos, lo que significa que los usuarios no podrán confiar en que detecten este tipo de errores por mucho tiempo.

¿La imagen se ve falsa y suave?

En particular, la aplicación Midjourney produce imágenes tan hermosas y perfectas que los espectadores se ven obligados a hacerse preguntas. «Los rostros son demasiado puros, las telas demasiado armoniosas», afirma Andreas Dengel, del Centro Alemán de Investigación en IA.

En muchas imágenes de IA, la piel de las personas suele ser suave y sin imperfecciones, e incluso su cabello y dientes son perfectos. Esto es imposible en la vida real.

Muchas fotografías son artísticas, brillantes y relucientes, algo que incluso a los fotógrafos profesionales les resulta difícil conseguir cuando fotografían en el estudio.

Las herramientas de IA a menudo parecen diseñar imágenes ideales que se supone que son perfectas y complacen a la mayor cantidad de personas posible.

Comprueba el contexto y la conclusión

El fondo de una imagen a menudo puede revelar si ha sido falsificada. Los objetos pueden estar distorsionados, como las farolas. En algunos casos, los programas de IA copian personas y objetos y los utilizan una y otra vez. Y no es raro que el fondo de una imagen de IA esté borroso.

Pero incluso este desenfoque puede ser defectuoso. Como el que pretendía mostrar a un Will Smith enfadado en los Oscar. El fondo no solo estaba desenfocado, sino que también estaba difuminado artificialmente.

Muchas imágenes generadas por IA ahora se pueden detectar con solo pensarlo un poco. Herramientas de detección de IA como Hugging Face también pueden ayudarte a detectar falsificaciones. Sin embargo, a medida que la tecnología mejora, los defectos en las imágenes generadas por IA pueden volverse menos evidentes, lo que dificulta su detección.

Hoang Hai (según DW)

[anuncio_2]

Fuente

Kommentar (0)