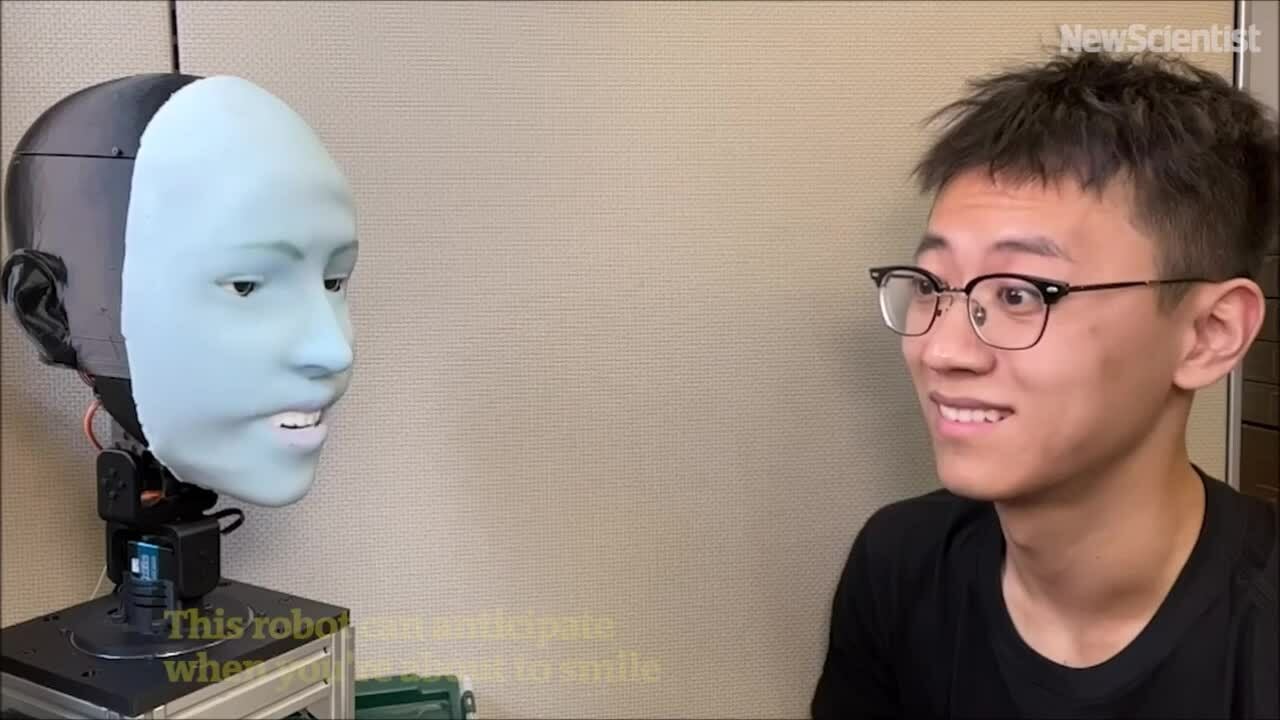

El robot estadounidense Emo puede predecir sonrisas unos 840 milisegundos antes de que la persona de enfrente sonría, y luego sonríe al mismo tiempo.

El robot emo puede predecir expresiones y sonreír al mismo tiempo que su oponente. Vídeo : New Scientist

Los humanos se están acostumbrando a los robots que pueden comunicarse con fluidez mediante el habla, gracias en parte a los avances en modelos de lenguaje extensos como ChatGPT, pero sus habilidades de comunicación no verbal, especialmente las expresiones faciales, aún están muy rezagadas. Diseñar un robot que no solo pueda expresar diversas expresiones faciales, sino que también sepa cómo expresarlas en el momento oportuno es extremadamente difícil.

El Laboratorio de Máquinas Creativas de la Facultad de Ingeniería de la Universidad de Columbia lleva más de cinco años trabajando en este problema. En un nuevo estudio publicado en la revista Science Robotics , el equipo ha presentado a Emo, un robot con IA que puede predecir expresiones faciales humanas y realizarlas en tiempo real, según informó TechXplore el 27 de marzo. Predice sonrisas unos 840 milisegundos antes de que la persona sonría, y luego sonríe a tiempo.

Emo es un robot humanoide con un rostro equipado con 26 actuadores que le permiten una amplia gama de expresiones. Su cabeza está recubierta de suave silicona con un sistema de conexión magnética, lo que facilita ajustes y mantenimiento. Para lograr interacciones más inmersivas, el equipo integró cámaras de alta resolución en las pupilas de cada ojo, lo que permite a Emo interactuar con sus ojos, lo cual es importante para la comunicación no verbal.

El equipo desarrolló dos modelos de IA. El primero predijo las expresiones faciales humanas analizando cambios sutiles en el rostro opuesto, y el segundo generó comandos motores utilizando las expresiones correspondientes.

Para entrenar al robot a expresar emociones, el equipo colocó a Emo frente a una cámara y le pidió que realizara movimientos aleatorios. Tras unas horas, el robot aprendió la relación entre las expresiones faciales y las órdenes motoras, de forma similar a como los humanos practican expresiones mirándose en un espejo. El equipo lo denomina "automodelado", similar a cómo los humanos se imaginan haciendo ciertas expresiones.

A continuación, el equipo reprodujo videos de expresiones faciales humanas para que Emo las observara fotograma a fotograma. Tras horas de entrenamiento, Emo pudo predecir expresiones observando los sutiles cambios en el rostro de una persona al comenzar a sonreír.

"Creo que predecir con precisión las expresiones faciales humanas es una revolución en el campo de la interacción entre humanos y robots. Anteriormente, los robots no estaban diseñados para considerar las expresiones humanas durante las interacciones. Ahora, los robots pueden integrar las expresiones faciales para responder", afirmó Yuhang Hu, estudiante de doctorado en el Laboratorio de Máquinas Creativas y miembro del equipo de investigación.

"Que los robots expresen sus expresiones al mismo tiempo que los humanos en tiempo real no solo mejora la calidad de la interacción, sino que también contribuye a generar confianza entre ambos. En el futuro, al interactuar con un robot, este observará e interpretará sus expresiones faciales, como si fuera un humano real", añadió Hu.

Thu Thao (según TechXplore )

[anuncio_2]

Enlace de origen

![[Noticias Marítimas] Más del 80% de la capacidad mundial de transporte de contenedores está en manos de MSC y las principales alianzas navieras.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Kommentar (0)