طبق گزارش Android Authority ، مقاله تحقیقاتی اپل، راهکاری برای اجرای مدلهای زبان بزرگ (LLM) روی دستگاههایی با رم محدود ارائه میدهد. این مقاله نشان میدهد که چگونه این شرکت میتواند «پارامترهای مدل» را ذخیره کرده و در صورت نیاز، به جای بارگذاری کل مدل در رم، بخشی از آنها را در رم دستگاه بارگذاری کند.

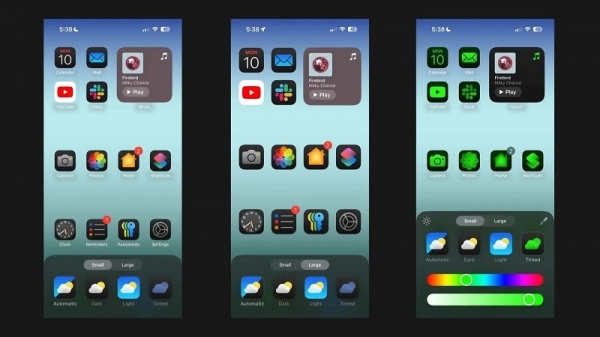

اپل به دنبال کمک به آیفونهای قدیمیتر با رم کمتر برای اجرای هوش مصنوعی عمومی است

این مقاله ادعا میکند که این روش امکان اجرای مدلهایی را فراهم میکند که به دو برابر رم مورد نیاز آیفون نیاز دارند و در عین حال سرعت استنتاج ۴-۵ برابر و ۲۰-۲۵ برابر را در مقایسه با روشهای بارگذاری ساده به ترتیب روی CPU و GPU تضمین میکنند.

استقرار هوش مصنوعی مصنوعی در دستگاهی با رم بیشتر، مزیت بزرگی خواهد بود زیرا سرعت خواندن/نوشتن سریعتری را فراهم میکند. سرعت برای هوش مصنوعی درون دستگاهی مهم است و زمان استنتاج بسیار سریعتری را فراهم میکند زیرا کاربران لزوماً مجبور نیستند دهها ثانیه (یا بیشتر) برای پاسخ یا نتیجه نهایی منتظر بمانند. همه اینها به این معنی است که یک دستیار هوش مصنوعی درون دستگاهی میتواند به طور بالقوه با سرعت مکالمه اجرا شود، تصاویر/متن را بسیار سریعتر تولید کند، مقالات را سریعتر خلاصه کند و غیره. اما راه حل اپل به این معنی است که کاربران لزوماً برای افزایش سرعت پاسخگویی به وظایف هوش مصنوعی درون دستگاهی به رم زیادی نیاز ندارند.

رویکرد اپل میتواند به آیفونهای قدیمی و جدید اجازه دهد تا ویژگیهای هوش مصنوعی مصنوعی را مستقیماً روی دستگاههای خود ارائه دهند. این مهم است زیرا آیفونهای اپل معمولاً رم کمتری نسبت به گوشیهای اندرویدی رده بالا ارائه میدهند. به عنوان مثال، سری آیفون ۱۱ فقط ۴ گیگابایت رم ارائه میدهد، در حالی که حتی آیفون ۱۵ معمولی فقط ۶ گیگابایت رم دارد.

اپل تنها شرکت موبایلی نیست که روی کوچکسازی LLM کار میکند. تراشههای پرچمدار اخیر کوالکام و مدیاتک هر دو از دقت INT4 برای کوچکسازی این مدلها پشتیبانی میکنند. در هر صورت، شرکتها در تلاشند تا راههای جدیدی برای کاهش الزامات سیستم برای هوش مصنوعی روی دستگاه پیدا کنند و حتی به گوشیهای رده پایین نیز اجازه دهند این ویژگی را ارائه دهند.

لینک منبع

![[عکس] رئیس مجلس ملی، تران تان مان، از سفرای خارجی که برای خداحافظی آمده بودند، استقبال کرد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761820977744_ndo_br_1-jpg.webp)

![[عکس] سومین کنگره تقلید میهنی کمیسیون مرکزی امور داخلی](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761831176178_dh-thi-dua-yeu-nuoc-5076-2710-jpg.webp)

![[عکس] دبیرکل تو لام با تونی بلر، نخست وزیر سابق بریتانیا، دیدار کرد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761821573624_tbt-tl1-jpg.webp)

![[عکس] دبیرکل تو لام در کنفرانس اقتصادی سطح بالای ویتنام-بریتانیا شرکت میکند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825773922_anh-1-3371-jpg.webp)

![[عکس] صحنهای تأثیرگذار از هزاران نفر که در حال نجات خاکریز از آب خروشان هستند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825173837_ndo_br_ho-de-3-jpg.webp)

نظر (0)