پردازنده گرافیکی (GPU) مغز کامپیوتر هوش مصنوعی است

به عبارت ساده، واحد پردازش گرافیک (GPU) به عنوان مغز کامپیوتر هوش مصنوعی عمل میکند.

همانطور که ممکن است بدانید، واحد پردازش مرکزی (CPU) مغز کامپیوتر است. مزیت GPU این است که یک CPU تخصصی است که میتواند محاسبات پیچیده را انجام دهد. سریعترین راه برای انجام این کار، استفاده از گروههایی از GPUها برای حل یک مسئله مشابه است. با این حال، آموزش یک مدل هوش مصنوعی هنوز هم میتواند هفتهها یا حتی ماهها طول بکشد. پس از ساخت، در یک سیستم کامپیوتری front-end قرار میگیرد و کاربران میتوانند از مدل هوش مصنوعی سوالاتی بپرسند، فرآیندی که استنتاج نامیده میشود.

یک کامپیوتر هوش مصنوعی حاوی چندین پردازنده گرافیکی (GPU)

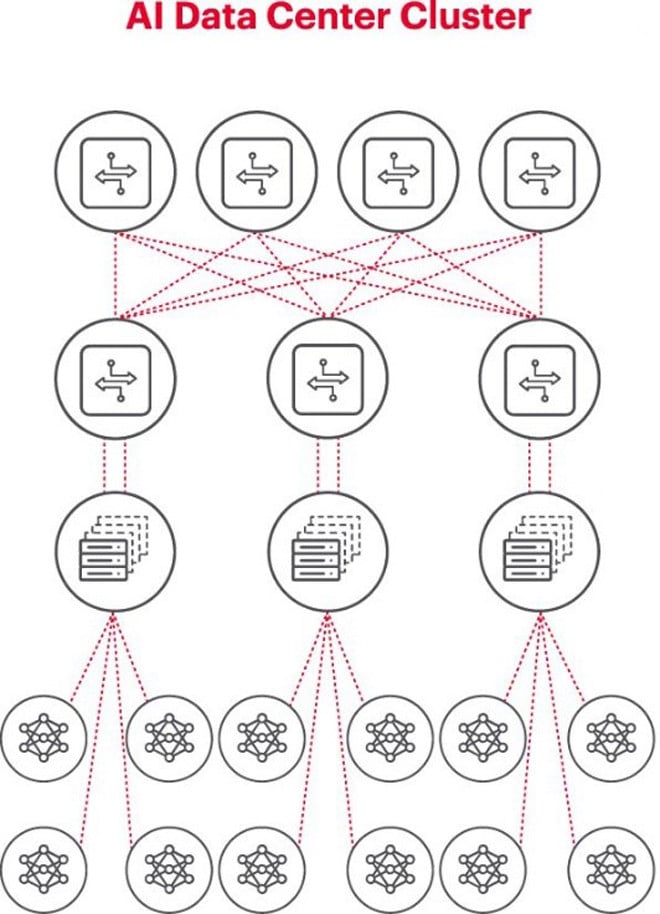

بهترین معماری برای مسائل هوش مصنوعی، استفاده از خوشهای از پردازندههای گرافیکی (GPU) در یک رک است که به یک سوئیچ در بالای رک متصل است. چندین رک پردازنده گرافیکی (GPU) میتوانند در یک سلسله مراتب شبکه به هم متصل شوند. با پیچیدهتر شدن مسئله، الزامات پردازنده گرافیکی (GPU) افزایش مییابد و برخی پروژهها ممکن است نیاز به استقرار خوشههایی از هزاران پردازنده گرافیکی (GPU) داشته باشند.

هر خوشه هوش مصنوعی یک شبکه کوچک است

هنگام ساخت یک خوشه هوش مصنوعی، لازم است یک شبکه کامپیوتری کوچک برای اتصال راهاندازی شود و به پردازندههای گرافیکی اجازه دهد تا با هم کار کنند و دادهها را به طور موثر به اشتراک بگذارند.

شکل بالا یک خوشه هوش مصنوعی را نشان میدهد که در آن دایرههای پایین نشاندهنده گردشهای کاری اجرا شده روی GPUها هستند. GPUها به سوئیچهای بالای رک (ToR) متصل میشوند. سوئیچهای ToR همچنین به سوئیچهای ستون فقرات شبکه که در بالای نمودار نشان داده شده است متصل میشوند و سلسله مراتب شبکه واضح مورد نیاز را هنگام استفاده از چندین GPU نشان میدهند.

شبکهها گلوگاه استقرار هوش مصنوعی هستند

پاییز گذشته، در اجلاس جهانی پروژه رایانه باز (OCP)، جایی که نمایندگان در حال کار بر روی ساخت نسل بعدی زیرساختهای هوش مصنوعی بودند، نماینده لوی نگوین از شرکت فناوری مارول نکتهای کلیدی را مطرح کرد: «شبکهسازی، تنگنای جدید است.»

از نظر فنی، تأخیر زیاد بستهها یا از دست رفتن بستهها به دلیل ازدحام شبکه میتواند باعث ارسال مجدد بستهها شود و زمان تکمیل کار (JCT) را به میزان قابل توجهی افزایش دهد. در نتیجه، میلیونها یا دهها میلیون دلار GPU توسط کسبوکارها به دلیل سیستمهای هوش مصنوعی ناکارآمد هدر میرود و برای کسبوکارها هم از نظر درآمد و هم از نظر زمان عرضه به بازار هزینه دارد.

اندازهگیری شرط کلیدی برای عملکرد موفقیتآمیز شبکههای هوش مصنوعی است

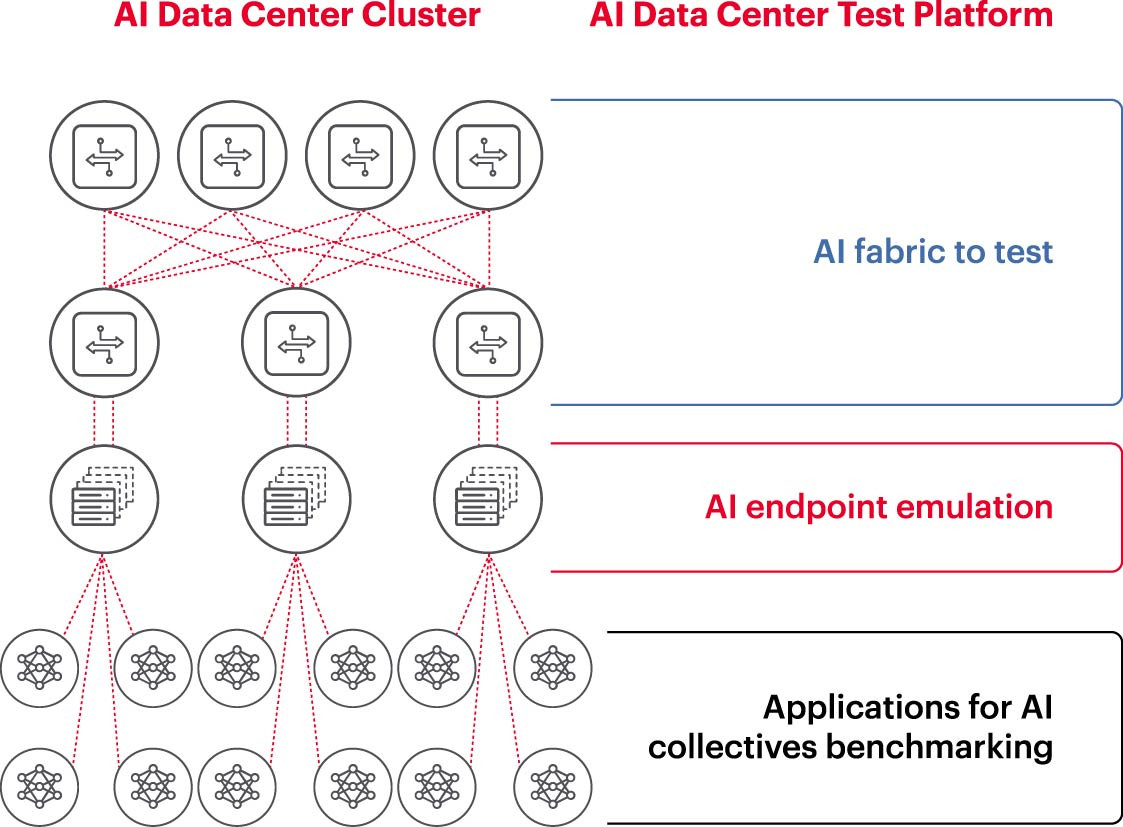

برای اجرای مؤثر یک خوشه هوش مصنوعی، باید بتوان از پردازندههای گرافیکی (GPU) به طور کامل استفاده کرد تا زمان آموزش کوتاه شود و مدل یادگیری به کار گرفته شود تا بازگشت سرمایه به حداکثر برسد. بنابراین، آزمایش و ارزیابی عملکرد خوشه هوش مصنوعی ضروری است (شکل 2). با این حال، این کار آسان نیست، زیرا از نظر معماری سیستم، تنظیمات و روابط زیادی بین پردازندههای گرافیکی (GPU) و ساختارهای شبکه وجود دارد که برای حل مسئله باید یکدیگر را تکمیل کنند.

این امر چالشهای زیادی را در اندازهگیری شبکههای هوش مصنوعی ایجاد میکند:

- دشواری در بازتولید کل شبکههای تولید در آزمایشگاه به دلیل محدودیتهای هزینه، تجهیزات، کمبود مهندسان ماهر هوش مصنوعی شبکه، فضا، برق و دما.

- اندازهگیری روی سیستم تولید، ظرفیت پردازش موجود خود سیستم تولید را کاهش میدهد.

- دشواری در بازتولید دقیق مسائل به دلیل تفاوت در مقیاس و دامنه مسائل.

- پیچیدگی نحوه اتصال جمعی پردازندههای گرافیکی (GPU).

برای پرداختن به این چالشها، کسبوکارها میتوانند زیرمجموعهای از تنظیمات پیشنهادی را در محیط آزمایشگاهی آزمایش کنند تا معیارهای کلیدی مانند زمان تکمیل کار (JCT)، پهنای باندی که تیم هوش مصنوعی میتواند به آن دست یابد را محک بزنند و آن را با میزان استفاده از پلتفرم سوئیچینگ و میزان استفاده از حافظه پنهان مقایسه کنند. این محکزنی به یافتن تعادل مناسب بین حجم کار پردازنده گرافیکی/پردازش و طراحی/تنظیم شبکه کمک میکند. پس از رضایت از نتایج، معماران کامپیوتر و مهندسان شبکه میتوانند این تنظیمات را به مرحله تولید برده و نتایج جدید را اندازهگیری کنند.

آزمایشگاههای تحقیقاتی شرکتها، مؤسسات دانشگاهی و دانشگاهها در تلاشند تا هر جنبهای از ساخت و بهرهبرداری مؤثر از شبکههای هوش مصنوعی را تجزیه و تحلیل کنند تا چالشهای کار بر روی شبکههای بزرگ را برطرف کنند، به خصوص با توجه به اینکه بهترین شیوهها همچنان در حال تکامل هستند. این رویکرد مشارکتی و تکرارپذیر تنها راه برای شرکتها است تا اندازهگیریهای تکرارپذیر را انجام دهند و به سرعت سناریوهای «چه میشود اگر» را که پایه و اساس بهینهسازی شبکهها برای هوش مصنوعی هستند، آزمایش کنند.

(منبع: Keysight Technologies)

منبع: https://vietnamnet.vn/ket-noi-mang-ai-5-dieu-can-biet-2321288.html

![[عکس] اختتامیه چهاردهمین کنفرانس سیزدهمین کمیته مرکزی حزب](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762404919012_a1-bnd-5975-5183-jpg.webp)

![[عکس] نخست وزیر فام مین چین، هیئت نمایندگی شرکت بینالمللی تولید نیمههادی (SEMI) را به حضور پذیرفت.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762434628831_dsc-0219-jpg.webp)

![[ویدئو] سومین جایزه ملی مطبوعات «به خاطر توسعه فرهنگ ویتنامی»](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/06/1762444834490_giai-bao-chi-vh-3937-jpg.webp)

نظر (0)