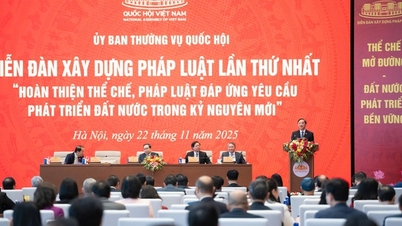

به گفته نماینده دونگ نگوک با، اعلام قانون هوش مصنوعی (AI) به ایجاد یک مبنای قانونی یکپارچه و هماهنگ کمک خواهد کرد که هم توسعه را ارتقا میدهد و هم مدیریت ریسک مؤثر در تحقیق، توسعه و استفاده از هوش مصنوعی را تضمین میکند و الزامات توسعه اجتماعی -اقتصادی در عصر دیجیتال را برآورده میسازد.

نماینده گفت که سازمان تدوینکننده بسیار فعال و مسئولیتپذیر بوده و برای تکمیل پیشنویس قانون، نظرات بسیاری از سازمان بررسیکننده و سازمانهای مربوطه را مطالعه و دریافت کرده است. نماینده از بسیاری از مطالبی که در پیشنویس جدید جذب و اصلاح شدهاند، بسیار قدردانی کرد.

در عین حال، توصیه میشود که به بررسی و تنظیم ادامه داده شود، به ویژه اطمینان از سازگاری و هماهنگی با قوانین مرتبط مانند قانون مدنی، قانون کیفیت محصولات و کالاها، قانون مالکیت معنوی، قانون فناوری پیشرفته، قانون استانداردها و مقررات فنی؛ اطمینان از تفکر قانونگذاری جدید و تکنیکهای قانونگذاری.

علاوه بر این، معاون دونگ نگوک با نیز توصیههای خاصی ارائه داد.

پیشنویس قانون هوش مصنوعی (مواد ۷ تا ۱۱) طبقهبندی مدیریت ریسک سیستمهای هوش مصنوعی را به چهار سطح تصریح میکند: ریسک پایین، ریسک متوسط، ریسک بالا و ریسک غیرقابل قبول.

معاون با گفت که با توجه به ماهیت هوش مصنوعی، اگر سیستم هوش مصنوعی نوعی محصول یا کالا در نظر گرفته شود، مفاد پیشنویس قانون غیرمنطقی و متناقض است و با مفاد قانون کیفیت محصول و کالا (تقسیم محصولات و کالاها به 3 گروه کمخطر، باخطر متوسط و پرخطر) سازگار نیست.

بنابراین، توصیه میشود که سازمان تدوینکننده، سیستمهای هوش مصنوعی را به دقت بررسی و طبقهبندی کند تا با قانون کیفیت محصولات و کالاها (۳ سطح ریسک) سازگار باشد تا پیادهسازی آن تسهیل شود.

«در مورد یک سیستم هوش مصنوعی با « ریسک غیرقابل قبول»، این باید به عنوان یک فعالیت ممنوعه در نظر گرفته شود و به طور خاص به عنوان یک ممنوعیت در پیشنویس قانون تنظیم شود. لازم است اقدامات ممنوعه دیگری در تحقیق، توسعه و استفاده از هوش مصنوعی (به عنوان مثال: استفاده از هوش مصنوعی برای نقض امنیت ملی، استفاده از هوش مصنوعی برای تبعیض بر اساس دادههای بیومتریک و غیره) اضافه شود تا از کامل بودن و سختگیری اطمینان حاصل شود.» - معاون با پیشنهاد داد.

در خصوص مسئولیت جبران خسارت ناشی از سیستمهای هوش مصنوعی، در بند الف، بند ۳، ماده ۳۰ پیشنویس قانون هوش مصنوعی تصریح شده است: «برای سیستمهای هوش مصنوعی پرخطر: در صورت خسارت ناشی از تخلفات در مدیریت و استفاده از سیستمهای هوش مصنوعی، سازمان یا فرد متخلف باید طبق مفاد قانون مدنی خسارت را جبران کند».

طبق بند ۱ ماده ۶۰۱ قانون مدنی، منابع خطر شدید شامل وسایل نقلیه موتوری، سیستمهای انتقال قدرت، کارخانههای صنعتی فعال، سلاحها، مواد منفجره، مواد قابل اشتعال، مواد سمی، مواد رادیواکتیو، حیوانات وحشی و سایر منابع خطر شدید طبق قانون میشود.

به گفته معاون دونگ نگوک با، قانون مدنی بین جبران خسارت ناشی از یک منبع خطرناک و سایر موارد، به ویژه در مورد عامل تقصیر در تعیین مسئولیت جبران خسارت، تمایز قائل میشود. با مفاد پیشنویس قانون هوش مصنوعی در بند الف، بند ۳، ماده ۳۰ فوق، مشخص نیست که آیا یک «سیستم هوش مصنوعی پرخطر» «منبع خطرناک» است یا خیر. در همین حال، از نظر ماهیت فنی و فناوری، یک سیستم هوش مصنوعی پرخطر ماهیت یک منبع خطرناک را دارد.

بنابراین، نماینده پیشنهاد داد که مفاد بند ۳ ماده ۳۰ بند الف پیشنویس قانون هوش مصنوعی در راستای تعریف سیستمهای هوش مصنوعی پرخطر به عنوان منابع خطر شدید، مورد مطالعه و بازنگری قرار گیرد تا مبنایی برای اعمال مقررات مربوط به مسئولیت جبران خسارات ناشی از سیستمهای هوش مصنوعی طبق مفاد قانون مدنی وجود داشته باشد.

در مورد نوآوری در تفکر و تکنیکهای قانونگذاری، معاون با پیشنهاد بازنگری داد تا اطمینان حاصل شود که قانون هوش مصنوعی، موضوعات تحت اختیار دولت را تنظیم نمیکند. به طور خاص، در فصل ششم (بازرسی، بررسی و رسیدگی به تخلفات)، عدم تنظیم بازرسیهای تخصصی و واگذاری آنها به دولت برای تنظیم طبق اختیاراتش را در نظر بگیرید. فصل هفتم (مدیریت دولتی هوش مصنوعی) را بررسی کنید، مقررات تحت اختیار دولت مانند مسئولیتهای مدیریت دولتی وزارتخانهها را حذف کنید... پیشنهاد ادغام فصل ششم در فصل هفتم را بدهید، زیرا بازرسی، بررسی و رسیدگی به تخلفات اساساً محتوای خاص مدیریت دولتی هوش مصنوعی هستند.

سیو هونگ، معاون رئیس هیئت نمایندگی مجلس ملی استان گیا لای، به مقررات مربوط به اخلاق و مسئولیت در فعالیتهای هوش مصنوعی در فصل ۵ ابراز علاقه کرد.

به گفته نماینده هونگ، در حال حاضر، بسیاری از مدلهای هوش مصنوعی با جمعآوری دادهها، آثار هنری و محتوای خلاقانه از اینترنت و بدون رضایت نویسنده آموزش میبینند و هیچ مکانیسمی برای جبران خسارت به نویسنده وجود ندارد. این امر خطر بالقوه نقض حقوق مالکیت معنوی تولیدکنندگان محتوا را به همراه دارد.

بنابراین، نماینده پیشنهاد داد که آژانس تدوینکننده، افزودن آییننامهای به فصل ۵ را در نظر بگیرد که بر اساس آن، توسعهدهندگان سیستمهای هوش مصنوعی باید سازوکار مجوز مشخصی داشته باشند و به صاحبان محتوا اجازه دهند که با استفاده از کارشان برای اهداف آموزشی هوش مصنوعی موافقت یا مخالفت کنند. در عین حال، تحقیقات باید سازوکاری برای جبران خسارت یا تقسیم سود برای نویسندگانی که از کارشان در آموزش مدل هوش مصنوعی استفاده میشود، ایجاد کند.

معاون نگوین ون کان (عضو هیئت نمایندگی مجلس ملی استان گیا لای) با شرکت در این بحث، این موضوع را از دیدگاه یک مصرفکننده مطرح کرد که هنگام استفاده از محصولات "هوش مصنوعی" نگران است که اگر حادثهای خارج از کنترل رخ دهد و باعث خسارت شود، چه کسی مسئول جبران خسارت خواهد بود.

به گفته معاون کان، پیشنویس قانون هوش مصنوعی اصطلاح «محصولات مبتنی بر فناوری هوش مصنوعی» را توضیح نمیدهد. مصرفکنندگان فقط محصول را میشناسند، اما فقط محققان و دانشمندان میدانند که فناوری هوش مصنوعی چیست.

معاون کان پیشنهاد داد که هوش مصنوعی به طور واضح به عنوان یک محصول ورودی، یک ابزار، یک محصول نیمه تمام یا یک محصول نهایی متمایز شود. از آنجا، مقررات خاصی در مورد مسئولیت تأمین کننده وجود خواهد داشت.

«برای مثال، هوش مصنوعی فقط در محصول ادغام میشود. وقتی خسارتی رخ میدهد، فروشنده آن محصول باید مسئولیت کامل را بر عهده بگیرد و نمیتواند آن را به گردن هوش مصنوعی بیندازد، زیرا شرکتی که هوش مصنوعی را تولید میکند آن را به من میفروشد، من هیچ کنترلی بر آن ندارم.» - معاون کان تحلیل کرد.

منبع: https://baogialai.com.vn/viec-ban-hanh-luat-tri-tue-nhan-tao-la-van-de-cap-bach-post573129.html

نظر (0)