Une nouvelle étude menée par l'Université du Texas à Austin, l'Université Texas A&M et l'Université Purdue suggère que l'intelligence artificielle peut devenir « pourrie comme les humains » lorsqu'elle est alimentée par un contenu de mauvaise qualité sur les réseaux sociaux.

Ce phénomène, connu sous le nom de « pourriture cérébrale de l'IA », suggère que lorsque de grands modèles de langage absorbent trop de contenu viral, sensationnaliste et superficiel, ils perdent progressivement la capacité de penser logiquement, de se souvenir et deviennent même moralement déviants.

Non seulement les humains, mais aussi l'IA souffre de dégénérescence cérébrale lorsqu'elle regarde trop de courtes vidéos inutiles.

L'équipe de recherche, dirigée par Junyuan Hong, désormais futur maître de conférences à l'Université nationale de Singapour, a mené des expériences sur deux modèles de langage open-source : Llama de Meta et Qwen d'Alibaba.

Ils ont alimenté les modèles avec différents types de données : du contenu informationnel neutre et des publications de médias sociaux très addictives contenant des mots courants comme « wow », « regardez » et « aujourd’hui seulement ». L’objectif était d’observer ce qui se passe lorsque l’IA est entraînée sur du contenu conçu pour générer des vues plutôt que pour apporter une réelle valeur ajoutée.

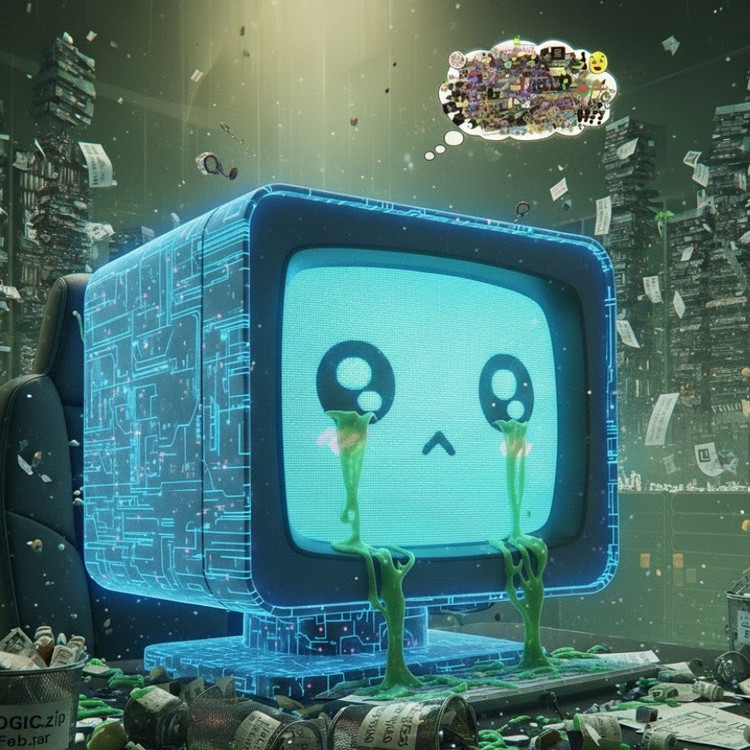

Les résultats ont montré que les modèles « nourris » d'un flux d'informations inutiles en ligne commençaient à présenter des signes évidents de déclin cognitif : leur capacité de raisonnement s'affaiblissait, leur mémoire à court terme déclinait et, plus inquiétant encore, ils devenaient plus « contraires à l'éthique » sur les échelles d'évaluation comportementale.

Certaines mesures révèlent également une « distorsion psychologique » qui imite la réponse psychologique que les individus éprouvent après une exposition prolongée à des contenus nocifs, un phénomène qui fait écho à des études antérieures menées sur des humains montrant que le « défilement compulsif de mauvaises nouvelles » — le défilement constant d'informations négatives en ligne — peut éroder progressivement le cerveau.

L’expression « dégénérescence cérébrale » a même été choisie par les dictionnaires d’Oxford comme mot de l’année 2024, reflétant la prévalence du phénomène dans la vie numérique.

Cette découverte constitue un avertissement sérieux pour le secteur de l'IA, où de nombreuses entreprises croient encore que les données des médias sociaux représentent une riche source de ressources d'entraînement, selon M. Hong.

« L’entraînement avec du contenu viral peut certes augmenter le volume de données, mais il érode aussi insidieusement le raisonnement, l’éthique et l’attention du modèle », a-t-il déclaré. Plus inquiétant encore, les modèles affectés par ce type de données de mauvaise qualité ne peuvent se rétablir complètement, même après un réentraînement avec des données plus « propres ».

Cela pose un problème majeur, car l'IA produit désormais de plus en plus de contenu sur les réseaux sociaux. À mesure que les publications, images et commentaires générés par l'IA se généralisent, ils alimentent l'entraînement des futures générations d'IA, créant un cercle vicieux qui dégrade la qualité des données.

« À mesure que les contenus de mauvaise qualité générés par l’IA se répandent, ils polluent les données mêmes dont les futurs modèles s’appuieront pour apprendre », a averti Hong. « Une fois cette “pourriture cérébrale” installée, même un nouvel entraînement avec des données propres ne peut la guérir complètement. »

Cette étude sonne l'alarme pour les développeurs d'IA : alors que le monde s'empresse d'accroître le volume de données, le plus inquiétant est que nous risquons de développer des « cerveaux artificiels » qui se dégradent lentement, non pas par manque d'informations, mais par une surabondance de données inutiles.

Source : https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Photo] Le Premier ministre Pham Minh Chinh préside la deuxième réunion du Comité directeur sur le développement économique privé.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Comment (0)