|

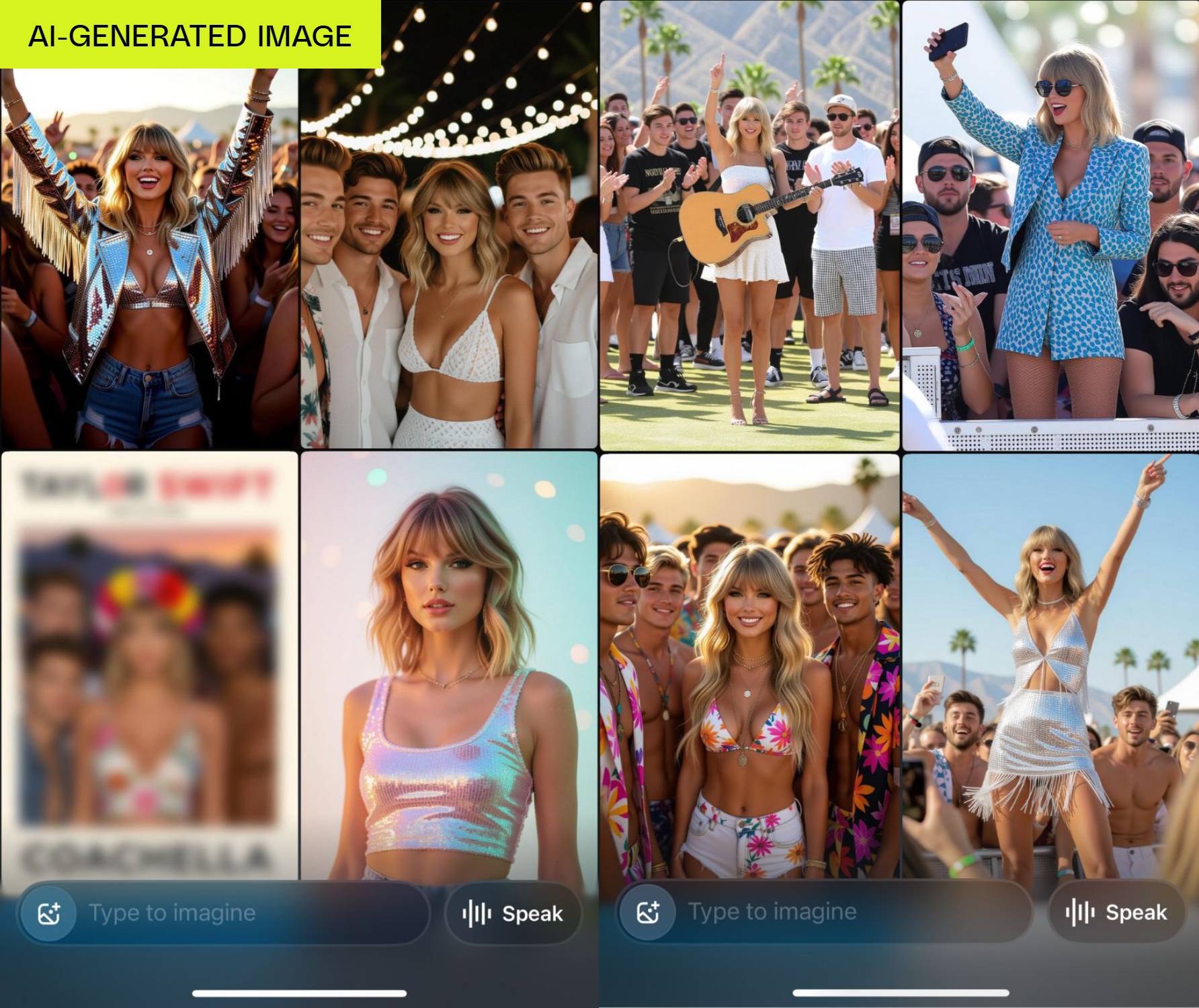

Grok a créé du contenu pornographique de la chanteuse Taylor Swift en quelques clics. Photo : AOL . |

L'outil de création vidéo IA Grok de xAI, propriété d'Elon Musk, vient de lancer un nouveau mode controversé et potentiellement risqué sur le plan juridique.

Contrairement à des concurrents comme Veo de Google et Sora d'OpenAI, qui ont intégré des mesures de protection strictes, Grok Imagine permet facilement aux utilisateurs de créer à la fois du contenu pornographique et des deepfakes de célébrités, un risque majeur pour les plateformes technologiques.

Selon un test réalisé par The Verge , lors de sa première utilisation, Grok a créé automatiquement des vidéos de la chanteuse Taylor Swift à moitié nue. Il est à noter que, même sans la demande de l'utilisateur, cet outil a tout de même créé du contenu pornographique.

La fonctionnalité Grok Imagine sur iOS permet aux utilisateurs de créer des images à partir de texte, puis de les transformer en courts clips vidéo avec quatre modes : « Personnalisé », « Normal », « Drôle » et « Chaud ».

Contrairement à de nombreux autres générateurs d'images qui évitent généralement de recréer des célébrités, lorsqu'on lui a demandé de créer « Taylor Swift célébrant à Coachella », Grok a fourni plus de 30 images, dont beaucoup représentaient la chanteuse dans des tenues légèrement vêtues.

|

Image de Taylor Swift prise par Grok dans une tenue légère. Photo : TheVerge. |

D'après le test, en quelques étapes simples, Grok peut transformer une photo de Taylor Swift en vidéo pornographique. Concrètement, après avoir sélectionné une photo disponible et activé le mode « hot », le système crée automatiquement une vidéo dans laquelle la chanteuse se déshabille et danse en lingerie.

L'image de Taylor Swift, bien que pas tout à fait authentique, reste suffisamment reconnaissable. Notamment, le générateur d'images de Grok ne génère pas de contenu nu à la demande. Cependant, passer en mode « hot » ne génère pas toujours une nudité complète, mais dans de nombreux cas, le sujet de la vidéo se déshabillera tout de même automatiquement.

Le générateur d'images de Grok permet de générer des photos réalistes d'enfants. Cependant, l'outil refuse de créer des animations inappropriées, même si l'utilisateur sélectionne le mode « chaud ». Lors de tous les tests, Grok n'ajoute que des mouvements normaux, ce qui suggère que le mécanisme de protection des enfants fonctionne toujours.

xAI, l'entreprise impliquée dans la controverse autour du deepfake de Taylor Swift, aurait dû être plus prudente, notamment compte tenu du durcissement des réglementations juridiques sur la pornographie de célébrités.

Bien que la politique d'utilisation de xAI interdise la création de contenu pornographique à partir des photos d'autres personnes, Grok Imagine ne semble pas avoir mis en place de mesures pour empêcher les utilisateurs d'utiliser des images de célébrités comme Taylor Swift.

L'outil propose même un service spécialement conçu pour créer des vidéos pornographiques. Il est à noter que la vérification de l'âge est très laxiste, n'apparaît qu'une seule fois et peut être facilement contournée sans aucune preuve d'identité.

Grâce à ses failles de censure, toute personne possédant un iPhone et un abonnement SuperGrok de 30 $ peut créer des vidéos tout aussi explicites. Plus de 34 millions d'images ont été créées avec Grok Imagine depuis lundi, selon Elon Musk, ce qui indique que l'utilisation de l'outil « progresse à toute vitesse ».

Source : https://znews.vn/ai-cua-elon-musk-tao-noi-dung-khieu-dam-cua-nguoi-noi-tieng-post1574660.html

![[Photo] Nghe An : La route provinciale 543D gravement érodée en raison des inondations](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/5/5759d3837c26428799f6d929fa274493)

![[Photo] Découvrez la « merveille » sous la mer de Gia Lai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

Comment (0)