Date de mise à jour : 31/03/2024 05:42:42

Selon un article de blog d'OpenAI partageant les résultats d'un test à petite échelle du « Voice Engine », l'outil peut essentiellement cloner la voix d'une personne sur la base d'un échantillon audio de 15 secondes.

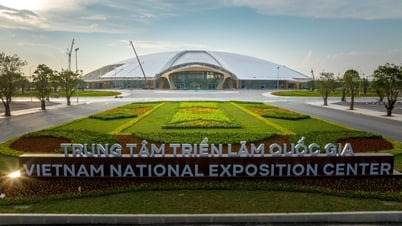

Photo : OpenAI

OpenAI vient de dévoiler un outil de clonage vocal, mais il sera maintenu sous contrôle strict jusqu'à ce que des mesures de protection soient mises en place pour empêcher les faux sons d'induire les auditeurs en erreur.

OpenAI admet que la génération de voix présente de sérieux risques, surtout en année électorale. Cependant, la société a déclaré qu'elle travaillait avec des partenaires nationaux et internationaux du gouvernement, des médias, du divertissement, de l'éducation , de la société civile et d'autres secteurs pour recueillir des commentaires afin de construire et de développer cet outil en toute sécurité.

OpenAI affirme avoir mis en œuvre une série de mesures de sécurité, notamment le marquage de l'origine de tout audio généré par Voice Engine et la surveillance active de la manière dont l'outil est utilisé.

Les chercheurs en désinformation s’inquiètent des risques d’abus massifs des applications basées sur l’IA dans une année électorale cruciale, car les outils de clonage vocal sont de plus en plus bon marché, faciles à utiliser et difficiles à tracer.

Un exemple est un appel généré par l’IA, une idée originale d’un lobbyiste du membre du Congrès du Minnesota Dean Phillips, qui ressemble au président Joe Biden exhortant les gens à ne pas voter lors des primaires du New Hampshire en janvier 2024.

L'incident a suscité des inquiétudes parmi les experts concernant une vague de désinformation deepfake (faux audio ou vidéo ) générée par l'IA lors de la course à la Maison Blanche de 2024 et d'autres élections mondiales majeures cette année.

Selon VNA/NDO

Source

![[Photo] Le secrétaire général To Lam préside une séance de travail avec la Commission centrale des affaires intérieures](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/22/3b7790f499da45b2803d8ae253207ef1)

![[Photo] Le Premier ministre Pham Minh Chinh préside la réunion spéciale du gouvernement sur l'élaboration des lois en mai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/22/1c880aae96fd4e0894abc47a46fe19ba)

![[Podcast] Semaine de présentation de plus de 500 produits OCOP à Hanoi](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/22/d144aac2416744718388dbae3260e7fd)

Comment (0)