तदनुसार, कृत्रिम बुद्धिमत्ता (एआई) द्वारा निर्मित पेंटागन के पास हुए विस्फोट की एक तस्वीर 22 मई को अमेरिकी सोशल नेटवर्क पर साझा की गई, जिससे शेयर बाजार में कुछ ही समय में भारी गिरावट आई, जिससे एआई से उत्पन्न होने वाली फर्जी खबरों को लेकर चिंताएं बढ़ गईं।

|

| पेंटागन के निकट विस्फोट की एआई द्वारा निर्मित नकली तस्वीर। |

ऑनलाइन तथ्य-जांच समूह, बेलिंगकैट के निक वाटर्स ने तुरंत इस तस्वीर में कुछ उल्लेखनीय खामियाँ बताईं। पहली बात, इस घटना की पुष्टि करने वाला कोई प्रत्यक्षदर्शी नहीं है। तस्वीर में दिख रही इमारत पेंटागन जैसी भी नहीं दिखती। कुछ असामान्य विवरण, जैसे कि प्रमुख लैंपपोस्ट और फुटपाथ से बाहर निकले काले स्तंभ, इस बात के संकेत हैं कि तस्वीर असली नहीं है।

मिडजर्नी, डैल-ई 2 और स्टेबल डिफ्यूज़न जैसे कई आर्टिफिशियल इंटेलिजेंस (एआई) पुनर्निर्माण उपकरण हैं जो जीवंत चित्र बना सकते हैं। हालाँकि, ये उपकरण डेटा की कमी होने पर उसकी पूर्ति कर देंगे।

अल जजीरा ने प्रमुख घटनाओं की एआई-जनित छवियों और वास्तविक तस्वीरों के बीच अंतर करने के लिए कुछ उपाय सुझाए हैं, जो इस प्रकार हैं:

- किसी विस्फोट या किसी बड़ी घटना की स्थिति में, आमतौर पर कई लोगों और कई दृष्टिकोणों से तथ्यात्मक जानकारी प्राप्त होगी।

- सामग्री कौन पोस्ट कर रहा है? वे कहाँ स्थित हैं और कार्यक्रम कहाँ हो रहा है? वे किन अकाउंट्स को फ़ॉलो कर रहे हैं और उन्हें कौन फ़ॉलो कर रहा है? क्या आप उनसे संपर्क कर सकते हैं या उनसे बात कर सकते हैं?

- चित्रों और परिवेश का विश्लेषण करें: चित्र में संकेत ढूंढें, जैसे कि आस-पास के स्थान, यातायात संकेत आदि, ताकि यह निर्धारित करने में आपको मदद मिल सके कि कोई घटना कब या कहाँ घटित हो सकती है।

- लोगों की तस्वीरें लेते समय, उनकी आँखों, हाथों और सामान्य मुद्रा पर ध्यान दें। एआई द्वारा बनाए गए वीडियो , जो इंसानों की नकल करते हैं, जिन्हें डीप फेक कहा जाता है, उनमें पलकें झपकाने की समस्या होती है क्योंकि ज़्यादातर प्रशिक्षण डेटासेट में बंद आँखों वाले चेहरे नहीं होते। हाथ चीज़ों को ठीक से पकड़ नहीं पाते।

- एआई द्वारा निर्मित चित्रों में लोगों की त्वचा प्रायः चिकनी होगी, तथा यहां तक कि उनके बाल और दांत भी बिल्कुल सही होंगे।

[विज्ञापन_2]

स्रोत

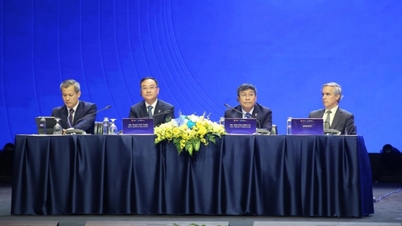

![[फोटो] महासचिव टो लाम ने वियतनाम अध्ययन पर अंतर्राष्ट्रीय सम्मेलन में भाग लेने वाले प्रतिनिधिमंडल का स्वागत किया](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

![[फोटो] नहान दान अखबार 14वीं राष्ट्रीय पार्टी कांग्रेस के मसौदा दस्तावेजों को प्रदर्शित करता है और उन पर टिप्पणियां मांगता है](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761470328996_ndo_br_bao-long-171-8916-jpg.webp)

![[फोटो] चीन के हुनान में लिउयांग आतिशबाजी महोत्सव का आनंद लें](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761463428882_ndo_br_02-1-my-1-jpg.webp)

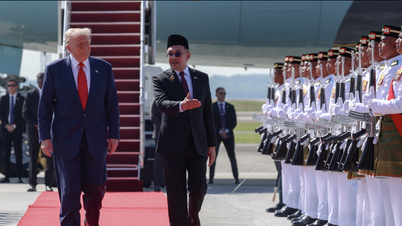

![[फोटो] प्रधानमंत्री फाम मिन्ह चीन्ह 47वें आसियान शिखर सम्मेलन के उद्घाटन में शामिल हुए](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

टिप्पणी (0)