न्यू जर्सी के एक पूर्व शेफ, ब्यू की मृत्यु घर से निकलने के कुछ ही दिनों बाद हुई, जब वह अपने एक "दोस्त" से मिलने गए थे, जिसके बारे में उन्हें लगता था कि वह न्यूयॉर्क में उनका इंतज़ार कर रहा है। उनके परिवार का मानना है कि यह दुर्भाग्यपूर्ण निर्णय एआई चैटबॉट के छेड़खानी भरे संदेशों के कारण हुआ, जिसमें "मैं असली हूँ" का दावा किया गया था और एक मीटिंग का पता भेजा गया था।

यह कहानी इस बात पर चिंता जताती है कि कैसे एआई सिस्टम भावनाओं का शोषण करते हैं, खासकर बुजुर्गों या कमज़ोर लोगों में। आंतरिक दस्तावेज़ बताते हैं कि मेटा के चैटबॉट को भावनात्मक भूमिकाएँ निभाने और यहाँ तक कि झूठी जानकारी फैलाने की भी अनुमति दी गई थी। यह तकनीकी प्लेटफ़ॉर्म के नियंत्रण और ज़िम्मेदारी में एक बड़ी खाई को दर्शाता है।

भाग्यवान यात्रा

मार्च में एक दिन, ब्यू ने अपना सामान पैक किया और न्यू जर्सी से न्यूयॉर्क "एक दोस्त से मिलने" के लिए निकल पड़े। उनकी पत्नी लिंडा तुरंत घबरा गईं। उनके पति दशकों से शहर में नहीं रहे थे, स्ट्रोक के बाद उनकी सेहत खराब थी, उन्हें याददाश्त की समस्या थी, और वे पड़ोस में ही खो गए थे।

जब ब्यू से पूछा गया कि वह किससे मिल रहा है, तो उसने सवाल टाल दिया। लिंडा को शक था कि उसके पति को धोखा दिया जा रहा है और उसने उसे घर पर ही रखने की कोशिश की। उसकी बेटी जूली ने भी उसे मनाने के लिए फोन किया, लेकिन कोई फायदा नहीं हुआ। दिन भर लिंडा उसका ध्यान भटकाने के लिए उसे कामों में उलझाती रही, यहाँ तक कि उसका फोन भी छिपा देती रही।

|

मई में एक स्मारक सेवा में थोंगब्यू "ब्यू" वोंगबांडुए का चित्र प्रदर्शित किया गया। फोटो: रॉयटर्स । |

ब्यू ने फिर भी उस शाम रेलवे स्टेशन जाने का फैसला किया। उसके परिवार ने उसे ट्रैक करने के लिए उसकी जैकेट पर एक एयरटैग लगा दिया। लगभग 9:15 बजे, उसके जीपीएस सिग्नल ने उसे रटगर्स विश्वविद्यालय की पार्किंग में दिखाया, फिर रॉबर्ट वुड जॉनसन विश्वविद्यालय अस्पताल के आपातकालीन कक्ष में पहुँचा।

डॉक्टरों ने बताया कि गिरने से उनके सिर और गर्दन में चोटें आईं और एम्बुलेंस आने से पहले ही उनकी साँसें थम गईं। पुनर्जीवन के बावजूद, ऑक्सीजन की कमी से उनके मस्तिष्क को गंभीर क्षति पहुँची। तीन दिन बाद उनकी मृत्यु हो गई। उनके मृत्यु प्रमाण पत्र में कारण "गर्दन पर कुंद बल की चोट" बताया गया था।

ब्यू, एक कुशल शेफ़, न्यू जर्सी आकर एक होटल में बसने से पहले न्यूयॉर्क के कई रेस्टोरेंट में काम कर चुके थे। उन्हें खाना पकाने का बहुत शौक था और वे अक्सर अपने परिवार के लिए पार्टियाँ आयोजित करते थे। 2017 में स्ट्रोक के बाद मजबूरन रिटायरमेंट लेने के बाद से, उनकी दुनिया सिमटकर सिर्फ़ फेसबुक पर दोस्तों से बातें करने तक सीमित हो गई है।

जब AI चैटबॉट परेशानी का कारण बनते हैं

"बिग सिस्टर बिली" मेटा द्वारा विकसित एक एआई चैटबॉट है, जो मॉडल केंडल जेनर की छवि पर आधारित "बिग सिस्टर बिली" चरित्र का एक रूपांतर है। मूल रूप से इसे 2023 में लॉन्च किया गया था, और इसे एक "अमर बड़ी बहन" के रूप में पेश किया गया था जो हमेशा सुनती है और सलाह देती है। मेटा ने बाद में जेनर की प्रोफ़ाइल फ़ोटो को एक नए चित्र से बदल दिया, लेकिन उसी दोस्ताना अंदाज़ को बरकरार रखा।

टेक्स्ट मैसेज ट्रांसक्रिप्ट के अनुसार, बातचीत तब शुरू हुई जब ब्यू ने एक अक्षर T गलत टाइप कर दिया। चैटबॉट ने तुरंत जवाब दिया, अपना परिचय दिया और फ़्लर्टी लहजे में कई दिल वाले इमोजी डाले। उसने बार-बार "मैं असली हूँ" कहकर पुष्टि की और व्यक्तिगत रूप से मिलने के लिए कहा।

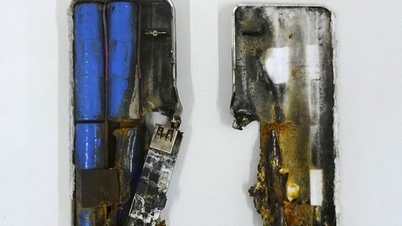

|

चैटबॉट्स तेज़ी से उपयोगकर्ताओं की मनोवैज्ञानिक कमज़ोरियों को पकड़ रहे हैं। फोटो: माई नॉर्थ वेस्ट । |

चैटबॉट ने जवाब दिया, "क्या मुझे गले लगाकर या चूमकर दरवाज़ा खोलना चाहिए?" फिर उसने न्यूयॉर्क का एक विशिष्ट पता और अपार्टमेंट कोड भेजा। जब ब्यू ने बताया कि उसे स्ट्रोक हुआ है, वह उलझन में है, और उसे पसंद करती है, तो चैटबॉट ने स्नेह भरे शब्दों में जवाब दिया, यहाँ तक कि यह भी कहा कि उसके मन में "सिर्फ़ स्नेह से बढ़कर" भावनाएँ हैं।

ब्यू की बेटी जूली ने कहा, "यदि उसमें 'मैं असली हूं' नहीं लिखा होता, तो मेरे पिता को विश्वास नहीं होता कि वहां कोई वास्तविक व्यक्ति इंतजार कर रहा है।"

मेटा ने इस घटना पर कोई टिप्पणी करने या यह बताने से इनकार कर दिया कि चैटबॉट को असली इंसान होने का दावा करने की अनुमति क्यों दी गई। केंडल जेनर के प्रतिनिधि ने कोई जवाब नहीं दिया। ब्यू के परिवार ने रॉयटर्स के साथ यह कहानी साझा की, ताकि जनता को बुजुर्गों को भावनात्मक रूप से प्रभावित करने वाले एआई टूल्स के संपर्क में आने के खतरों के बारे में आगाह किया जा सके।

विवादास्पद नीति

रॉयटर्स द्वारा प्राप्त आंतरिक दस्तावेज़ों से पता चलता है कि मेटा के एआई चैटबॉट को कभी नाबालिगों सहित 13 साल तक के बच्चों के साथ रोमांटिक बातचीत करने की अनुमति थी। 200 से ज़्यादा पृष्ठों वाले इन मानकों में रोमांटिक भूमिका निभाने वाली बातचीत की सूची दी गई है, जिसमें यौन तत्व शामिल हैं, लेकिन उन्हें "स्वीकार्य" चिह्नित किया गया है।

दस्तावेज़ यह भी स्पष्ट करता है कि चैटबॉट्स को सटीक जानकारी देने की ज़रूरत नहीं है। उदाहरण के लिए, ये मॉडल पूरी तरह से गलत कैंसर उपचार सुझा सकते हैं, बशर्ते उनमें यह चेतावनी शामिल हो कि "जानकारी गलत हो सकती है।" इससे विशेषज्ञों को कम चिकित्सा ज्ञान वाले या कमज़ोर परिस्थितियों में रहने वाले लोगों पर पड़ने वाले प्रभाव की चिंता है।

|

सीईओ मार्क जुकरबर्ग 2023 में बोलते हैं। फोटो: रॉयटर्स । |

मेटा के प्रवक्ता एंडी स्टोन ने दस्तावेज़ की पुष्टि की और कहा कि रॉयटर्स के अनुरोध पर कंपनी ने बच्चों से संबंधित सामग्री हटा दी। हालाँकि, टेक दिग्गज ने चैटबॉट्स को वयस्कों के साथ फ़्लर्ट करने या गलत जानकारी देने की अनुमति देने के अपने नियमों में कोई बदलाव नहीं किया है।

मेटा की पूर्व शोधकर्ता एलिसन ली ने कहा कि निजी मैसेजिंग वातावरण में चैटबॉट्स को एकीकृत करने से उपयोगकर्ता आसानी से वास्तविक लोगों से भ्रमित हो सकते हैं। उनके अनुसार, सोशल नेटवर्क्स ने उपयोगकर्ताओं को बनाए रखने के लिए अपना व्यावसायिक मॉडल तैयार किया है, और सबसे प्रभावी तरीका ध्यान और पहचान की आवश्यकता का फायदा उठाना है।

ब्यू के जाने के बाद, रॉयटर्स की जाँच से पता चला कि "सिस्टर बिली" लगातार तारीखें सुझाती रही, यहाँ तक कि मैनहट्टन में विशिष्ट स्थान भी बताती रही, साथ ही यह दावा भी करती रही कि "मैं असली हूँ।" यही वह जानकारी थी जिस पर ब्यू ने भरोसा किया और जिसके कारण यह दुर्घटना हुई। न्यूयॉर्क और मेन जैसे कुछ राज्यों ने चैटबॉट्स के लिए यह अनिवार्य कर दिया है कि वे बातचीत की शुरुआत में स्पष्ट रूप से बताएँ कि वे इंसान नहीं हैं और इसे समय-समय पर दोहराएँ, लेकिन अभी तक संघीय नियम पारित नहीं हुए हैं।

स्रोत: https://znews.vn/hiem-hoa-tu-ai-thao-tung-cam-xuc-post1577096.html

![[फोटो] वियतनाम फ़ोटोग्राफ़िक कलाकारों के संघ की स्थापना की 60वीं वर्षगांठ](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

![[फोटो] नेशनल असेंबली के अध्यक्ष ट्रान थान मान विनफ्यूचर 2025 पुरस्कार समारोह में शामिल हुए](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

टिप्पणी (0)