Jika Anda pernah menjelajahi media sosial, kemungkinan besar Anda pernah menemukan gambar atau video yang dibuat oleh AI. Banyak orang telah tertipu, seperti video viral kelinci yang melompat di atas trampolin. Tetapi Sora – aplikasi saudara dari ChatGPT yang dikembangkan oleh OpenAI – membawa video AI ke tingkat yang baru, membuat deteksi konten palsu menjadi semakin mendesak.

Perangkat lunak AI untuk video membuat identifikasi video asli menjadi lebih sulit dari sebelumnya. (Sumber: CNET)

Diluncurkan pada tahun 2024 dan baru-baru ini ditingkatkan dengan Sora 2, aplikasi ini memiliki antarmuka yang mirip dengan TikTok, di mana semua video dihasilkan oleh AI. Fitur "cameo" memungkinkan orang sungguhan dimasukkan ke dalam rekaman simulasi, menciptakan video yang sangat realistis dan menakutkan.

Oleh karena itu, banyak ahli khawatir bahwa Sora akan menyebabkan penyebaran deepfake, yang mendistorsi informasi dan mengaburkan batas antara kenyataan dan kepalsuan. Selebriti sangat rentan, sehingga organisasi seperti SAG-AFTRA menyerukan kepada OpenAI untuk memperkuat perlindungan.

Mengidentifikasi konten yang dihasilkan AI merupakan tantangan besar bagi perusahaan teknologi, platform media sosial, dan pengguna. Namun, ada cara untuk mengenali video yang dibuat menggunakan Sora.

Temukan tanda air Sora

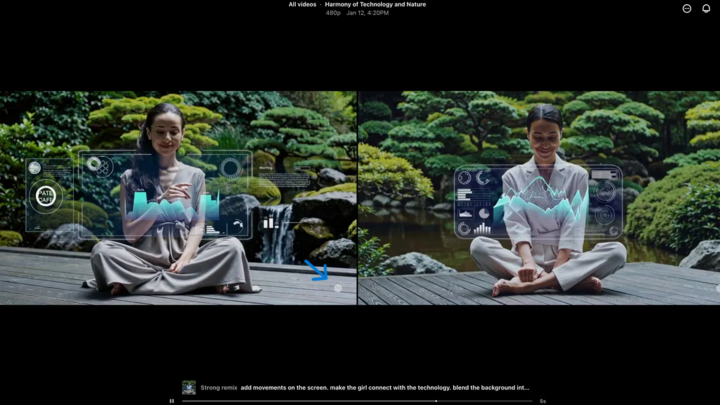

Tanda air Sora (ditunjukkan oleh panah biru) adalah penanda yang mengidentifikasi alat yang digunakan untuk membuat video tersebut. (Sumber: CNET)

Setiap video yang dibuat di aplikasi Sora iOS memiliki tanda air saat diunduh – logo Sora berwarna putih (ikon awan) bergerak di sekitar tepi video, mirip dengan tanda air TikTok.

Ini adalah cara visual untuk mengidentifikasi konten yang dihasilkan AI. Misalnya, model "nano-pisang" Gemini milik Google juga secara otomatis menambahkan watermark pada gambar. Namun, watermark tidak selalu dapat diandalkan. Jika watermark bersifat statis, watermark tersebut dapat dengan mudah dipotong. Bahkan watermark dinamis seperti milik Sora dapat dihapus menggunakan aplikasi khusus.

Ketika ditanya tentang hal ini, CEO OpenAI Sam Altman berpendapat bahwa masyarakat perlu beradaptasi dengan kenyataan bahwa siapa pun dapat membuat video palsu. Sebelum Sora, tidak pernah ada alat yang begitu populer, mudah diakses, dan tidak memerlukan keahlian untuk membuat video semacam itu. Perspektifnya menyoroti perlunya mengandalkan metode verifikasi alternatif.

Periksa metadata

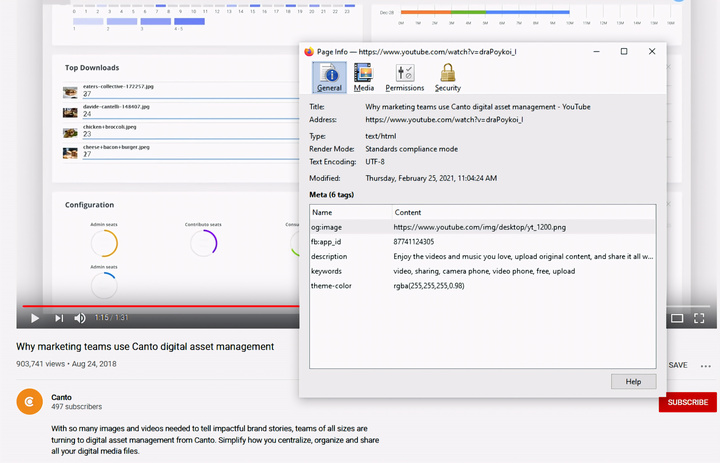

Memeriksa metadata – langkah penting dalam menentukan apakah sebuah video dibuat oleh AI, seperti Sora. (Sumber: Canto)

Anda mungkin berpikir bahwa memeriksa metadata terlalu rumit, tetapi sebenarnya cukup sederhana dan sangat efektif.

Metadata adalah sekumpulan informasi yang secara otomatis terlampir pada konten saat dibuat, seperti jenis kamera, lokasi, waktu perekaman, dan nama file. Baik konten tersebut dihasilkan oleh manusia maupun AI, semuanya memiliki metadata. Pada konten yang dihasilkan AI, metadata sering kali mencakup informasi atribusi sumber.

OpenAI adalah anggota dari Coalition for Content Origin and Authenticity (C2PA), jadi video Sora akan berisi metadata C2PA. Anda dapat memverifikasinya menggunakan alat verifikasi inisiatif keaslian konten:

Cara memeriksa metadata:

- Kunjungi verify.contentauthenticity.org

- Unggah file yang akan diperiksa.

- Tekan “Buka”

- Lihat informasi pada tabel di sebelah kanan.

Jika video tersebut dibuat oleh AI, ringkasan akan menyatakan hal itu dengan jelas. Saat memeriksa video Sora, Anda akan melihat baris "diterbitkan oleh OpenAI" dan informasi yang mengkonfirmasi bahwa video tersebut dibuat menggunakan AI. Semua video Sora harus memiliki informasi ini untuk memverifikasi asal-usulnya.

Sumber: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Gambar] Semangat juang yang gigih dari sepak bola wanita Vietnam](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[Siaran Langsung] Gala Penghargaan Aksi Komunitas 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Gambar] Bocoran gambar menjelang acara gala Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Foto] Perdana Menteri Pham Minh Chinh menerima Gubernur Provinsi Tochigi (Jepang)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Foto] Perdana Menteri Pham Minh Chinh menerima Menteri Pendidikan dan Olahraga Laos Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Siaran Langsung] Upacara Penutupan dan Penyerahan Penghargaan untuk Kontes Pembuatan Video/Klip "Pariwisata Vietnam yang Mengesankan" 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Komentar (0)