AIの専門家や技術に精通した政治学者は、2024年の米国大統領選挙を前に、ChatGPTのような生成AIツールの予測不可能な状態について警鐘を鳴らしている。

「アメリカはそれに備えていない」

5月15日、Fox Newsはサイバーセキュリティ企業ZeroFox(本社米国ミネソタ州)のAI担当副社長AJナッシュ氏の発言を引用し、アメリカ人は生成型AIへの対応に備えていないと警告した。ナッシュ氏によると、生成型AIは選挙キャンペーン用のメール、メッセージ、 動画クリップの内容を迅速に作成できるだけでなく、危険なツールにもなり得るという。

政府はAIツールを規制する方法を模索している

「生成AIは、音声・動画コンテンツの作成能力において飛躍的な進歩をもたらします。これを大規模に実行し、ソーシャルメディアプラットフォームに配信できるようになれば、計り知れないインパクトが生まれます」とナッシュ氏は説明した。ChatGPTのような生成AIが実現できる可能性は数多くあるが、その中には、アメリカ合衆国のような近代国家における選挙や投票に大きな影響を与えるものも数多くある。

ChatGPTは短時間で大量のコンテンツを作成できます

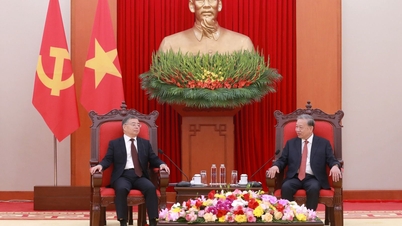

イラスト写真:ロイター

たとえば、ChatGPT は、候補者の声を模倣した自動音声メッセージを作成して有権者に間違った日に投票するよう指示したり、候補者が犯罪を告白したり人種差別的なコンテンツを作成しているように見える音声録音を公開したり、実際には行われていないスピーチやインタビューを行っている人物のビデオクリップを作成したり、地元のニュース報道に基づいてコンピューター生成画像を作成し、候補者が選挙から撤退したと誤って伝えたりすることができます。

「もしイーロン・マスク本人が電話をかけてきて、特定の候補者に投票するよう説得してきたらどうでしょう?」と、アレンAI研究所(米国ワシントン州に本部を置く)の元CEO兼創設者であるオーレン・エツィオーニ博士は述べた。「多くの人が彼の言うことに耳を傾けるでしょう。しかし、その電話をかけたのはマスクではなく、AIなのです」とエツィオーニ博士は指摘した。

敵からの危険

サイバーセキュリティ企業Forcepoint(本社:米国テキサス州)のグローバル最高技術責任者(CTO)であるペトコ・ストヤノフ氏は、外国勢力が人工知能(AI)を悪用し、2024年の米国大統領選挙を妨害しようとする可能性があると警告した。「外国勢力、サイバー犯罪組織、あるいは国家が誰かになりすまそうとしたらどうなるのか? どの程度の影響力を持つのか? 対処方法はあるのか?」と、ストヤノフ氏は対処すべき疑問を提起した。ストヤノフ氏によると、米国は選挙期間中、外国の情報源からの偽情報の波に見舞われるだろうという。

ピート・リケッツ上院議員(ネブラスカ州選出)も、2024年の選挙シーズン中に親中派組織がディープフェイク(実在の人物や出来事に見せかけた偽の画像や動画を作成する技術)を使用するリスクについて警告した。「彼らは間違いなくその能力を持っており、私たちは非常に警戒する必要がある」とリケッツ議員はFOXニュースのインタビューで述べた。

今年に入ってから、AIが作成したフェイクニュースがソーシャルメディアで大きな騒動を巻き起こしています。バイデン氏がトランスジェンダーの人々に対して攻撃的な発言をしている偽動画や、図書館で子供たちが悪魔崇拝について学んでいる様子を捉えた捏造画像などがその例です。ドナルド・トランプ前大統領の警察記録の写真がインターネット上に流出した際には、犯罪容疑で撮影されたわけではないにもかかわらず、多くの人がそれを信じてしまいました。また、AIが生成したトランプ氏が逮捕に抵抗する様子を捉えた画像も偽物でした。

イベット・クラーク下院議員(ニューヨーク州選出)は、AI生成の広告画像について候補者に有権者への通知を義務付ける法案を提出しました。クラーク議員はまた、合成画像を作成するすべての人に、画像の出所を明確に示す透かしを入れることを義務付ける法案の共同提案者でもあります。複数の州も、ディープフェイクに関する懸念に対処するための独自の提案を提出しています。

リケッツ上院議員は、今すべき最善策は、人工AIがもたらすリスクについて国民を啓蒙することだと述べた。また、選挙が始まる前に、米国政府は大学と協力して偽画像を見分ける能力を向上させることができると述べた。

ChatGPTのアップグレード

Mashableによると、OpenAI(米国カリフォルニア州)はChatGPTに重要なアップグレードを施し、ツールの動作中にWebに接続して閲覧できるようになりました。これにより、ChatGPTは最新の情報を更新し、より正確な回答を提供できるようになります。現在、米国のAmazonなどの企業は、顧客とのやり取りを可能にするChatGPTのようなインターフェースの構築と統合を行うAIエンジニアチームを採用しています。

[広告2]

ソースリンク

![[写真] 深海の砂の堆積物、古代木造船アンバン号が再び埋もれる危機に](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/13/1763033175715_ndo_br_thuyen-1-jpg.webp)

![ドンナイ省一村一品制への移行:[第3条] 観光と一村一品制製品の消費の連携](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

コメント (0)