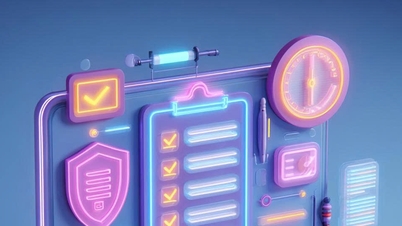

宇宙飛行士が馬に乗っているこの画像は、2種類の生成AIモデルを用いて作成された。写真:MITニュース

スピードと品質がトレードオフではなくなったとき

AI イメージングの分野では、現在、主に 2 つのアプローチがあります。

拡散モデルは鮮明で詳細な画像を可能にします。しかし、処理速度が遅く、計算コストも高く、各ピクセルからノイズを除去するのに数十段階の処理が必要になります。

自己回帰モデルは、画像の小さな部分を順次予測するため、はるかに高速です。しかし、生成される画像の詳細度が低く、エラーが発生しやすい傾向があります。

HART(ハイブリッド自己回帰変換)はこれら2つを組み合わせ、「両方の長所」を兼ね備えた技術です。まず自己回帰モデルを用いて全体像を構築し、離散トークンにエンコードします。次に、軽量拡散モデルを用いて残余トークン(エンコード中に失われた詳細情報)を埋めます。

結果として得られる画像は最先端の拡散モデルと同等(またはそれ以上)の品質ですが、処理速度は 9 倍速く、計算リソースの使用量は 31% 少なくなります。

高速で高品質な画像を作成するための新しいアプローチ

HARTの注目すべき革新の一つは、自己回帰モデルを用いる際に生じる情報損失の問題を解決する点です。画像を離散トークンに変換すると処理速度は向上しますが、物体のエッジ、顔の特徴、髪の毛、目、口といった重要な情報が失われてしまいます。

HARTの解決策は、拡散モデルを残差トークンを通してこれらの詳細を「修正」することのみに集中させることです。自己回帰モデルが既にほとんどの作業を行っているため、拡散モデルに必要な処理ステップは、従来の30ステップ以上ではなく、わずか8ステップです。

「普及モデルは実装が容易で、効率性が向上します」と共著者のハオティアン・タン氏は説明する。

具体的には、7 億のパラメータを持つ自己回帰トランスフォーマー モデルと 3,700 万のパラメータを持つ軽量拡散モデルを組み合わせることで、HART は最大 20 億のパラメータを持つ拡散モデルと同じパフォーマンスを実現しながらも、9 倍の速度を実現します。

当初、チームは拡散モデルを画像生成プロセスの初期段階に統合しようと試みましたが、エラーが蓄積されてしまいました。最も効果的なアプローチは、拡散モデルに最終段階を任せ、画像の「欠けている」部分のみに焦点を当てることでした。

マルチメディアAIの未来を切り開く

チームの次のステップは、HARTアーキテクチャに基づく次世代の視覚言語AIモデルの構築です。HARTはスケーラブルで、幅広いデータタイプ(マルチモーダル)に適応できるため、 ビデオ生成、音声予測など、多くの分野への応用が期待されています。

この研究は、MIT-IBM Watson AI Lab、MIT-Amazon Science Center、MIT AIハードウェアプログラム、米国国立科学財団など、複数の組織から資金提供を受けました。NVIDIAは、モデルのトレーニング用にGPUインフラストラクチャも提供しました。

(MITニュースによると)

出典: https://vietnamnet.vn/cong-cu-ai-moi-tao-anh-chat-luong-cao-nhanh-gap-9-lan-2384719.html

![[写真] カットバ島 - 緑の楽園の島](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

コメント (0)