最近最も注目を集めている中国のスタートアップ企業DeepSeekは、わずか500万ドルでOpenAIと同等のAIを開発するという自社の主張に疑問を投げかけている。

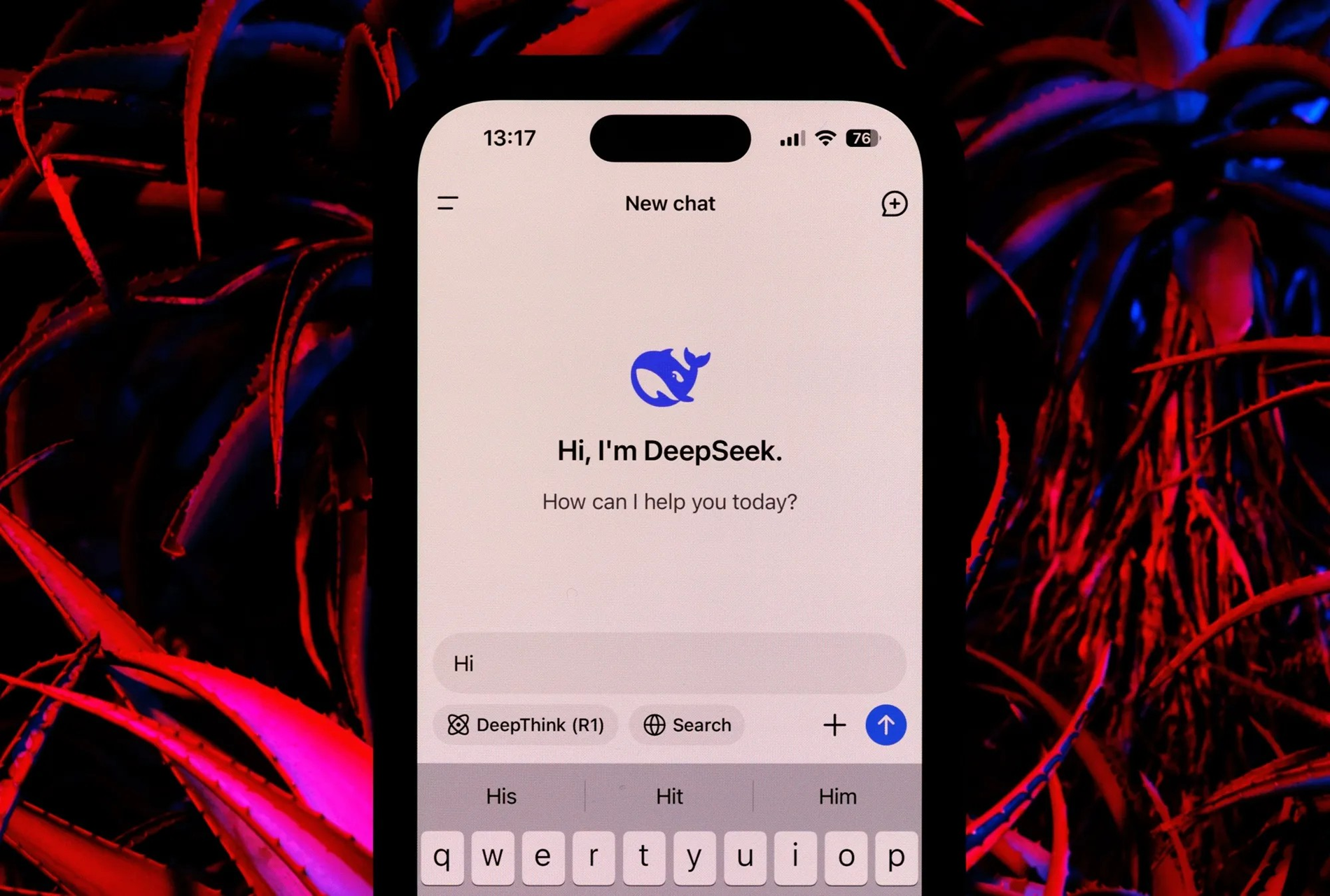

DeepSeek は蛇年の初めにメディアやソーシャルメディアで大きく取り上げられ、世界の株式市場に大きな波紋を引き起こしました。

しかし、金融コンサルティング会社バーンスタインの最近のレポートは、素晴らしい成果があるにもかかわらず、わずか500万ドルでOpenAIに匹敵するAIシステムを構築できるという主張は不正確であると警告している。

バーンスタイン氏によれば、ディープシークの声明は誤解を招くものであり、全体像を反映していないという。

「ディープシーク社が『500万ドルでOpenAIを作った』わけではないと我々は考えている。モデルは素晴らしいが、奇跡だとは思っていない。週末のパニックは誇張されていたようだ」と報告書は述べている。

DeepSeekは、DeepSeek-V3とDeepSeek R1という2つの主要なAIモデルを開発しています。大規模なV3言語モデルはMOEアーキテクチャを活用し、小規模なモデルを組み合わせることで、従来のモデルよりも少ない計算リソースで高いパフォーマンスを実現します。

一方、V3 モデルには 6,710 億のパラメータがあり、そのうち 370 億のパラメータが常時アクティブであり、メモリ使用量を削減する MHLA などの革新が組み込まれ、効率性を高めるために FP8 が活用されています。

V3モデルの学習には、2ヶ月間にわたり2,048基のNvidia H800 GPUクラスターが必要で、これは550万GPU時間に相当します。学習コストは約500万ドルと推定されていますが、バーンスタインのレポートでは、この数字はコンピューティングリソースのみを対象としており、研究、テスト、その他の開発費用に関連する多額のコストは含まれていないことを強調しています。

DeepSeek R1 モデルは、強化学習 (RL) やその他の技術を利用して推論機能を確保することで、V3 の基盤の上に構築されています。

R1モデルは推論タスクにおいてOpenAIモデルと競合可能です。しかし、バーンスタイン氏は、R1の開発には多大なリソースが必要であると指摘していますが、DeepSeekのレポートでは詳細は明らかにされていません。

DeepSeekについて、バーンスタイン氏はそのモデルを高く評価しました。例えば、V3モデルは、言語学、プログラミング、数学の分野における他の主要な言語モデルと同等かそれ以上の性能を発揮しながら、必要なリソースは少ないとしています。

V3 の事前トレーニング プロセスに必要なのはわずか 270 万 GPU 時間で、これは他のトップレベルのモデルのコンピューティング リソースの 9% に相当します。

バーンスタイン氏は、DeepSeekの進歩は注目に値するものの、誇張された主張には注意が必要だと結論付けた。わずか500万ドルでOpenAIの競合相手を作るという考えは見当違いであるように思われる。

(タイムズ・オブ・インディアによると)

[広告2]

出典: https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

![[画像] 党中央本部が2025年の活動を総括](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F18%2F1766065572073_vptw-hoi-nghi-tong-ket-89-1204-jpg.webp&w=3840&q=75)

![[ビデオ] 歴史と遺産の保存に関する2冊の本の出版](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/18/1766072185865_2663241292917005256-4230-jpg.webp)

コメント (0)