ອະດີດ CEO Eric Schmidt ຂອງ Google (ພາບ: Vbee).

ອະດີດ CEO ຂອງ Google Eric Schmidt ໄດ້ເຕືອນກ່ຽວກັບການເກີດຂື້ນຢ່າງໄວວາຂອງ Artificial Super Intelligence (ASI), ໂດຍເນັ້ນຫນັກວ່າສັງຄົມບໍ່ໄດ້ກຽມພ້ອມຢ່າງຈິງຈັງສໍາລັບຄວາມກ້າວຫນ້າທາງດ້ານເຕັກໂນໂລຢີນີ້.

ລາວຄາດຄະເນວ່າ AI ອາດຈະເຮັດໃຫ້ວຽກການຂຽນໂປຼແກຼມສ່ວນໃຫຍ່ລ້າສະໄຫມຍ້ອນຄວາມສາມາດໃນການປັບປຸງຕົນເອງຢ່າງຕໍ່ເນື່ອງ.

ASI: ການກ້າວກະໂດດອັນໃຫຍ່ຫຼວງຈາກ AGI ແລະຄວາມສະຫຼາດຂອງມະນຸດ

ໃນຂະນະທີ່ ໂລກ ສຸມໃສ່ບັນຫາດ້ານຈັນຍາບັນຂອງປັນຍາປະດິດ (AI), ອັດຕະໂນມັດ, ແລະ AI ແທນວຽກ, Eric Schmidt ໄດ້ຊີ້ໃຫ້ເຫັນເຖິງການພັດທະນາທີ່ສໍາຄັນກວ່າທີ່ເກີດຂື້ນຢ່າງງຽບໆ: ການເກີດຂື້ນຂອງ Artificial Super Intelligence (ASI).

Schmidt ເຕືອນວ່າ ASI ໃກ້ເຂົ້າມາແລ້ວ ແລະສັງຄົມບໍ່ໄດ້ກຽມພ້ອມທີ່ຈະປະເຊີນກັບມັນ, ເຊິ່ງອາດຈະເປັນອັນຕະລາຍ. ບໍ່ຄືກັບ Artificial General Intelligence (AGI) - ລະບົບທີ່ມີຄວາມສາມາດທາງດ້ານສະຕິປັນຍາທຽບກັບມະນຸດ - ASI ເປັນຕົວແທນຂອງລະບົບທີ່ມີທ່າແຮງທີ່ຈະລື່ນກາຍຄວາມສະຫລາດຂອງບຸກຄົນເທົ່ານັ້ນແຕ່ຍັງມີປັນຍາລວມຂອງມະນຸດທັງຫມົດລວມກັນ.

"ປະຊາຊົນບໍ່ເຂົ້າໃຈວ່າຈະເກີດຫຍັງຂຶ້ນເມື່ອທ່ານມີຄວາມສະຫຼາດໃນລະດັບນີ້," ອະດີດ CEO ຂອງ Google ເນັ້ນຫນັກ.

ຜູ້ຂຽນໂປລແກລມມີຄວາມສ່ຽງຕໍ່ການຖືກແທນທີ່ບໍ?

ຫນຶ່ງໃນການຄາດຄະເນການຂັດແຍ້ງທີ່ສຸດຂອງ Schmidt ແມ່ນວ່າ AI ສາມາດເຮັດໃຫ້ວຽກການຂຽນໂປຼແກຼມສ່ວນໃຫຍ່ລ້າສະໄຫມພາຍໃນຫນຶ່ງປີ. ລາວອ້າງເຖິງຄວາມກ້າວຫນ້າໃນການປັບປຸງຕົນເອງແບບ recursive, ລະບົບ AI ທີ່ຂຽນແລະປັບປຸງລະຫັດຂອງຕົນເອງ, ເປັນຜູ້ຂັບຂີ່ທີ່ສໍາຄັນຂອງການປ່ຽນແປງນີ້.

ແລ້ວ, AI ກໍາລັງປະກອບສ່ວນທີ່ສໍາຄັນຕໍ່ການພັດທະນາຊອບແວ. "10-20% ຂອງລະຫັດໃນຫ້ອງທົດລອງ OpenAI ແລະ Anthropic ແມ່ນໄດ້ຖືກຂຽນໂດຍ AI," ລາວອ້າງເຖິງ.

ໃນຂະນະທີ່ລະບົບເຫຼົ່ານີ້ສືບຕໍ່ພັດທະນາ, ພວກມັນບໍ່ພຽງແຕ່ໄວຂຶ້ນແລະມີປະສິດທິພາບຫຼາຍຂຶ້ນ, ແຕ່ຍັງເລີ່ມປະຕິບັດດີກວ່າປະລິນຍາເອກແລະອາຈານຄະນິດສາດໃນຂົງເຂດຕ່າງໆເຊັ່ນການເຂົ້າລະຫັດແບບພິເສດແລະການໃຫ້ເຫດຜົນທີ່ມີໂຄງສ້າງ.

ນີ້ສະແດງໃຫ້ເຫັນເຖິງການປ່ຽນແປງພື້ນຖານຂອງບົດບາດຂອງແຮງງານຂອງມະນຸດໃນເຕັກໂນໂລຢີ, ຈາກຜູ້ສ້າງໄປສູ່ຜູ້ເບິ່ງແຍງຫຼືອາດຈະຖືກລົບລ້າງທັງຫມົດ.

ໂດດເຕັ້ນ

ອີງຕາມອະດີດ CEO ຂອງ Google, ປະຊາຊົນຈໍານວນຫຼາຍໃນ Silicon Valley (ບ່ອນທີ່ບໍລິສັດເຕັກໂນໂລຢີຊັ້ນນໍາຂອງໂລກ converge) ຕົກລົງເຫັນດີວ່າ AGI (ລະບົບທີ່ມີຄວາມສາມາດໃນການສົມເຫດສົມຜົນຄືກັບມະນຸດ) ຈະບັນລຸໄດ້ພາຍໃນ 3-5 ປີຂ້າງຫນ້າ.

ທ່ານກ່າວວ່າການກ້າວກະໂດດຢ່າງໃຫຍ່ຫຼວງຫຼາຍຈະເກີດຂື້ນພຽງແຕ່ຫນຶ່ງປີຫຼືສອງປີຫຼັງຈາກ AGI, ແລະເອີ້ນເສັ້ນທາງນີ້ວ່າ "San Francisco Consensus" - ເປັນຄໍາທີ່ສະທ້ອນໃຫ້ເຫັນເຖິງຄວາມສອດຄ່ອງທີ່ເພີ່ມຂຶ້ນລະຫວ່າງບັນດານັກວິຊາການເຕັກໂນໂລຢີໃນໄລຍະເວລາສັ້ນໆຂອງ ASI.

ບໍ່ເຫມືອນກັບການປ່ຽນແປງທາງດ້ານເທກໂນໂລຍີທີ່ຜ່ານມາ, ການຫັນປ່ຽນໄປສູ່ ASI ອາດຈະໄວແລະຕື່ນເຕັ້ນຫຼາຍທີ່ລະບົບແບບດັ້ງເດີມເຊັ່ນການຄຸ້ມຄອງ, ກົດຫມາຍ, ແລະ ເສດຖະກິດ ອາດຈະບໍ່ສາມາດປັບຕົວໄດ້ທັນເວລາ.

ໂລກບໍ່ໄດ້ກຽມພ້ອມສໍາລັບຍຸກຂອງ super intelligence.

ເຖິງວ່າຈະມີຜົນກະທົບທີ່ອາດຈະມີການປ່ຽນແປງແລະແມ້ກະທັ້ງທີ່ມີຢູ່ແລ້ວຂອງ ASI, Schmidt ຊີ້ໃຫ້ເຫັນຊ່ອງຫວ່າງທີ່ສໍາຄັນໃນການຮັບຮູ້ສາທາລະນະແລະການສົນທະນາ.

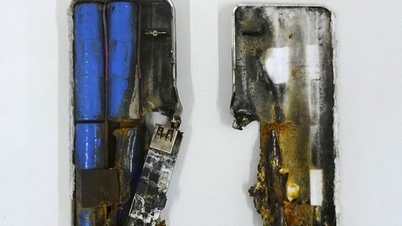

ASI ສາມາດ "ລົບ" ຫຼາຍວຽກໃນໂລກທີ່ທັນສະໄຫມ (ພາບ: XP).

"ບັນຫາບໍ່ພຽງແຕ່ຄວາມໄວຂອງການວິວັດທະນາການຂອງ AI, ແຕ່ຍັງຂາດແນວຄວາມຄິດຂອງພາສາແລະກອບສະຖາບັນເພື່ອເຂົ້າຮ່ວມກັບມັນຢ່າງມີຄວາມຫມາຍ. ບໍ່ມີພາສາທີ່ຈະອະທິບາຍສິ່ງທີ່ຈະເກີດຂື້ນໃນເວລາທີ່ມັນເກີດຂຶ້ນ. ມັນເກີດຂຶ້ນໄວກວ່າທີ່ສັງຄົມແລະກົດຫມາຍຂອງພວກເຮົາສາມາດໂຕ້ຕອບໄດ້," ລາວໃຫ້ຄໍາເຫັນ.

ໃນຄໍາສັບຕ່າງໆອື່ນໆ, ລະບົບນະໂຍບາຍຂອງໂລກຍັງຊັກຊ້າຢູ່ໄກກວ່າຈັງຫວະຂອງການປະດິດສ້າງ, ສ້າງຄວາມບໍ່ສົມດຸນອັນຕະລາຍລະຫວ່າງຄວາມສາມາດທາງດ້ານເຕັກໂນໂລຢີແລະຄວາມພ້ອມຂອງສັງຄົມ.

ເນື່ອງຈາກລະບົບ AI ເກີນຄວາມສາມາດຂອງມະນຸດ, Schmidt ສະເຫນີສອງເສັ້ນທາງທີ່ເປັນໄປໄດ້. ໃນດ້ານຫນຶ່ງແມ່ນຄໍາສັນຍາຂອງການຟື້ນຟູເຕັກໂນໂລຢີ, ຂັບເຄື່ອນໂດຍລະບົບອັດສະລິຍະສູງສຸດທີ່ສາມາດແກ້ໄຂສິ່ງທ້າທາຍທີ່ຍິ່ງໃຫຍ່ທີ່ສຸດຂອງມະນຸດໄດ້. ອີກດ້ານ ໜຶ່ງ, ມີຄວາມສ່ຽງຕໍ່ການເກີດວິກິດການດ້ານຈັນຍາບັນແລະຄວາມວຸ້ນວາຍທາງສັງຄົມທີ່ບໍ່ເຄີຍມີມາກ່ອນ.

ອະດີດ CEO ຂອງ Google ຮຽກຮ້ອງໃຫ້ໂລກກະກຽມສໍາລັບ ASI ກ່ອນທີ່ມັນຈະສາຍເກີນໄປ. ຄໍາເຕືອນຂອງ Eric Schmidt ບໍ່ໄດ້ອີງໃສ່ການຄາດເດົາ ວິທະຍາສາດ , ແຕ່ແທນທີ່ຈະເປັນການສົນທະນາທີ່ເກີດຂື້ນໃນມື້ນີ້ໃນບັນດາຜູ້ທີ່ສ້າງເຕັກໂນໂລຢີຂອງອະນາຄົດ.

ບໍ່ວ່າເຈົ້າເຫັນດີກັບເສັ້ນເວລາຂອງລາວຫຼືບໍ່, ຂໍ້ຄວາມຂອງລາວແມ່ນຈະແຈ້ງ: ປັນຍາປະດິດບໍ່ແມ່ນແນວຄິດທີ່ໄກ, ແຕ່ມັນກາຍເປັນຄວາມເປັນຈິງຢ່າງໄວວາ.

ເມື່ອຄວາມເປັນຈິງນີ້ເຂົ້າໃກ້, ໂລກຕ້ອງປ່ຽນຈຸດສຸມຈາກການໂຕ້ວາທີແຄບກ່ຽວກັບຄວາມສ່ຽງຂອງ AI ໃນໄລຍະສັ້ນໄປສູ່ການປຶກສາຫາລືທີ່ເລິກເຊິ່ງ, ກວ້າງຂວາງກ່ຽວກັບການປົກຄອງໄລຍະຍາວ, ຈັນຍາບັນ, ແລະການກະກຽມສໍາລັບສິ່ງທີ່ສາມາດເປັນກໍາລັງການປ່ຽນແປງທີ່ສຸດໃນປະຫວັດສາດຂອງມະນຸດ.

ທີ່ມາ: https://dantri.com.vn/cong-nghe/sieu-tri-tue-nhan-tao-dang-am-tham-den-khi-the-gioi-chua-san-sang-20250708010323899.htm

![[ຮູບພາບ] ທ່ານປະທານສະພາແຫ່ງຊາດ ເຈີ່ນດ້າຍກວາງ ເຂົ້າຮ່ວມພິທີມອບລາງວັນ VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

![[ຮູບພາບ] 60 ປີແຫ່ງວັນສ້າງຕັ້ງສະມາຄົມນັກສິລະປິນຫວຽດນາມ](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

(0)