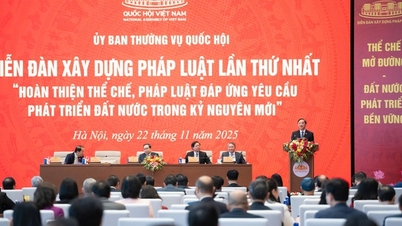

ຕາມທ່ານຜູ້ແທນ ດົ່ງງອກບາ, ການປະກາດໃຊ້ກົດໝາຍວ່າດ້ວຍປັນຍາປະດິດ (AI) ຈະປະກອບສ່ວນສ້າງພື້ນຖານນິຕິກຳທີ່ເປັນເອກະພາບ ແລະ ສອດຄ່ອງ, ທັງຊຸກຍູ້ການພັດທະນາ ແລະ ຮັບປະກັນການຄຸ້ມຄອງຄວາມສ່ຽງຢ່າງມີປະສິດທິຜົນໃນການຄົ້ນຄວ້າ, ພັດທະນາ ແລະ ນຳໃຊ້ AI, ຕອບສະໜອງຄວາມຮຽກຮ້ອງຕ້ອງການຂອງການພັດທະນາ ເສດຖະກິດ - ສັງຄົມ ໃນຍຸກດີຈີຕອນ.

ທ່ານຜູ້ແທນກ່າວວ່າ, ອົງການສ້າງຮ່າງກົດໝາຍໄດ້ມີຄວາມຕັ້ງໜ້າ ແລະ ມີຄວາມຮັບຜິດຊອບ, ສຶກສາ ແລະ ດູດເອົາຫຼາຍຄຳເຫັນຈາກອົງການກວດກາ ແລະ ບັນດາອົງການທີ່ກ່ຽວຂ້ອງເພື່ອສ້າງຮ່າງກົດໝາຍໃຫ້ສຳເລັດ. ຜູ້ແທນໄດ້ຕີລາຄາສູງຫຼາຍເນື້ອໃນທີ່ໄດ້ຮັບການເອົາໃຈໃສ່ ແລະ ປັບປຸງຮ່າງກົດໝາຍໃໝ່.

ພ້ອມກັນນັ້ນ, ຍັງໄດ້ແນະນຳໃຫ້ສືບຕໍ່ກວດກາ ແລະ ປັບປຸງ ໂດຍສະເພາະແມ່ນຮັບປະກັນຄວາມສອດຄ່ອງ ແລະ ສອດຄ່ອງກັບກົດໝາຍທີ່ກ່ຽວຂ້ອງເຊັ່ນ: ປະມວນກົດໝາຍແພ່ງ, ກົດໝາຍວ່າດ້ວຍຄຸນນະພາບສິນຄ້າ, ກົດໝາຍວ່າດ້ວຍຊັບສິນທາງປັນຍາ, ກົດໝາຍວ່າດ້ວຍເຕັກໂນໂລຊີສູງ, ກົດໝາຍວ່າດ້ວຍມາດຕະຖານ ແລະ ລະບຽບການເຕັກນິກ; ຮັບປະກັນແນວຄິດນິຕິກຳ ແລະ ເຕັກນິກນິຕິກຳໃໝ່.

ຄຽງຂ້າງນັ້ນ, ທ່ານຮອງປະທານປະເທດ ດັ້ງຫງອກບາ ກໍ່ໄດ້ມີບາງຂໍ້ສະເໜີແນະສະເພາະ.

ຮ່າງກົດໝາຍວ່າດ້ວຍປັນຍາປະດິດ (ມາດຕາ 7 ຫາ 11) ໄດ້ກໍານົດການຈັດປະເພດຂອງການຄຸ້ມຄອງຄວາມສ່ຽງຂອງລະບົບ AI ເປັນ 4 ລະດັບຄື: ຄວາມສ່ຽງຕໍ່າ, ຄວາມສ່ຽງປານກາງ, ຄວາມສ່ຽງສູງ ແລະ ຄວາມສ່ຽງທີ່ບໍ່ສາມາດຍອມຮັບໄດ້.

ທ່ານຮອງ ບາ ໃຫ້ຮູ້ວ່າ, ໂດຍພື້ນຖານຂອງ AI ແລ້ວ, ຖ້າລະບົບ AI ຖືວ່າເປັນປະເພດສິນຄ້າ ຫຼື ສິນຄ້າ, ເນື້ອໃນຂອງຮ່າງກົດໝາຍບໍ່ສົມເຫດສົມຜົນ ແລະ ບໍ່ສອດຄ່ອງ, ບໍ່ເຂົ້າກັບຂໍ້ກໍານົດຂອງກົດໝາຍວ່າດ້ວຍຄຸນນະພາບສິນຄ້າ ແລະ ສິນຄ້າ (ແບ່ງສິນຄ້າ ແລະ ສິນຄ້າອອກເປັນ 3 ກຸ່ມຄື: ຄວາມສ່ຽງຕໍ່າ, ຄວາມສ່ຽງປານກາງ ແລະ ຄວາມສ່ຽງສູງ).

ດັ່ງນັ້ນ, ຈຶ່ງສະເໜີໃຫ້ອົງການຮ່າງກົດໝາຍຄົ້ນຄວ້າຢ່າງລະອຽດ ແລະ ຈັດແບ່ງລະບົບ AI ໃນລັກສະນະທີ່ສອດຄ່ອງກັບກົດໝາຍວ່າດ້ວຍຄຸນນະພາບສິນຄ້າ ແລະ ສິນຄ້າ (3 ລະດັບຄວາມສ່ຽງ) ເພື່ອອຳນວຍຄວາມສະດວກໃນການຈັດຕັ້ງປະຕິບັດ.

"ໃນກໍລະນີຂອງລະບົບ AI ທີ່ມີ " ຄວາມສ່ຽງທີ່ບໍ່ສາມາດຍອມຮັບໄດ້", ນີ້ຄວນຈະເປັນກິດຈະກໍາທີ່ຕ້ອງຫ້າມ, ແລະຄວນໄດ້ຮັບການກໍານົດໂດຍສະເພາະເປັນຂໍ້ຫ້າມໃນຮ່າງກົດຫມາຍ. ມັນຈໍາເປັນຕ້ອງເພີ່ມການກະທໍາທີ່ຫ້າມອື່ນໆໃນການຄົ້ນຄວ້າ, ການພັດທະນາ, ແລະການນໍາໃຊ້ AI (ຕົວຢ່າງ: ການນໍາໃຊ້ AI ລະເມີດຄວາມປອດໄພແຫ່ງຊາດ, ການນໍາໃຊ້ AI ເພື່ອຈໍາແນກໂດຍອີງໃສ່ຂໍ້ມູນ biometric, ແລະອື່ນໆ).

ກ່ຽວກັບຄວາມຮັບຜິດຊອບໃນການຊົດເຊີຍຄວາມເສຍຫາຍທີ່ເກີດຈາກລະບົບ AI, ຢູ່ຈຸດ A, ຂໍ້ 3, ມາດຕາ 30 ຂອງຮ່າງກົດຫມາຍວ່າດ້ວຍປັນຍາທຽມໄດ້ກໍານົດວ່າ: "ສໍາລັບລະບົບ AI ທີ່ມີຄວາມສ່ຽງສູງ: ໃນກໍລະນີຄວາມເສຍຫາຍທີ່ເກີດຈາກການລະເມີດໃນການຄຸ້ມຄອງແລະການນໍາໃຊ້ລະບົບ AI, ອົງການຈັດຕັ້ງຫຼືບຸກຄົນທີ່ມີການລະເມີດຈະຕ້ອງຊົດເຊີຍຄວາມເສຍຫາຍຕາມຂໍ້ກໍານົດຂອງກົດຫມາຍແພ່ງ."

ອີງຕາມມາດຕາ 1, ມາດຕາ 601 ຂອງປະມວນກົດໝາຍແພ່ງ, ແຫຼ່ງທີ່ມາຂອງອັນຕະລາຍທີ່ຮ້າຍກາດປະກອບມີພາຫະນະຈັກ, ລະບົບສາຍສົ່ງໄຟຟ້າ, ໂຮງງານອຸດສາຫະກຳ, ອາວຸດ, ວັດຖຸລະເບີດ, ວັດຖຸໄວໄຟ, ສານພິດ, ສານວິທະຍຸ, ສັດປ່າ ແລະ ແຫຼ່ງອັນຕະລາຍທີ່ຮ້າຍກາດອື່ນໆ ຕາມທີ່ໄດ້ກຳນົດໄວ້ໃນກົດໝາຍ.

ຕາມທ່ານຮອງດັ້ງງອກບາແລ້ວ, ປະມວນກົດໝາຍແພ່ງໄດ້ຈຳແນກການຊົດເຊີຍຄວາມເສຍຫາຍທີ່ເກີດຈາກແຫຼ່ງອັນຕະລາຍສູງແລະກໍລະນີອື່ນໆ, ໂດຍສະເພາະແມ່ນກ່ຽວກັບປັດໄຈຄວາມຜິດໃນການກຳນົດຄວາມຮັບຜິດຊອບຄ່າຊົດເຊີຍ. ດ້ວຍບົດບັນຍັດຂອງຮ່າງກົດໝາຍວ່າດ້ວຍປັນຍາປະດິດຢູ່ຈຸດ ກ, ມາດຕາ 3, ມາດຕາ 30 ຂ້າງເທິງນັ້ນ, ຍັງບໍ່ຈະແຈ້ງວ່າ “ລະບົບ AI ທີ່ມີຄວາມສ່ຽງສູງ” ເປັນ “ແຫຼ່ງອັນຕະລາຍສູງ” ຫຼືບໍ່. ໃນຂະນະດຽວກັນ, ໃນລັກສະນະທາງດ້ານວິຊາການແລະເຕັກໂນໂລຊີ, ລະບົບ AI ທີ່ມີຄວາມສ່ຽງສູງມີລັກສະນະຂອງແຫຼ່ງທີ່ເປັນອັນຕະລາຍສູງ.

ດັ່ງນັ້ນ, ຜູ້ແທນຈຶ່ງໄດ້ສະເໜີໃຫ້ສຶກສາ ແລະ ປັບປຸງເນື້ອໃນຂໍ້ ກ 3 ມາດຕາ 30 ຂອງຮ່າງກົດໝາຍວ່າດ້ວຍປັນຍາປະດິດ ໃນທິດທາງການກຳນົດລະບົບ AI ທີ່ມີຄວາມສ່ຽງສູງເປັນແຫຼ່ງທີ່ມາຂອງໄພອັນຕະລາຍທີ່ສຸດ, ເພື່ອເປັນບ່ອນອີງໃນການຈັດຕັ້ງປະຕິບັດລະບຽບການກ່ຽວກັບຄວາມຮັບຜິດຊອບໃນການຊົດເຊີຍຄວາມເສຍຫາຍທີ່ເກີດຈາກລະບົບ AI ຕາມກົດໝາຍແພ່ງ.

ກ່ຽວກັບການປະດິດສ້າງດ້ານແນວຄິດ ແລະ ເຕັກນິກນິຕິບັນຍັດ, ທ່ານຮອງປະທານສະພາແຫ່ງຊາດ ໄດ້ສະເໜີໃຫ້ມີການກວດກາຄືນເພື່ອຮັບປະກັນວ່າກົດໝາຍວ່າດ້ວຍປັນຍາປະດິດບໍ່ໄດ້ກຳນົດບັນດາບັນຫາຢູ່ພາຍໃຕ້ອຳນາດການປົກຄອງຂອງ ລັດຖະບານ . ສະເພາະໃນໝວດທີ VI (ການກວດກາ, ກວດກາ ແລະ ຄຸ້ມຄອງການລະເມີດ), ພິຈາລະນາບໍ່ກຳນົດການກວດກາສະເພາະແຕ່ໃຫ້ລັດຖະບານຄຸ້ມຄອງຕາມອຳນາດຂອງຕົນ. ທົບທວນບົດທີ VII (ການຄຸ້ມຄອງລັດຂອງ AI), ຖອດຖອນລະບຽບການພາຍໃຕ້ສິດອໍານາດຂອງລັດຖະບານເຊັ່ນ: ຄວາມຮັບຜິດຊອບການຄຸ້ມຄອງລັດຂອງບັນດາກະຊວງ... ສະເໜີໃຫ້ລວມບົດທີ VI ເຂົ້າເປັນໝວດທີ VII, ເພາະວ່າການກວດກາ, ກວດກາ ແລະ ຄຸ້ມຄອງການລະເມີດແມ່ນເນື້ອໃນສະເພາະຂອງການຄຸ້ມຄອງລັດຂອງ AI.

ທ່ານຮອງຫົວໜ້າຄະນະຜູ້ແທນສະພາແຫ່ງຊາດແຂວງ Gia Lai ທ່ານ Siu Huong ໄດ້ສະແດງຄວາມສົນໃຈຕໍ່ບັນດາລະບຽບການກ່ຽວກັບຈັນຍາບັນ ແລະ ຄວາມຮັບຜິດຊອບໃນບັນດາການເຄື່ອນໄຫວ AI ໃນພາກທີ 5.

ຕາມທ່ານຜູ້ແທນ Huong ແລ້ວ, ປະຈຸບັນ, ຫຼາຍຮູບແບບ AI ໄດ້ຮັບການຝຶກອົບຮົມໂດຍການເກັບກຳຂໍ້ມູນ, ສິລະປະ ແລະ ເນື້ອໃນທີ່ສ້າງສັນຈາກອິນເຕີເນັດໂດຍບໍ່ໄດ້ຮັບຄວາມຍິນດີຈາກຜູ້ຂຽນ, ແລະ ບໍ່ມີກົນໄກທີ່ຈະຕອບແທນຜູ້ຂຽນ. ອັນນີ້ເຮັດໃຫ້ເກີດຄວາມສ່ຽງຕໍ່ການລະເມີດສິດທິຊັບສິນທາງປັນຍາຂອງຜູ້ສ້າງເນື້ອຫາ.

ດັ່ງນັ້ນ, ຜູ້ແທນຈຶ່ງສະເໜີໃຫ້ອົງການຮ່າງກົດໝາຍພິຈາລະນາເພີ່ມໃສ່ບົດທີ 5 ລະບຽບການທີ່ຜູ້ພັດທະນາລະບົບ AI ຕ້ອງມີກົນໄກການອະນຸຍາດທີ່ຊັດເຈນ, ອະນຸຍາດໃຫ້ເຈົ້າຂອງເນື້ອຫາເລືອກເຫັນດີ ຫຼື ປະຕິເສດທີ່ຈະໃຊ້ວຽກຂອງເຂົາເຈົ້າເພື່ອຈຸດປະສົງການຝຶກອົບຮົມ AI. ໃນເວລາດຽວກັນ, ການຄົ້ນຄວ້າຄວນສ້າງກົນໄກການຊົດເຊີຍຫຼືການແບ່ງປັນຜົນປະໂຫຍດສໍາລັບຜູ້ຂຽນເມື່ອວຽກງານຂອງພວກເຂົາຖືກນໍາໃຊ້ໃນການຝຶກອົບຮົມແບບຈໍາລອງ AI.

ເຂົ້າຮ່ວມການສົນທະນາ, ທ່ານຮອງປະທານສະພາແຫ່ງຊາດແຂວງ Gia Lai ໄດ້ຍົກອອກມາຈາກທັດສະນະຂອງຜູ້ບໍລິໂພກທີ່ກ່ຽວຂ້ອງເມື່ອນຳໃຊ້ຜະລິດຕະພັນ “AI”, ຖ້າຫາກເກີດເຫດການເກີນກຳນົດ, ສ້າງຄວາມເສຍຫາຍ, ແມ່ນໃຜຈະຮັບຜິດຊອບຄ່າຊົດເຊີຍ.

ຕາມທ່ານຮອງແຄ໋ງຮ່ວາແລ້ວ, ຮ່າງກົດໝາຍວ່າດ້ວຍປັນຍາທຽມບໍ່ໄດ້ອະທິບາຍຄຳວ່າ “ຜະລິດຕະພັນນຳໃຊ້ເຕັກໂນໂລຊີ AI”. ຜູ້ບໍລິໂພກພຽງແຕ່ຮູ້ຈັກຜະລິດຕະພັນ, ແຕ່ວ່ານັກຄົ້ນຄວ້າແລະນັກວິທະຍາສາດເທົ່ານັ້ນຮູ້ວ່າເຕັກໂນໂລຢີ AI ແມ່ນຫຍັງ.

ທ່ານຮອງລັດຖະມົນຕີ ກວ໋າງເຊີນ ໄດ້ສະເໜີຈຳແນກ AI ຢ່າງຈະແຈ້ງວ່າ ແມ່ນຜະລິດຕະພັນນຳເຂົ້າ, ເຄື່ອງມື, ຜະລິດຕະພັນເຄິ່ງສຳເລັດຮູບ ຫຼື ຜະລິດຕະພັນສຳເລັດຮູບ. ຈາກນັ້ນ, ຈະມີລະບຽບການສະເພາະກ່ຽວກັບຄວາມຮັບຜິດຊອບຂອງຜູ້ສະຫນອງ.

"ຕົວຢ່າງເຊັ່ນ, AI ໄດ້ຖືກລວມເຂົ້າໃນຜະລິດຕະພັນເທົ່ານັ້ນ, ເມື່ອຄວາມເສຍຫາຍເກີດຂື້ນ, ຜູ້ຂາຍຜະລິດຕະພັນນັ້ນຕ້ອງຮັບຜິດຊອບຢ່າງເຕັມທີ່ແລະບໍ່ສາມາດຕໍານິຕິຕຽນມັນກ່ຽວກັບ AI, "ເພາະວ່າບໍລິສັດທີ່ເຮັດໃຫ້ AI ຂາຍໃຫ້ຂ້ອຍ, ຂ້ອຍບໍ່ສາມາດຄວບຄຸມມັນໄດ້." - ຮອງ Canh ວິເຄາະ.

ທີ່ມາ: https://baogialai.com.vn/viec-ban-hanh-luat-tri-tue-nhan-tao-la-van-de-cap-bach-post573129.html

(0)