(CLO) OpenAIs tale-til-tekst-verktøy Whisper markedsføres som «robust og nøyaktig på nesten menneskelig nivå», men har én stor ulempe: Det er tilbøyelig til å fabrikkere tekstbiter eller til og med hele setninger!

Noen av tekstene den fabrikkerer, kjent i bransjen som hallusinatoriske, kan inneholde rasistiske kommentarer, vold og til og med imaginære medisinske behandlinger, sier eksperter.

Eksperter sier slike påstander er alvorlige fordi Whisper brukes i mange bransjer rundt om i verden til å oversette og transkribere intervjuer, generere tekst og undertekste videoer.

Enda mer bekymringsfullt er det at medisinske sentre bruker Whisper-baserte verktøy for å registrere konsultasjoner mellom pasient og lege, til tross for OpenAIs advarsel om at verktøyet ikke bør brukes i «høyrisikoområder».

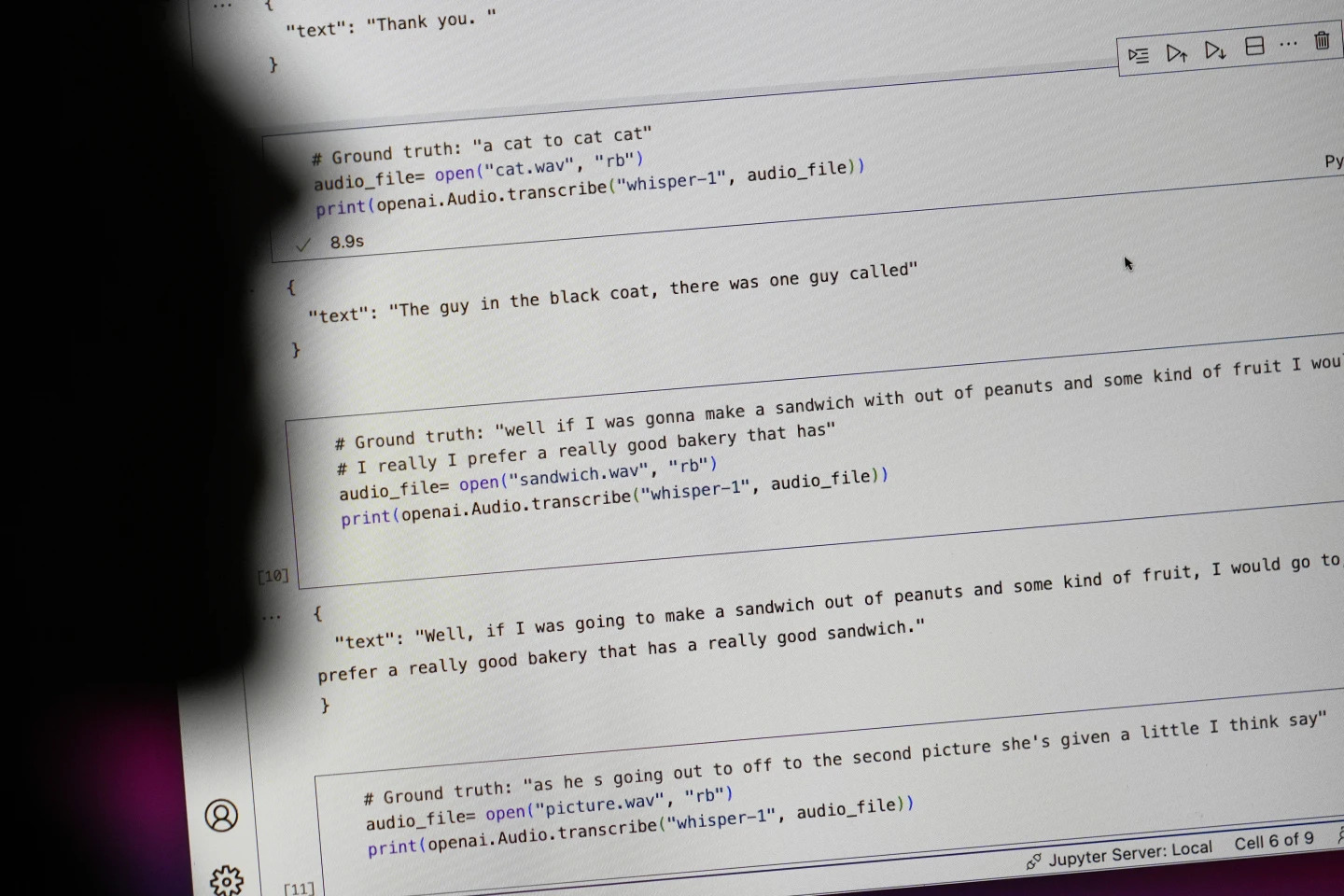

Setninger som begynner med «#Ground truth» er det som faktisk ble sagt, setninger som begynner med «#text» er det Whisper transkriberte. Foto: AP

Forskere og ingeniører sier at Whisper ofte produserer hallusinasjoner under bruk. For eksempel sa en forsker ved University of Michigan at han fant hallusinasjoner i åtte av ti opptak han undersøkte.

En tidlig maskinlæringsingeniør fant manipulasjon i omtrent halvparten av de mer enn 100 timene med Whisper-transkripter han analyserte. En tredje utvikler sa at han fant hallusinasjoner i nesten alle de 26 000 transkriptene som ble laget med Whisper.

Illusjonen vedvarer selv i korte, godt innspilte lydklipp. En fersk studie utført av informatikere fant 187 forvrengninger i mer enn 13 000 klare lydklipp de undersøkte.

Den trenden ville føre til titusenvis av feil på tvers av millioner av opptak, sa forskerne.

Slike feil kan ha «virkelig alvorlige konsekvenser», spesielt på sykehus, sa Alondra Nelson, professor ved School of Social Sciences ved Institute for Advanced Study.

«Ingen ønsker å bli feildiagnostisert. Det må være en høyere barriere», sa Nelson.

Professorene Allison Koenecke ved Cornell University og Mona Sloane ved University of Virginia undersøkte tusenvis av korte utdrag de hentet fra TalkBank, et forskningsarkiv ved Carnegie Mellon University. De fant ut at nesten 40 % av hallusinasjonene var skadelige eller forstyrrende fordi den som snakket kunne bli misforstått eller feilrepresentert.

En taler i et opptak beskrev «to andre jenter og en kvinne», men Whisper fabrikerte ytterligere rasistiske kommentarer, og la til «to andre jenter og en kvinne, eh, som var svart».

I en annen transkripsjon oppfant Whisper et ikke-eksisterende legemiddel kalt «antibiotika med økt aktivitet».

Selv om de fleste utviklere erkjenner at transkripsjonsverktøy kan lage stavefeil eller andre feil, sier ingeniører og forskere at de aldri har sett et AI-drevet transkripsjonsverktøy så hallusinogent som Whisper.

Verktøyet er integrert i flere versjoner av OpenAIs flaggskip-chatbot, ChatGPT, og er en integrert tjeneste i Oracles og Microsofts skybaserte databehandlingsplattform, som betjener tusenvis av selskaper over hele verden. Det brukes også til å transkribere og oversette tekst til mange språk.

Ngoc Anh (ifølge AP)

[annonse_2]

Kilde: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![Overgang til Dong Nai OCOP: [Artikkel 3] Kobling av turisme med forbruk av OCOP-produkter](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Kommentar (0)