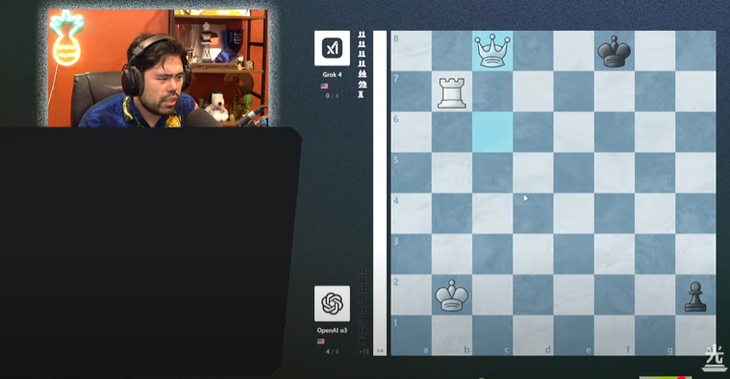

Gracz Nakamura powiedział, że Grok 4 wydawał się grać z napiętą mentalnością w meczu finałowym - Zdjęcie: zrzut ekranu

Przed meczem firma OpenAI wywołała poruszenie ogłaszając premierę 11. generacji LLM, GPT-5.

Jednak model o3-ChatGPT użyty w finale nadal wykazywał silne zdolności wnioskowania, ze średnią liczbą poprawnych ruchów na poziomie 90,8%, co całkowicie przewyższało 80,2% uzyskaną przez Grok 4.

We wszystkich czterech partiach ChatGPT nie dał Grokowi 4 żadnych szans, dając mata przeciwnikowi odpowiednio po 35, 30, 28 i 54 ruchach.

Według Hikaru Nakamury, drugiego w rankingu , Grok 4 wydawał się grać z większym napięciem i popełniać więcej błędów niż w poprzednich rundach. W szczególności łatwo tracił elementy – co było rzadkością, gdy przytłaczająco pokonał Gemini 2.5 Flash i Gemini 2.5 Pro od Google.

Z trzema zwycięstwami z rzędu, wynikiem 4-0 i średnią celnością na poziomie 91%, o3 zakończyło turniej perfekcyjnie.

Choć siła o3 nie dorównuje profesjonalnym arcymistrzom szachowym, to jednak wystarcza, by przysporzyć kłopotów graczom z ELO poniżej 2000. Zwłaszcza w kategoriach blitz i super blitz.

Turniej zorganizowany przez Google zakończył się absolutną dominacją reprezentantów USA. Podczas gdy dwa chińskie modele, Kimi K4 i DeepSeek, odpadły na wczesnym etapie, mecz o trzecie miejsce wygrał Gemini 2.5 Pro nad o4-mini, potwierdzając tym samym pozycję liderów amerykańskich firm technologicznych.

To wydarzenie nie tylko pokazuje niesamowite możliwości modeli sztucznej inteligencji ogólnego przeznaczenia w specjalistycznej dziedzinie, ale także otwiera nowe perspektywy na potencjał rozwoju sztucznej inteligencji w przyszłości.

Przypomina nam to jednak, że chociaż programy LLM rozwijają się w szybkim tempie, wciąż nie mogą dorównać poziomowi profesjonalnych programów szachowych, których rankingi ELO znacznie przewyższają rankingi ludzkie.

Źródło: https://tuoitre.vn/chatgpt-dang-quang-giai-co-vua-danh-cho-ai-20250808090405997.htm

![[Zdjęcie] Sekretarz generalny To Lam spotyka się z byłym premierem Wielkiej Brytanii Tonym Blairem](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761821573624_tbt-tl1-jpg.webp)

![[Zdjęcie] Przewodniczący Zgromadzenia Narodowego Tran Thanh Man przyjmuje zagranicznych ambasadorów, którzy przybyli, aby się z nim pożegnać](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761820977744_ndo_br_1-jpg.webp)

![[Zdjęcie] III Zjazd Patriotyczny Centralnej Komisji Spraw Wewnętrznych](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761831176178_dh-thi-dua-yeu-nuoc-5076-2710-jpg.webp)

![[Zdjęcie] Sekretarz generalny To Lam bierze udział w konferencji gospodarczej wysokiego szczebla Wietnam-Wielka Brytania](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825773922_anh-1-3371-jpg.webp)

![[Zdjęcie] Wzruszający widok tysięcy ludzi ratujących nabrzeże przed rwącą wodą](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825173837_ndo_br_ho-de-3-jpg.webp)

![[Infografika] Harmonogram 9. kolejki V-League: Ninh Binh ma szansę przedłużyć swoją passę meczów bez porażki](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/30/1761829981121_3-26-4124-jpg.webp)

Komentarz (0)