OpenAI nie ujawniło zbyt wielu informacji na temat sposobu trenowania ChatGPT-4. Jednak duże modele językowe (LLM) są zazwyczaj trenowane na podstawie tekstu pobranego z internetu, gdzie językiem urzędowym jest angielski. Około 93% danych treningowych ChatGPT-3 pochodzi z języka angielskiego.

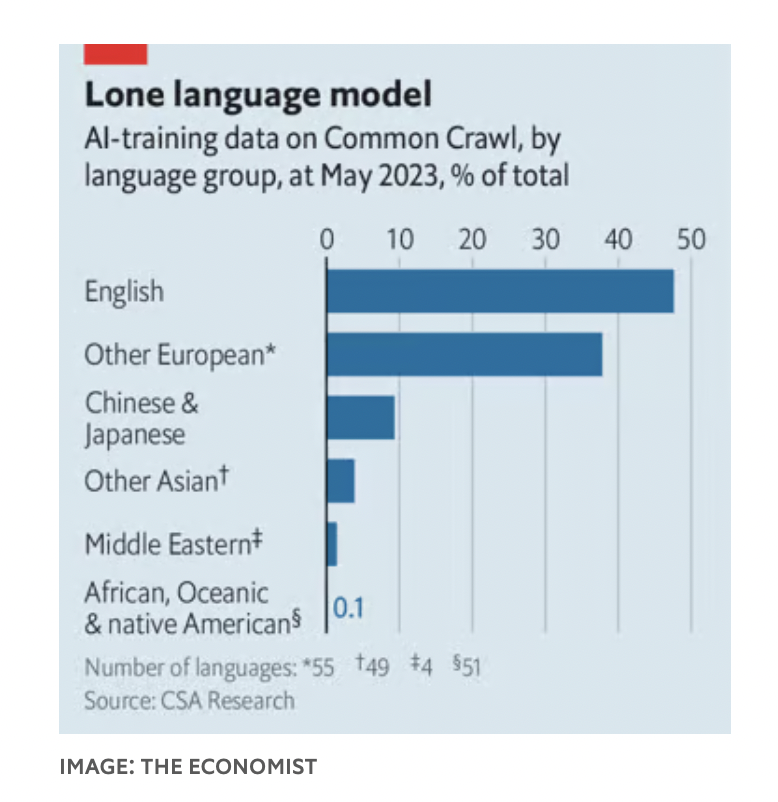

W bazie Common Crawl, jednym z zestawów danych, na których trenowano model sztucznej inteligencji, język angielski stanowi 47% korpusu, a pozostałe języki europejskie – kolejne 38%. Dla porównania, chiński i japoński razem stanowią zaledwie 9%.

Nie jest to problem ograniczony wyłącznie do ChatGPT, jak odkrył Nathaniel Robinson, badacz z Uniwersytetu Johnsa Hopkinsa, i jego współpracownicy. Wszystkie programy LLM radziły sobie lepiej w językach o „bogatych zasobach”, gdzie danych treningowych było dużo, niż w językach o „niskich zasobach”, gdzie było ich niewiele.

To problem dla tych, którzy chcą wprowadzić sztuczną inteligencję do biednych krajów, aby poprawić sytuację w takich obszarach jak edukacja czy służba zdrowia. W związku z tym naukowcy na całym świecie pracują nad zwiększeniem wielojęzyczności sztucznej inteligencji.

We wrześniu ubiegłego roku rząd Indii uruchomił chatbota, który ma pomóc rolnikom być na bieżąco z przydatnymi informacjami od rządu.

Shankar Maruwada z EkStep Foundation, organizacji non-profit, która pomogła w stworzeniu chatbota, powiedział, że bot działa poprzez połączenie dwóch typów modeli językowych, umożliwiając użytkownikom przesyłanie zapytań w ich ojczystym języku. Zapytania te są przekazywane do oprogramowania do tłumaczenia maszynowego w indyjskim ośrodku badawczym, które tłumaczy je na angielski, a następnie przekazuje odpowiedź do LLM, gdzie jest ona przetwarzana. Na koniec odpowiedź jest tłumaczona z powrotem na język ojczysty użytkownika.

Ten proces może działać, ale tłumaczenie zapytań na „preferowany” język LLM to nieudolne obejście. Język jest odzwierciedleniem kultury i światopoglądu . Artykuł z 2022 roku autorstwa Rebekki Johnson, badaczki z Uniwersytetu w Sydney, wykazał, że narzędzie ChatGPT-3 dostarczyło odpowiedzi na tematy takie jak kontrola broni i polityka wobec uchodźców, które były porównywalne z amerykańskimi wartościami wyrażonymi w badaniu World Values Survey.

W rezultacie wielu badaczy stara się, aby absolwenci studiów magisterskich (LLM) biegle posługiwali się mniej popularnymi językami. Technicznie rzecz biorąc, jednym z rozwiązań jest modyfikacja tokenizatora dla danego języka. Indyjski startup Sarvam AI stworzył tokenizator zoptymalizowany pod kątem języka hindi, czyli model OpenHathi – LLM zoptymalizowany pod kątem języka dewanagari (Indie), który może znacząco obniżyć koszty udzielania odpowiedzi na pytania.

Innym sposobem jest ulepszenie zbiorów danych, na których trenowany jest LLM. W listopadzie zespół badaczy z Uniwersytetu Mohameda bin Zayeda w Abu Zabi opublikował najnowszą wersję swojego modelu języka arabskiego o nazwie „Jais”. Ma on jedną szóstą liczby parametrów ChatGPT-3, ale działa niemal równie dobrze w języku arabskim.

Timothy Baldwin, rektor Uniwersytetu Mohameda bin Zayeda, zauważył, że chociaż jego zespół zdigitalizował dużą część tekstu arabskiego, w modelu uwzględniono również tekst angielski. Niektóre koncepcje są takie same we wszystkich językach i można się ich nauczyć w dowolnym języku.

Trzecim podejściem jest dostrajanie modeli po ich wytrenowaniu. Zarówno Jais, jak i OpenHathi oferują szereg generowanych przez ludzi par pytań i odpowiedzi. To samo dotyczy zachodnich chatbotów, aby zapobiec dezinformacji.

Ernie Bot, absolwent studiów magisterskich (LLM) z Baidu, dużej chińskiej firmy technologicznej, został dostrojony tak, aby ograniczać wypowiedzi, które mogłyby obrazić rząd. Modele mogą również uczyć się na podstawie opinii użytkowników, a użytkownicy oceniają odpowiedzi uzyskane od absolwentów studiów magisterskich. Jest to jednak trudne w przypadku wielu języków w regionach słabo rozwiniętych ze względu na konieczność zatrudnienia wykwalifikowanych osób do oceny odpowiedzi maszyny.

(Według Economista)

Źródło

![[Zdjęcie] Premier Pham Minh Chinh przewodniczy 16. spotkaniu Narodowego Komitetu Sterującego ds. zwalczania nielegalnych połowów.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/07/1759848378556_dsc-9253-jpg.webp)

![[Zdjęcie] Superksiężyc żniwny świeci jasno w noc Święta Środka Jesieni na całym świecie](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/07/1759816565798_1759814567021-jpg.webp)

Komentarz (0)