|

A Anthropic acaba de atualizar sua política. Foto: GK Images . |

Em 28 de agosto, a empresa de IA Anthropic anunciou o lançamento de uma versão atualizada dos Termos de Serviço para Usuários e da Política de Privacidade. Os usuários agora podem optar por permitir que seus dados sejam usados para aprimorar o Claude e reforçar a proteção contra abusos como phishing e fraude.

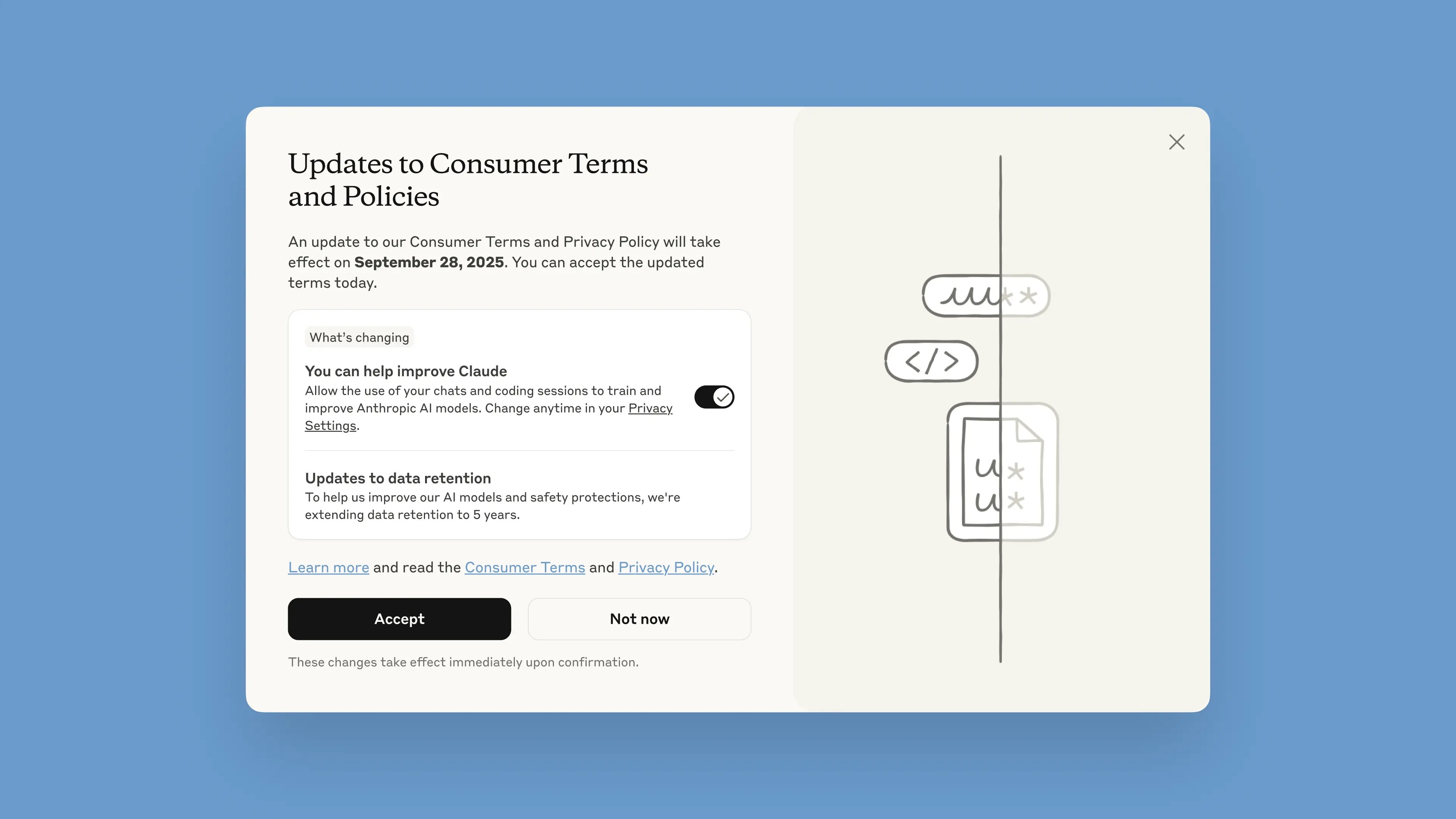

Esta notificação será implementada no chatbot a partir de 28 de agosto. Os usuários têm um mês para aceitar ou rejeitar os termos. As novas políticas entrarão em vigor imediatamente após a aceitação. Após 28 de setembro, os usuários deverão escolher se desejam continuar usando o Claude.

Segundo a empresa, as atualizações visam oferecer modelos de IA mais úteis e poderosos. Ajustar essa opção é simples e pode ser feito a qualquer momento nas Configurações de Privacidade.

Essas alterações se aplicam aos planos Claude Free, Pro e Max, que incluem o Claude Code, a ferramenta de programação da Anthropic. Os serviços cobertos pelos Termos de Comércio não serão incluídos, como o Claude for Work, Claude Gov, Claude for Education ou o uso de APIs, inclusive por meio de terceiros, como Amazon Bedrock e Vertex AI do Google Cloud.

Em sua postagem no blog, a Anthropic afirmou que, ao participar, os usuários ajudarão a aprimorar a segurança do modelo, aumentar sua capacidade de detectar conteúdo malicioso com precisão e reduzir o risco de sinalizar conversas inofensivas por engano. Versões futuras do Claude também terão habilidades aprimoradas, como programação, análise e raciocínio.

É importante que os usuários tenham controle total sobre seus dados e possam escolher se permitem ou não que a plataforma os utilize em uma janela visível. Novas contas podem configurar isso opcionalmente durante o processo de registro.

|

Janela exibindo os novos Termos e Condições no chatbot. Imagem: Anthropic. |

O período de retenção de dados foi estendido para 5 anos, aplicável a novas conversas ou sessões de programação, bem como a respostas do chatbot. Os dados excluídos não serão utilizados para treinamento futuro do modelo. Caso os usuários não concordem em fornecer dados para treinamento, a política de retenção atual de 30 dias será aplicada.

Ao explicar sua política, a Anthropic argumenta que os ciclos de desenvolvimento de IA normalmente duram muitos anos, e manter a consistência dos dados ao longo do processo de treinamento ajuda a criar modelos mais consistentes. A retenção de dados por um período mais longo também aprimora os classificadores e sistemas usados para identificar comportamentos abusivos, permitindo a detecção de padrões comportamentais prejudiciais.

"Para proteger a privacidade do usuário, utilizamos uma combinação de ferramentas e processos automatizados para filtrar ou ocultar dados sensíveis. Não vendemos dados de usuários a terceiros", escreveu a empresa.

A Anthropic é frequentemente citada como uma das empresas líderes em IA segura. A Anthropic desenvolve uma metodologia chamada IA Constitucional, que estabelece princípios e diretrizes éticas que o modelo deve seguir. A Anthropic também é uma das empresas que participam de compromissos de IA segura com os governos dos EUA, Reino Unido e G7.

Fonte: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

Comentário (0)