EchoLeak e os riscos potenciais da inteligência artificial

Com a inteligência artificial (IA) se tornando parte integrante de todas as tarefas, desde auxiliar na redação de relatórios e responder a e-mails até analisar dados, os usuários parecem viver em uma era de conveniência sem precedentes. Mas o lado sombrio dessa conveniência também começa a surgir, principalmente no que diz respeito à segurança.

Uma vulnerabilidade de segurança recente, denominada EchoLeak, deixou os usuários do serviço Microsoft Copilot em risco de terem seus dados confidenciais vazados sem que precisem tomar qualquer providência.

Quando a IA se torna uma vulnerabilidade de segurança

Segundo pesquisa do Tuoi Tre Online , o EchoLeak é uma vulnerabilidade de segurança recém-registrada com o código CVE-2025-32711, que especialistas classificaram como perigosa, com nota 9,3/10 na escala do NIST.

O que preocupa os especialistas em segurança é a sua natureza "sem cliques" : os atacantes podem explorar dados do Copilot sem que o usuário precise clicar, abrir um arquivo ou sequer saber que algo está acontecendo.

Este não é um bug simples. A equipe de pesquisa da Aim Labs, que descobriu a vulnerabilidade, acredita que o EchoLeak reflete uma falha de projeto comum em sistemas RAG (geração aumentada por recuperação) e sistemas de IA baseados em agentes. Como o Copilot faz parte do pacote de aplicativos do Microsoft 365, que armazena e-mails, documentos, planilhas e agendas de reuniões de milhões de usuários, o risco de vazamento de dados é muito sério.

O problema reside não apenas no código específico, mas na forma como os grandes modelos de linguagem (LLMs) operam. As IAs precisam de muito contexto para responder com precisão e, portanto, recebem acesso a grandes quantidades de dados de fundo. Sem controles claros sobre a entrada e a saída, as IAs podem ser "conduzidas" de maneiras que os usuários desconhecem. Isso cria um novo tipo de "porta dos fundos", não por causa de uma falha no código, mas porque as IAs se comportam fora da compreensão humana.

A Microsoft lançou rapidamente uma correção e, até o momento, não foram relatados danos reais. Mas a lição do EchoLeak é clara: quando a IA está profundamente integrada aos sistemas em funcionamento, mesmo pequenos erros na forma como ela entende o contexto podem ter grandes consequências para a segurança.

Quanto mais conveniente for a IA, mais frágeis serão os dados pessoais.

O incidente do EchoLeak levanta uma questão preocupante: será que os usuários confiam tanto na IA que não percebem que podem ser rastreados ou ter suas informações pessoais expostas com apenas uma mensagem de texto? Uma vulnerabilidade recém-descoberta que permite que hackers extraiam dados silenciosamente, sem que os usuários precisem clicar em nada, é algo que antes só víamos em filmes de ficção científica, mas agora é realidade.

Embora as aplicações de IA estejam se tornando cada vez mais populares, desde assistentes virtuais como o Copilot, chatbots em bancos e educação , até plataformas de IA que escrevem conteúdo e processam e-mails, a maioria das pessoas não é alertada sobre como seus dados são processados e armazenados.

"Conversar" com um sistema de IA não se resume mais a fazer algumas perguntas por conveniência, mas também pode revelar inadvertidamente sua localização, hábitos, emoções ou até mesmo informações da sua conta.

No Vietnã, muitas pessoas estão familiarizadas com o uso de IA em celulares e computadores sem conhecimento básico de segurança digital . Muitas compartilham informações privadas com IA porque acreditam que "é apenas uma máquina". Mas, na realidade, por trás disso existe um sistema capaz de gravar, aprender e transmitir dados para outros lugares, especialmente quando a plataforma de IA é de terceiros e não foi devidamente testada quanto à segurança.

Para limitar os riscos, os usuários não precisam necessariamente abandonar a tecnologia, mas sim estar mais atentos: devem verificar cuidadosamente se o aplicativo de IA que estão usando possui uma fonte confiável, se os dados estão criptografados e, principalmente , não compartilhar informações sensíveis, como números de identidade, contas bancárias, informações de saúde etc., com qualquer sistema de IA sem antes serem claramente alertados.

Assim como aconteceu com os primórdios da internet, a IA também precisa de tempo para se aperfeiçoar e, durante esse período, os usuários devem ser os primeiros a se protegerem proativamente.

Você já compartilhou informações demais com a IA?

Ao digitar comandos como “reescreva este relatório para mim, mas de uma forma mais amigável” ou “resuma a reunião de ontem”, muitas pessoas não imaginam que todas as informações inseridas, incluindo detalhes íntimos, sentimentos pessoais ou hábitos de trabalho, podem ser registradas por inteligência artificial. Nos acostumamos gradualmente a conversar com ferramentas inteligentes, esquecendo a fronteira entre conveniência e privacidade.

Fonte: https://tuoitre.vn/lo-hong-bao-mat-trong-microsoft-copilot-canh-bao-moi-ve-nguy-co-ro-ri-du-lieu-tu-ai-20250620103045262.htm

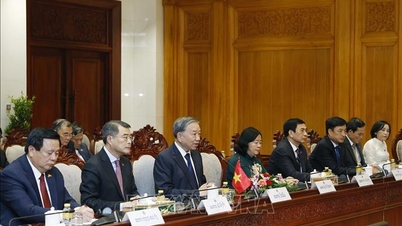

![[Foto] O primeiro-ministro Pham Minh Chinh recebe o presidente da Agência Latino-Americana de Notícias de Cuba.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F01%2F1764569497815_dsc-2890-jpg.webp&w=3840&q=75)

Comentário (0)