Технологические гиганты потратили миллиарды долларов, веря в то, что «чем больше, тем лучше» в области искусственного интеллекта (ИИ).

Однако прорыв DeepSeek показывает, что и меньшие модели могут достигать аналогичной производительности при гораздо меньших затратах.

В конце января DeepSeek объявила, что окончательная стоимость обучения модели R1 составила всего 5,6 млн долларов , что составляет лишь малую часть от того, что взимают американские компании.

«Технологические пираты»

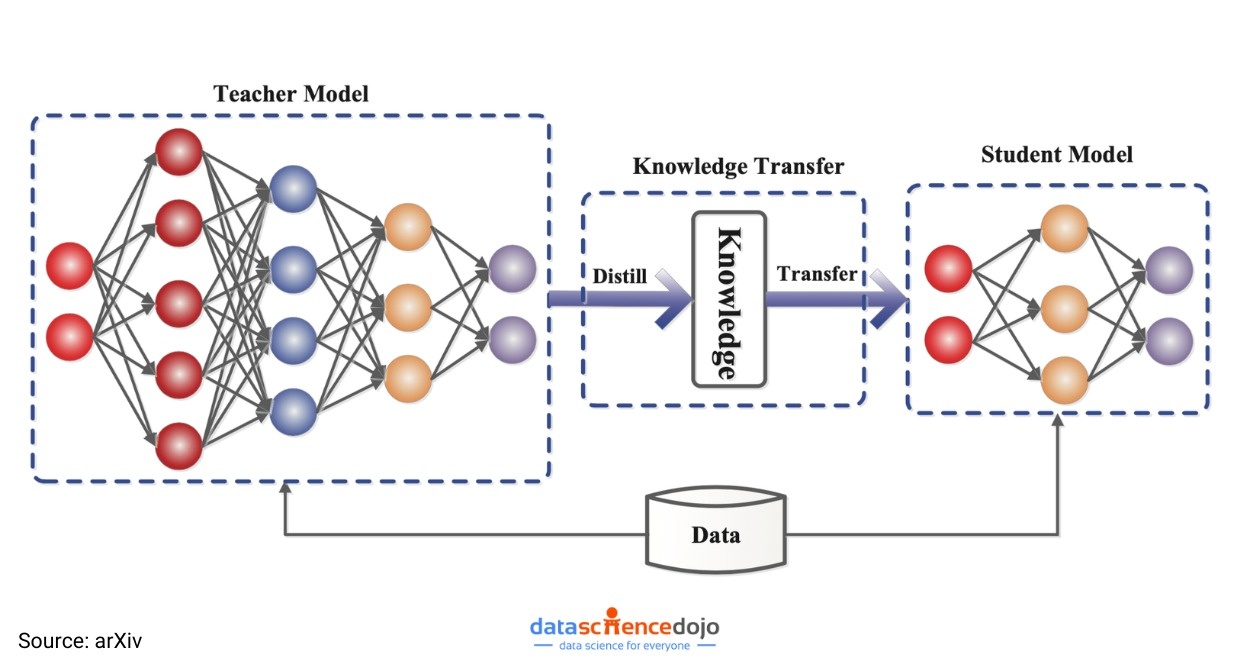

Выход DeepSeek в ряды ведущих производителей ИИ также вызвал бурные дискуссии в Кремниевой долине о процессе, называемом «дистилляция».

Это метод, при котором новая система обучается на основе существующей системы, задавая сотни тысяч вопросов и анализируя ответы.

Путем дистилляции компании возьмут большую языковую модель (LLM), называемую моделью «учителя», которая способна предсказать следующее слово, которое с наибольшей вероятностью появится в предложении.

Модель учителя генерирует данные, которые затем используются для обучения меньшей модели «ученика». Этот процесс позволяет быстро переносить знания и прогностические возможности из большей модели в меньшую.

|

Вместо того, чтобы тратить миллиарды долларов на обучение модели, метод «дистилляции» позволяет DeepSeek достигать тех же результатов, просто обучаясь на основе большой существующей модели. Фото: Mint. |

Хотя дистилляция широко используется уже много лет, последние достижения заставили отраслевых экспертов полагать, что она станет все более важным преимуществом для таких стартапов, как DeepSeek.

В отличие от таких гигантов отрасли, как OpenAI, эти компании всегда ищут экономически эффективные решения для разработки приложений на базе ИИ.

«Дистилляция — это просто волшебство. Это процесс взятия большой, интеллектуальной модели края и ее использования для обучения меньшей модели. Она очень мощна для определенных задач, супердешева и супербыстра в исполнении», — говорит Оливье Годеман, руководитель продукта OpenAI.

Вопросы по эффективности миллиардов долларов капитала

Такие программы LLM, как GPT-4 от OpenAI, Gemini (Google) или Llama (Meta), печально известны тем, что для их разработки и поддержки требуются огромные объемы данных и вычислительной мощности.

Хотя компании не раскрывают точную стоимость, предполагается, что обучение этих моделей может обойтись в сотни миллионов долларов.

Среди них Google, OpenAI, Anthropic и xAI Илона Маска. После того, как Трамп вступил в должность, OpenAI объявила о партнерстве с SoftBank и другими партнерами, чтобы инвестировать 500 миллиардов долларов в инфраструктуру ИИ в течение следующих пяти лет.

Однако благодаря дистилляции разработчики и компании могут получить доступ к мощным возможностям больших моделей за малую часть стоимости. Это позволяет приложениям ИИ быстро работать на таких устройствах, как ноутбуки или смартфоны.

|

Модель метода «дистилляции» в обучении моделей ИИ. Фото: arXiv. |

Фактически , WSJ предполагает, что после успеха DeepSeek руководители и инвесторы Кремниевой долины пересматривают свои бизнес-модели и задаются вопросом, стоит ли по-прежнему лидировать в отрасли.

«Выгодно ли с экономической точки зрения быть первым, если это обходится в восемь раз дороже, чем быть последователем?» — задается вопросом Майк Вольпи, опытный руководитель в сфере технологий и венчурный капиталист в Hanabi Capital.

ИТ-директора ожидают, что в ближайшие годы будет создано множество высококачественных приложений ИИ с использованием метода «дистилляции».

В частности, исследователи из компании Hugging Face, занимающейся разработкой искусственного интеллекта, начали пытаться построить модель, похожую на модель DeepSeek. «Самое простое для воспроизведения — это процесс дистилляции», — сказал старший научный сотрудник Льюис Танстолл.

Модели искусственного интеллекта от OpenAI и Google по-прежнему лидируют в рейтингах, широко используемых в Кремниевой долине.

Технологические гиганты способны сохранять преимущество в самых передовых системах, проводя самые оригинальные исследования. Однако многие потребители и предприятия готовы довольствоваться немного худшей технологией по гораздо более низкой цене.

|

Метод «дистилляции» — не новая идея, но успех DeepSeek доказал, что недорогие модели ИИ могут быть столь же эффективными, как и модели стоимостью в миллиарды долларов. Фото: Shutterstock. |

Хотя дистилляция позволяет создавать хорошо функционирующие модели, многие эксперты предупреждают, что она имеет определенные ограничения.

«Дистилляция приносит интересный компромисс. Когда вы уменьшаете модель, вы неизбежно сокращаете ее возможности», — объясняет Ахмед Авадаллах из Microsoft Research.

По словам Авадаллаха, модель дистилляции может быть очень хороша для обобщения электронных писем, но в то же время она совершенно не подходит для решения других задач.

Между тем Дэвид Кокс, вице-президент по моделированию искусственного интеллекта в IBM Research, заявил, что большинству предприятий не нужны гигантские модели для запуска своих продуктов.

Упрощенные модели теперь достаточно мощны, чтобы использоваться в качестве чат-ботов для обслуживания клиентов или работать на небольших устройствах, таких как телефоны.

«Если вы можете сократить расходы, сохранив при этом желаемую производительность, нет причин этого не делать», — добавил Кокс.

Источник: https://znews.vn/ky-thuat-chung-cat-ai-dang-dat-ra-cau-hoi-lon-post1535517.html

Комментарий (0)