Генеральный директор Truepic Джеффри Макгрегор заявил, что инцидент — лишь вершина айсберга. «В социальных сетях будет появляться всё больше контента, генерируемого искусственным интеллектом, и мы к этому не готовы», — сказал Макгрегор.

По данным CNN, Truepic хочет решить эту проблему, предложив технологию, которая, как утверждается, аутентифицирует медиафайлы на момент их создания с помощью Truepic Lens. Приложение для сбора данных сообщит пользователям дату, время, место и устройство, использованное для создания изображения, а также применит цифровую подпись для проверки того, является ли изображение естественным или сгенерировано искусственным интеллектом.

Поддельное фото взрыва в Пентагоне стало вирусным в Twitter

Truepic, компания, основанная в 2015 году и поддерживаемая Microsoft, заявила, что видит интерес со стороны неправительственных организаций , медиакомпаний и даже страховщиков, желающих подтвердить законность претензий.

Макгрегор утверждает, что когда все можно будет подделать, когда искусственный интеллект достигнет пика качества и доступности, мы перестанем знать, какая реальность находится в сети.

Такие технологические компании, как Truepic, уже много лет борются с дезинформацией в интернете. Но появление нового поколения инструментов искусственного интеллекта, способных генерировать изображения и текст по команде пользователя, сделало эту проблему ещё более актуальной. Ранее в этом году широко распространялись фейковые изображения Папы Франциска в пуховике Balenciaga и ареста бывшего президента США Дональда Трампа. Оба инцидента оставили миллионы людей в недоумении относительно потенциальной опасности искусственного интеллекта.

Некоторые законодатели призывают технологические компании решить эту проблему, маркируя контент, создаваемый искусственным интеллектом. Вице-президент Европейской комиссии (ЕК) Вера Юрова заявила, что такие компании, как Google, Meta, Microsoft и TikTok, присоединились к добровольному кодексу Европейского союза (ЕС) по борьбе с дезинформацией.

Все большее число стартапов и технологических гигантов, в том числе те, которые внедряют генеративный ИИ в свои продукты, пытаются внедрить стандарты и решения, которые помогут людям определить, было ли изображение или видео создано с помощью ИИ.

Но поскольку технологии искусственного интеллекта развиваются быстрее, чем люди могут за ними поспеть, неясно, смогут ли эти решения полностью решить проблему. Даже OpenAI, компания, стоящая за Dall-E и ChatGPT, признала, что её собственные усилия по распознаванию текста, созданного ИИ, несовершенны.

Компании, разрабатывающие решения, используют два подхода к решению этой проблемы. Первый основан на разработке программ для распознавания изображений, созданных ИИ, после их создания и публикации в интернете. Второй фокусируется на маркировке изображения как настоящего или созданного ИИ с помощью определённого типа цифровой подписи.

Reality Defender и Hive Moderation работают над первым вариантом. С помощью их платформы пользователи могут загружать изображения для сканирования и получать анализ, показывающий процентное соотношение подлинности фотографии и её создания с помощью искусственного интеллекта.

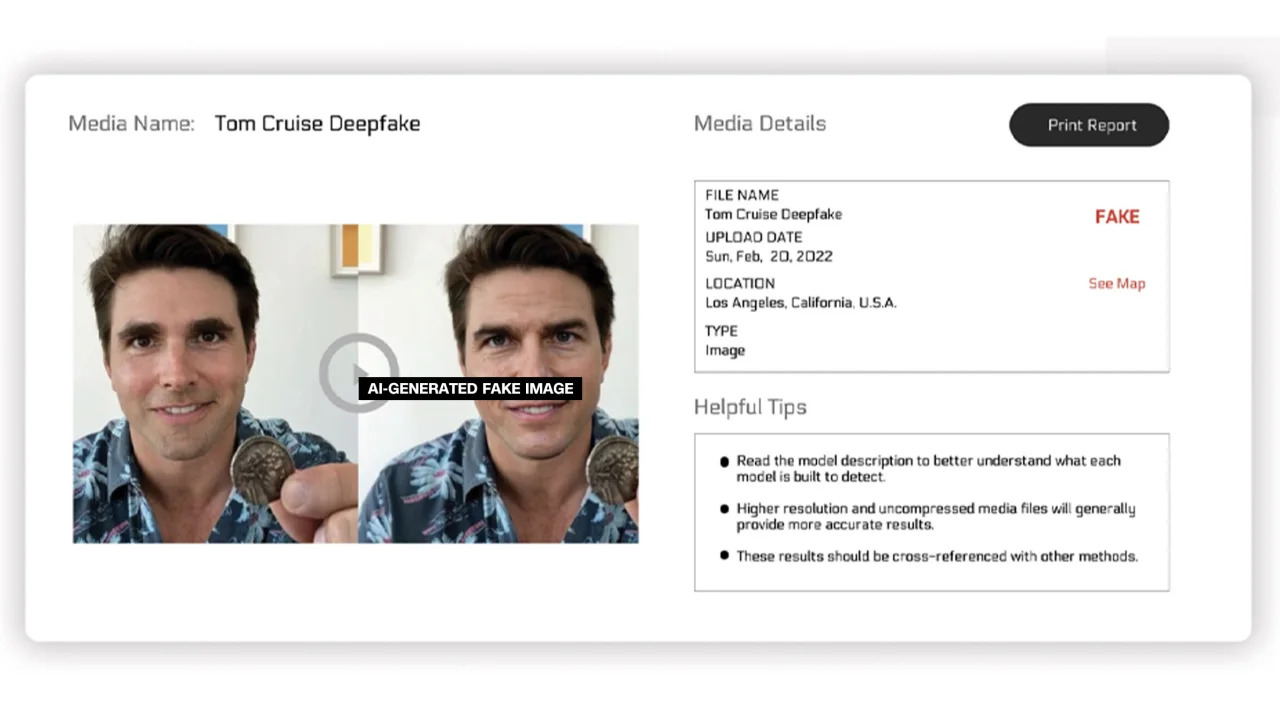

Компания Reality Defender заявила, что использует собственную технологию дипфейка и генеративного анализа контента для обнаружения видео, аудио и изображений, сгенерированных ИИ. В качестве примера компания Reality Defender продемонстрировала дипфейк-изображение Тома Круза, которое на 53% оказалось «подозрительным», поскольку у человека на изображении было искажено лицо, что часто встречается на смонтированных фотографиях.

Помеченные изображения, созданные с помощью ИИ

Эти сервисы предлагают как бесплатные, так и платные версии. Hive Moderation заявляет, что взимает 1,50 доллара за 1000 изображений. Realty Defender заявляет, что цены могут варьироваться в зависимости от ряда факторов, особенно в случаях, когда клиентам требуется экспертиза и поддержка компании. Генеральный директор Reality Defender Бен Колман отмечает, что риск удваивается с каждым месяцем, поскольку любой может создавать поддельные фотографии с помощью инструментов искусственного интеллекта.

Несколько других компаний работают над добавлением к изображениям своего рода метки, подтверждающей их подлинность или сгенерированную искусственным интеллектом. До сих пор эта работа в значительной степени продвигалась Альянсом по подлинности и происхождению контента (C2PA).

Ассоциация C2PA была основана в 2021 году для разработки технического стандарта сертификации происхождения и истории цифровых медиа. Она объединяет инициативу Adobe по аутентификации контента (CAI) и проект Origin, возглавляемый Microsoft и BBC, с акцентом на борьбу с дезинформацией в цифровых новостях. Среди других компаний, участвующих в C2PA, — Truepic, Intel и Sony.

Основываясь на принципах C2PA, CAI выпустит инструменты с открытым исходным кодом для компаний, которые позволят им создавать учетные данные контента (метаданные), содержащие информацию об изображениях. Согласно веб-сайту CAI, это позволит создателям открыто делиться информацией о том, как они создали изображение. Таким образом, конечные пользователи смогут получить доступ к контексту, в котором будет указано, кто, что и как изменил изображение, а затем самостоятельно оценить его аутентичность.

Многие компании уже интегрировали стандарт C2PA и инструменты CAI в свои приложения. Adobe Firefly, новый инструмент обработки изображений на базе ИИ, добавленный в Photoshop, соответствует стандарту C2PA благодаря функции Content Credentials. Microsoft также объявила, что изображения и видео, созданные с помощью Bing Image Creator и Microsoft Designer, в ближайшие месяцы будут содержать криптографические подписи.

В мае Google анонсировала функцию «Об этом изображении», которая позволяет пользователям узнать, когда изображение впервые появилось в Google и где его можно увидеть. Поисковый гигант также объявил, что каждое изображение, сгенерированное искусственным интеллектом Google, будет содержать разметку в исходном файле, которая «добавит контекст», если изображение будет найдено на другом сайте или платформе.

Пока технологические компании пытаются решить проблемы, связанные с изображениями, созданными с помощью ИИ, и целостностью цифровых медиа, эксперты в этой области подчеркивают, что для решения этой проблемы компаниям необходимо сотрудничать друг с другом и с правительствами. Тем не менее, технологические компании спешат разрабатывать ИИ, несмотря на риски.

Ссылка на источник

![[Фото] Женьшень горы Дан — драгоценный дар природы земле Кинь Бак](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F30%2F1764493588163_ndo_br_anh-longform-jpg.webp&w=3840&q=75)

Комментарий (0)