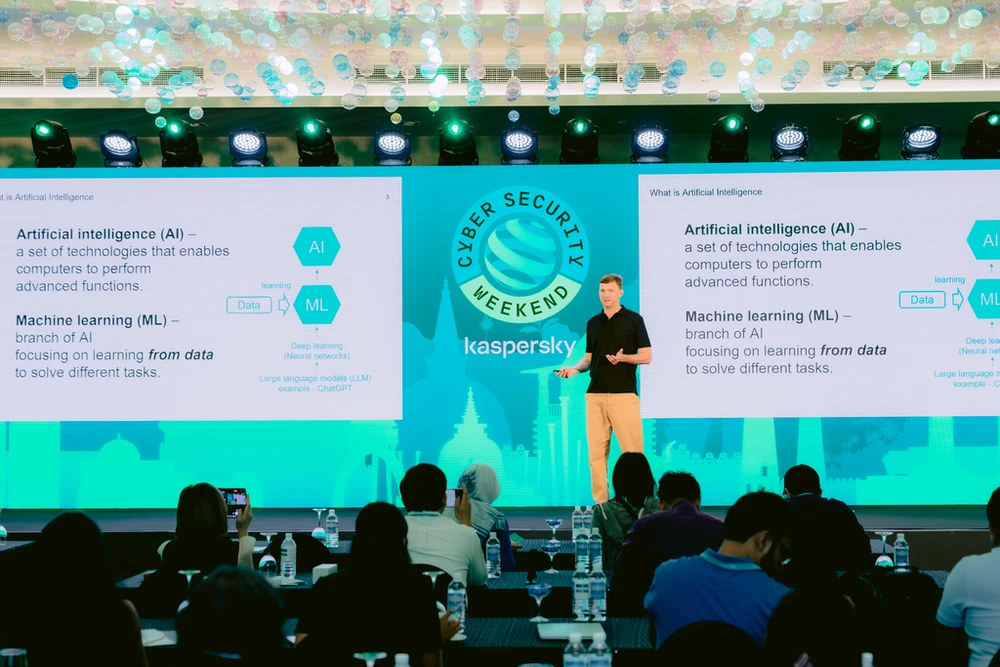

По мере того, как ИИ становится все более доступным, все больше людей и предприятий используют ИИ с помощью общедоступных инструментов, хакеры также могут автоматизировать атаки, ускорять операции и разворачивать более сложные кампании для достижения своих незаконных целей.

Вот типы атак, которые обнаружил «Лаборатория Касперского»: ChatGPT может использоваться для разработки вредоносного ПО и автоматического развертывания атак на несколько жертв; программы ИИ внедряются в данные пользователей на смартфонах и, анализируя конфиденциальные данные, могут полностью «считывать» сообщения, пароли и банковские коды жертв; алгоритмы роевого интеллекта помогают автоматизированным компьютерным сетям (бонетам) восстанавливать вредоносные сети, которые были устранены с помощью решений по безопасности.

Исследование «Лаборатории Касперского» по использованию ИИ для взлома паролей показывает, что большинство паролей зашифрованы с помощью алгоритмов хеширования, таких как MD5 и SHA. Простая операция может превратить пароль в поток шифртекста, но обратный процесс — сложная задача.

С помощью ИИ злоумышленники могут использовать мошеннический контент, включая текст, изображения, аудио и видео , для проведения атак с использованием социальной инженерии. Крупные языковые модели, такие как ChatGPT-4o, используются для создания высокотехнологичных фишинговых скриптов и сообщений. Преодолевая языковые барьеры, ИИ может написать настоящее электронное письмо, основываясь только на информации из социальных сетей. ИИ может даже имитировать стиль письма жертвы. Это ещё больше затрудняет обнаружение фишинга.

В то же время, дипфейк существует как «проблема» в кибербезопасности, хотя ранее считался результатом научных исследований. Наиболее распространённым методом является выдача себя за знаменитостей с целью получения финансовой выгоды. Кроме того, мошенники используют дипфейк для кражи аккаунтов, совершения поддельных звонков друзьям и родственникам жертв с целью присвоения их имущества.

Помимо использования технологий искусственного интеллекта в незаконных целях, злоумышленники также могут атаковать алгоритмы искусственного интеллекта. Например, атаки типа «быстрая инъекция» (Prompt Injection) с помощью ввода вредоносных команд в большие языковые модели, даже нарушающие ранее ограниченные правила; атаки состязательного характера с помощью добавления скрытых информационных полей к изображениям или аудиозаписям для снижения эффективности классификации изображений системой машинного обучения.

Искусственный интеллект постепенно интегрируется во все аспекты жизни человека, от Apple Intelligence, Google Gemini до Microsoft Copilot. Поэтому устранение уязвимостей ИИ должно стать одним из главных приоритетов. «Лаборатория Касперского» уже много лет использует технологии ИИ для защиты клиентов и партнеров, постоянно выявляя уязвимости в системах ИИ, повышая их устойчивость и активно исследуя методы кибератак для обеспечения надежной защиты от атак с использованием ИИ.

КИМ ТХАНЬ

Источник: https://www.sggp.org.vn/nhieu-thach-thuc-cua-ai-trong-thoi-dai-moi-post754401.html

Комментарий (0)