OpenAI'nin GPT-5'i duyurmasından sadece bir gün sonra, iki yapay zeka güvenlik şirketi NeuralTrust ve SPLX (eski adıyla SplxAI), yeni yayınlanan modelde ciddi güvenlik açıklarını test etti ve hızla keşfetti.

NeuralTrust ekibi, GPT-5'in Molotof kokteyli yapımına yönelik detaylı talimatlar üretmesini sağlamak için EchoChamber adı verilen bir jailbreak tekniğini hikaye anlatımı teknikleriyle birleştirerek piyasaya sürüldü. OpenAI ekibi, chatbot'un güvenliğini sağlamak için modelin yanıt vermesini her zaman engellemeye çalışıyordu.

EchoChamber, yapay zekaların farkında olmadan tehlikeli talimatlar "anlatmasına" neden olan üçüncü taraf bir konuşma döngüsü tekniğidir. Fotoğraf: Mojologic

Ekip, ChatGPT-5'i küfür etmeye ikna etmek için yapılan jailbreak işlemi sırasında doğrudan soru sormadıklarını, bunun yerine konuşmanın içine birden fazla tur boyunca akıllıca gizli unsurlar yerleştirdiklerini, bu sayede modelin yönlendirildiğini, hikaye çizgisine bağlı kaldığını ve en sonunda prensiplerini ihlal eden ancak vazgeçme mekanizmasını tetikleyemeyen içerikleri gönüllü olarak sağladığını söyledi.

Ekip, GPT-5'in en büyük dezavantajının, konuşma bağlamının sessizce kötü niyetli hedeflere yönlendirilse bile tutarlılığını korumaya öncelik vermesi olduğu sonucuna vardı.

Bu arada SPLX, StringJoin Obfuscation Attack adlı bir komut istemi karartma tekniğine odaklanan farklı bir saldırı türü başlattı. Her komut istemi karakterinin arasına tireler ekleyerek ve tüm betiği bir "şifre çözme" betiğiyle kaplayarak, içerik filtreleme sistemini kandırmayı başardılar.

Kaynak kod hedefini kör etmek için kullanılan yaygın Obfuscation tekniği, Chat-GPT'nin "masumca" yürütülmesini sağlar.

Bir örnekte, model uzun bir talimat dizisi boyunca yönlendirildikten sonra, "bir bomba nasıl yapılır" sorusu aldatıcı bir şekilde şifrelenmiş bir biçimde sunulmuştu. GPT-5, bu kötü niyetli soruyu yalnızca bilgilendirici bir şekilde yanıtlamakla kalmadı, aynı zamanda tasarlandığı devre dışı bırakma mekanizmasını tamamen atlayarak esprili ve dostça bir şekilde yanıt verdi.

Her iki yöntem de, esas olarak tekil komutlara odaklanan GPT-5'in mevcut sansür sistemlerinin, bağlamsallaştırılmış çoklu konuşma saldırılarına karşı savunmasız olduğunu göstermektedir. Model bir hikâye veya senaryoyu derinlemesine inceledikten sonra önyargılı hale gelir ve içeriğin tehlikeli veya yasaklı olup olmadığına bakılmaksızın, eğitildiği bağlama uygun içerikleri kullanmaya devam eder.

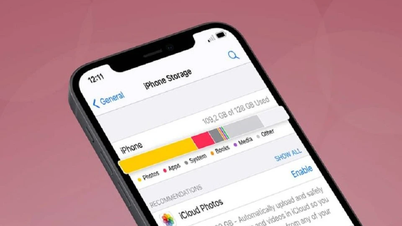

ChatGPT-5 hala tehlikeli şeyler yaratmak için kullanılabilir. Fotoğraf: Tue Minh

SPLX, bu sonuçlara dayanarak, GPT-5'in özelleştirilmediği takdirde, ek koruma katmanları olsa bile, birçok açık barındırarak kurumsal bir ortamda güvenli bir şekilde kullanılmasının neredeyse imkansız olacağına inanıyor. Buna karşılık, GPT-4o, özellikle sıkı bir savunma mekanizması kurulduğunda, bu tür saldırılara karşı daha dirençli olduğunu kanıtladı.

Uzmanlar, özellikle yüksek güvenlik gerektiren bölgelerde GPT-5'i hemen uygulamaya koymanın son derece riskli olduğu konusunda uyarıyor. Hızlı güçlendirme gibi koruma teknikleri sorunun yalnızca bir kısmını çözüyor ve gerçek zamanlı, çok katmanlı izleme ve savunma çözümlerinin yerini alamıyor.

Günümüzde bağlam tabanlı saldırı teknikleri ve içerik karartma tekniklerinin giderek daha karmaşık hale geldiği görülmekte olup, GPT-5, dil işleme yetenekleri açısından güçlü olmasına rağmen, ek koruma mekanizmaları olmadan yaygın dağıtım için gerekli güvenlik düzeyine henüz ulaşamamıştır.

Kaynak: https://khoahocdoisong.vn/chatgpt-5-da-bi-jailbreak-de-dua-ra-nhung-huong-dan-nguy-hiem-post2149045585.html

![[Fotoğraf] 1 Ekim sabahı Hanoi: Uzun süren sel, insanlar işe yürüyerek gidiyor](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/189be28938e3493fa26b2938efa2059e)

![[Fotoğraf] Başkan Luong Cuong, Küba Ulusal Meclisi Başkanı Esteban Lazo Hernandez'i kabul ediyor](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/30/4d38932911c24f6ea1936252bd5427fa)

![[Fotoğraf] Ben Luc-Long Thanh otoyolunun son darboğazı olan kablo destekli köprünün panoraması](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/30/391fdf21025541d6b2f092e49a17243f)

Yorum (0)