Професор Йошуа Бенхіо, один із науковців , які заклали основу для розвитку штучного інтелекту (ШІ), розповів про «безпеку ШІ» в рамках високорівневого технологічного семінару «Безпечний ШІ – формування відповідальних інновацій» у другій половині дня 5 грудня в Ханої.

В рамках заходу професор Йошуа Бенхіо провів діалог на тему «Відповідальний штучний інтелект та важливість штучного інтелекту в освіті », ставши свідком церемонії запуску Комітету з етики штучного інтелекту при В'єтнамській асоціації програмного забезпечення та інформаційно-технологічних послуг (VINASA).

Професор Йошуа Бенхіо вважає, що найважливіше – це те, що технологічний розвиток має йти пліч-о-пліч із захистом прав людини та сталим розвитком суспільства. Штучний інтелект розвивається стрімкими темпами, ефективність обробки даних зросла на 30%, продуктивність алгоритмів потроїлася, інвестиції в цю сферу досягли в середньому 100 мільярдів доларів США на рік, а стандартні оцінки показують, що можливості ШІ перевершили людські можливості в оволодінні мовою та обробці даних.

Однак, цей швидкий прогрес порушує тривожні питання щодо здатності керувати системами штучного інтелекту, які розумніші за людей. У цьому контексті виникає важливе етичне питання: хто повинен визначати цілі ШІ? Терміновість розуміння та належних дій є не лише відповідальністю, але й життєво важливим фактором для майбутнього людства.

Один із важливих принципів, висунутих професором Йошуа Бенхіо, полягає в тому, що ШІ потрібно створювати як інструмент для служіння людям, а не як «агентів», здатних ставити власні цілі та діяти для їх досягнення, оскільки цілі ШІ можуть суперечити початковим людським намірам або виходити за їх межі.

Тому, за словами професора Йошуа Бенджіо, нам слід уникати розробки «інстинктів виживання» для систем штучного інтелекту. Це означає, що нам не слід розробляти системи штучного інтелекту, схожі на людські, з емоціями, зовнішністю і навіть свідомістю, самовизначенням та автономією.

У звіті Всесвітнього економічного форуму за 2023 рік про майбутнє ринків праці зазначається, що до 2025 року очікується, що штучний інтелект створить 12 мільйонів нових робочих місць у світі. Інше дослідження McKinsey також показало, що штучний інтелект може сприяти створенню від 20 до 50 мільйонів нових робочих місць у світі до 2030 року.

За словами голови правління корпорації FPT Труонг Гіа Бінь, штучний інтелект слід розглядати як «союзника», а не як загрозу, яка забере робочі місця. Вивчення та застосування штучного інтелекту надзвичайно важливі для збереження конкурентоспроможності на ринку праці; це включає базове розуміння штучного інтелекту, машинного навчання, науки про дані, а також навички вирішення проблем та аналізу для ефективної роботи з системами штучного інтелекту.

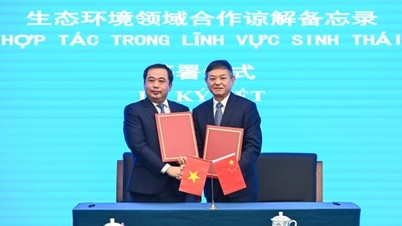

Також у рамках семінару VINASA оголосила про створення Комітету з етики штучного інтелекту. На заході були присутні професор Йошуа Бенхіо (Монреальський університет та Інститут Міла), керівник VINASA, та керівники кількох підприємств-членів VINASA.

Створення Комітету з етики штучного інтелекту демонструє зусилля В'єтнаму у побудові екосистеми штучного інтелекту, де інновації розвиваються в етичних рамках, забезпечуючи глобальну конкурентоспроможність та захищаючи соціальні цінності.

Комітет має завдання керувати дорожньою картою розвитку штучного інтелекту у В'єтнамі, забезпечувати етичне, інноваційне та соціально корисне впровадження штучного інтелекту, а також сприяти створенню сприятливого правового середовища для штучного інтелекту.

Професор Йошуа Бенхіо є однією з найвпливовіших людей у світі у створенні основи для того, щоб штучний інтелект став практичною технологією, що широко застосовується в таких галузях, як обробка природної мови (НЛП), комп'ютерний зір, машинне навчання та робототехніка. У 1993 році він заснував Науково-дослідний інститут штучного інтелекту Міла, який значною мірою сприяв перетворенню Монреаля (Канада) на світовий центр технологій глибокого навчання. |

Згідно з ВНА

Джерело: https://doanhnghiepvn.vn/cong-nghe/giao-su-khai-sinh-ai-lan-dau-sang-viet-nam-chia-se-ve-dao-duc-ai/20241206103838021

Коментар (0)