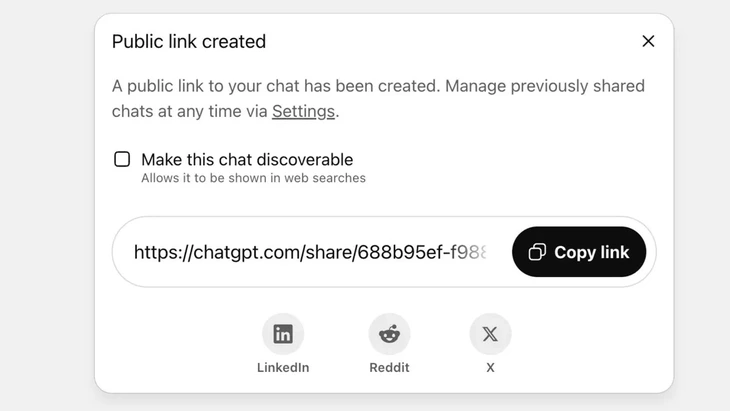

Функція поширення чатів через публічне посилання на ChatGPT – Фото: Techradar

ChatGPT щодня обробляє понад 2,5 мільярда запитів від користувачів з усього світу, що свідчить про зростаючу популярність цього чат-бота.

Однак цей інструмент зіткнувся з різкою негативною реакцією з боку користувачів, оскільки функція «поширення» призвела до того, що тисячі розмов стали причиною витоку конфіденційної інформації до Google та деяких пошукових систем в Інтернеті.

Високий ризик для безпеки

Пан Ву Нгок Сон, керівник технологічного відділу Національної асоціації кібербезпеки (NCA), оцінив вищезгаданий інцидент як високий рівень ризику для користувачів ChatGPT.

«Вищезазначений інцидент не обов’язково є технічним недоліком, оскільки користувач проявляє певну ініціативу, натискаючи кнопку «поділитися». Однак, можна сказати, що проблема полягає в дизайні продукту чат-бота на основі штучного інтелекту, який заплутав користувачів, і не було достатньо потужних заходів попередження про ризик витоку персональних даних, якщо користувачі поділяться ними», – проаналізував пан Ву Нгок Сон.

У ChatGPT ця функція реалізується після того, як користувач вирішує поділитися чатом через публічне посилання, контент зберігатиметься на сервері OpenAI як публічний веб-сайт (chatgpt.com/share/...), для доступу не потрібні логін чи пароль.

Сканери Google автоматично сканують та індексують ці сторінки, завдяки чому вони відображаються в результатах пошуку, включаючи конфіденційний текст, зображення чи дані чату.

Багато користувачів не усвідомлювали ризику, думаючи, що діляться чатом з друзями чи контактами. Це призвело до викриття тисяч розмов, які в деяких випадках містили конфіденційну особисту інформацію.

Хоча OpenAI швидко видалив цю функцію наприкінці липня 2025 року після негативної реакції спільноти, все ж знадобився час для координації з Google щодо видалення старих індексів. Особливо з огляду на складну систему зберігання даних, яка включає кеш-сервери Google, це неможливо зробити швидко.

Не ставтеся до чат-ботів зі штучним інтелектом як до «чорної скриньки безпеки»

Експерт з безпеки даних Ву Нгок Сон - керівник відділу технологій Національної асоціації кібербезпеки (NCA) - Фото: CHI HIEU

Витік тисяч журналів чатів може становити ризики для користувачів, такі як розкриття особистих та ділових таємниць; пошкодження репутації, фінансові ризики або навіть загрози безпеці через розкриття домашніх адрес.

«Чат-боти на базі штучного інтелекту корисні, але не є «чорною скринькою», оскільки спільні дані можуть існувати в мережі вічно, якщо їх не контролювати».

Вищезазначений інцидент, безумовно, є уроком як для постачальників, так і для користувачів. Інші постачальники послуг штучного інтелекту можуть повчитися на цьому досвіді та розробити функції з чіткішими та прозорішими попередженнями.

Водночас, користувачам також необхідно проактивно обмежувати неконтрольовану публікацію ідентифікаційної або особистої інформації на платформах штучного інтелекту», – рекомендував експерт з безпеки Ву Нгок Сон.

За словами експертів з безпеки даних, вищезгаданий інцидент демонструє необхідність правових коридорів та стандартів кібербезпеки для ШІ. Постачальникам та розробникам ШІ також необхідно розробляти системи, які забезпечують безпеку, уникаючи ризику витоку даних, такого як: витік через серйозні вразливості; вразливості програмного забезпечення, що призводять до атак на бази даних; поганий контроль, що призводить до отруєння, зловживання для відповідей на неправдиві та перекручені запитання.

Користувачам також потрібно контролювати обмін особистою інформацією зі штучним інтелектом, не поширюючи конфіденційну інформацію. У разі реальної потреби доцільно використовувати анонімний режим або активно шифрувати інформацію, щоб уникнути прямого пов’язування даних з конкретними особами.

Джерело: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Фото] Генеральний секретар То Лам взяв участь у В'єтнамсько-Великій економічній конференції високого рівня](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825773922_anh-1-3371-jpg.webp)

![[Фото] Третій патріотичний змагальний з'їзд Центральної комісії внутрішніх справ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761831176178_dh-thi-dua-yeu-nuoc-5076-2710-jpg.webp)

![[Фото] Зворушлива сцена, як тисячі людей рятують набережну від бурхливої води](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825173837_ndo_br_ho-de-3-jpg.webp)

![[Фото] Голова Національних зборів Чан Тхань Ман приймає іноземних послів, які прийшли попрощатися](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761820977744_ndo_br_1-jpg.webp)

![[Фото] Генеральний секретар То Лам зустрівся з колишнім прем'єр-міністром Великої Британії Тоні Блером](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761821573624_tbt-tl1-jpg.webp)

Коментар (0)