إس جي بي

بعد أن بدأت أوروبا في صياغة وإطلاق أول قانون في العالم بشأن الذكاء الاصطناعي، أطلقت شركات التعدين الأربع الرائدة في مجال البيانات على الإنترنت في الولايات المتحدة مجموعة تسمى منتدى Frontier Model.

|

| الهدف الأساسي لمنتدى نموذج فرونتر هو تعزيز الذكاء الاصطناعي بمسؤولية. الصورة: THINKWITHNICHE |

الأطراف تقترب من بعضها البعض

صرحت المجموعة، التي تضم أنثروبيك وجوجل ومايكروسوفت وأوبن إيه آي، مالكة تشات جي بي تي، بأن الأهداف الأساسية لمنتدى رواد النماذج هي المساعدة في الحد من مخاطر منصات الذكاء الاصطناعي وتطوير معايير القطاع. وسيُنشئ منتدى رواد النماذج منتدىً جديدًا لتحقيق الأهداف الرئيسية التالية: تعزيز أبحاث سلامة الذكاء الاصطناعي لدعم التطوير، وتخفيف المخاطر، وتوحيد تقييمات ومستويات السلامة؛ وتحديد أفضل الممارسات لتطوير النماذج ونشرها؛ ومساعدة الجمهور على فهم طبيعة هذه التقنية وقدراتها وقيودها وتأثيراتها؛ والتعاون مع صانعي السياسات والأكاديميين والمجتمع المدني والشركات لتبادل المعرفة حول المخاطر والسلامة.

لطالما قاومت شركات التكنولوجيا العملاقة تشديد اللوائح التنظيمية، لكن هذه المرة، غيّر قطاع التكنولوجيا موقفه تجاه المخاوف المتزايدة بشأن مخاطر الذكاء الاصطناعي. وتعهدت الشركات المشاركة في مبادرة منتدى نموذج فرونتر بمشاركة أفضل الممارسات بين الشركات، وإتاحة المعلومات للجمهور للحكومات والمجتمع المدني.

سيركز منتدى نموذج فرونتيير، تحديدًا، على منصات التعلم الآلي واسعة النطاق، وإن كانت لا تزال في طور النشوء، والتي ترتقي بالذكاء الاصطناعي إلى مستويات جديدة من التطور، وهو ما يُمثل أيضًا عامل خطر محتمل. بالإضافة إلى ذلك، سيدعم منتدى نموذج فرونتيير تطوير تطبيقات تُعالج التحديات المجتمعية الرئيسية، مثل: التخفيف من آثار تغير المناخ والتكيف معه، والكشف المبكر عن السرطان والوقاية منه، ومواجهة التهديدات السيبرانية.

مجال للتدمير المحتمل

يأتي إعلان الشركات الأمريكية عن منتدى "نموذج الحدود" بعد أيام قليلة من تحذير أعضاء مجلس الشيوخ الأمريكي في 25 يوليو/تموز من خطر استخدام الذكاء الاصطناعي في هجمات بيولوجية، وذلك خلال جلسة استماع أمام لجنة فرعية تابعة للجنة القضائية بمجلس الشيوخ الأمريكي. ومؤخرًا، تعهدت سبع شركات تقنية كبرى، منها OpenAI وAlphabet وMeta، طواعيةً أمام البيت الأبيض بتطوير نظام لتحديد جميع المحتويات، من نصوص وصور ومقاطع صوتية إلى مقاطع فيديو، التي يُنتجها الذكاء الاصطناعي، لضمان الشفافية للمستخدمين، ولضمان أمان هذه التقنية.

أشار داريو أمودي، الرئيس التنفيذي لشركة AI Anthropic، إلى أنه على الرغم من أن الذكاء الاصطناعي ليس قادرًا بعد على إنتاج أسلحة بيولوجية، إلا أنه يُمثل خطرًا "متوسط المدى" ويشكل تهديدًا خطيرًا للأمن القومي الأمريكي خلال العامين أو الثلاثة أعوام القادمة. والسبب هو أن من ينفذون هجمات واسعة النطاق بالأسلحة البيولوجية لم يعودوا يقتصرون على ذوي المعرفة المتخصصة في هذا المجال.

يشهد العالم طفرةً هائلةً في المحتوى المُنتَج بواسطة تقنيات الذكاء الاصطناعي المُولِّدة. من الولايات المتحدة الأمريكية، وأوروبا، وصولًا إلى آسيا، تُشدّد الضوابط تدريجيًا. ووفقًا لشبكة CNN، سيُقيم مجلس الشيوخ الأمريكي، ابتداءً من سبتمبر/أيلول، سلسلةً من تسع ورش عمل إضافية للأعضاء للتعرف على كيفية تأثير الذكاء الاصطناعي على الوظائف والأمن القومي والملكية الفكرية. وقبل الولايات المتحدة، وفي حال التوصل إلى اتفاق، سيُقرّ الاتحاد الأوروبي أول قانون في العالم لإدارة الذكاء الاصطناعي العام المقبل، ومن المتوقع أن يدخل حيز التنفيذ عام ٢٠٢٦.

لا شك أن فوائد الذكاء الاصطناعي للمجتمع لا تُنكر، إلا أن هناك تحذيرات متزايدة بشأن المخاطر المحتملة لهذه التقنية الجديدة. في يونيو/حزيران، أيّد الأمين العام للأمم المتحدة أنطونيو غوتيريش مقترحًا قدّمه عدد من المسؤولين التنفيذيين في مجال الذكاء الاصطناعي لإنشاء هيئة رقابية دولية للذكاء الاصطناعي، على غرار الوكالة الدولية للطاقة الذرية.

خلال منتدى فرونتر موديل، صرّح براد سميث، رئيس مايكروسوفت، بأن هذه المبادرة تُمثّل خطوةً مهمةً في توحيد جهود شركات التكنولوجيا لتعزيز الاستخدام المسؤول للذكاء الاصطناعي بما يعود بالنفع على البشرية جمعاء. وبالمثل، قالت آنا ماكانجو، نائبة رئيس الشؤون العالمية في OpenAI، إن تقنيات الذكاء الاصطناعي المتقدمة قادرة على تحقيق فوائد جمة للمجتمع، وهذا يتطلب رقابةً وحوكمة.

[إعلان 2]

مصدر

![[صورة] بانوراما الجولة النهائية لجوائز العمل المجتمعي لعام 2025](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763206932975_chi-7868-jpg.webp)

![[صورة] رئيس الوزراء فام مينه تشينه يلتقي بممثلي المعلمين المتميزين](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

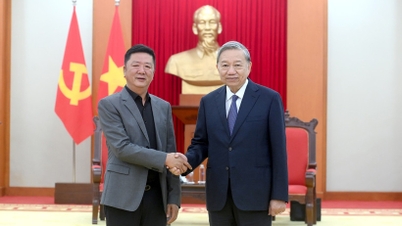

![[صورة] الأمين العام تو لام يستقبل نائب رئيس مجموعة Luxshare-ICT (الصين)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

تعليق (0)