(Dan Tri) - Množství dat používaných k trénování umělé inteligence je téměř vyčerpáno, což nutí vědce používat umělou inteligenci k vzájemnému trénování. To by mohl být průlom, který by umělé inteligenci pomohl překonat lidskou inteligenci.

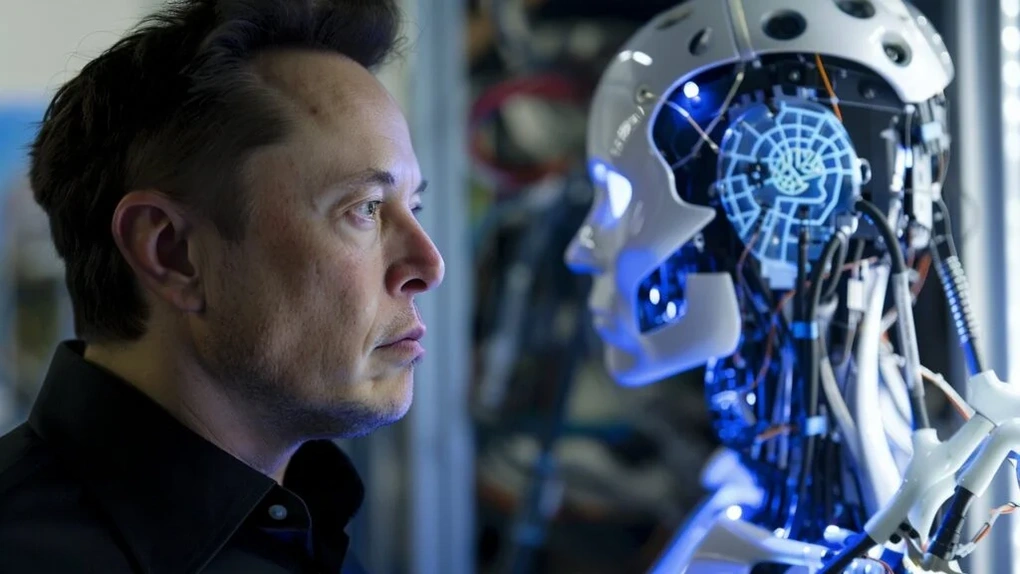

Elon Musk navrhuje nové způsoby vývoje umělé inteligence, které by mohly být nebezpečné

Technologický miliardář Elon Musk, zakladatel společnosti zabývající se umělou inteligencí xAI, právě zveřejnil šokující informace o procesu trénování a vzdělávání modelů umělé inteligence (AI).

„V oblasti vzdělávání a výcviku umělé inteligence jsme nyní vyčerpali veškeré lidské znalosti. To se v podstatě děje od loňského roku,“ odpověděl Elon Musk v rozhovoru vysílaném živě na sociální síti X 9. ledna.

Modely umělé inteligence jako GPT-4, Gemini, Grok nebo Llama... jsou trénovány na základě velkého množství dat shromážděných z internetu, z vědeckých časopisů, publikovaných studií, uživatelských dat na sociálních sítích...

Elon Musk navrhuje využití dat z umělé inteligence k jejímu trénování, ale to s sebou nese mnoho potenciálních rizik (ilustrace: Getty).

Tempo vývoje modelů umělé inteligence je však tak rychlé, že množství dostupných dat již nestačí k trénování a vylepšování inteligence těchto modelů umělé inteligence.

Aby se tento problém překonal, Elon Musk navrhl řešení, kterým je přechod na používání dat generovaných samotnou umělou inteligencí k trénování modelů umělé inteligence. Jinými slovy, umělá inteligence se může trénovat sama a trénovat navzájem, aniž by se spoléhala na data poskytovaná lidmi.

„Jediný způsob, jak tento problém vyřešit, je doplnit syntetická data generovaná samotnými modely umělé inteligence a použít tato data k trénování samotné umělé inteligence,“ sdělil Elon Musk.

Systémy umělé inteligence, které se samy učí na základě syntetických dat generovaných samotnou umělou inteligencí, pomohou ušetřit náklady na vývoj a snížit závislost na lidských datech. To v mnoha lidech vyvolává obavy, že se umělá inteligence dokáže sama naučit tak, aby překonala lidskou inteligenci a byla mimo kontrolu lidstva.

Odborníci na umělou inteligenci však tvrdí, že použití syntetických dat generovaných samotnou umělou inteligencí k trénování modelů umělé inteligence může tyto modely zhroutit, pokud generovaná data postrádají kreativitu, jsou zkreslená a nejsou aktualizována nejnovějšími daty.

„Když k trénování modelů umělé inteligence používáte syntetická data, jejich výkon se postupně snižuje a výstupní data jsou neinspirativní a zkreslená,“ řekl Andrew Duncan, ředitel pro umělou inteligenci v Alan Turing Institute ve Velké Británii.

Vysoce kvalitní data jsou považována za neocenitelný „zdroj“, o který společnosti zabývající se vývojem umělé inteligence soutěží. Ne všichni vědci jsou však ochotni poskytnout své výzkumné práce k trénování modelů umělé inteligence.

Google dokázal vytvořit umělou inteligenci, která myslí a jedná přesně jako lidé

Představte si, že máte prostředky k určení osobnosti, postojů a stylu člověka a následnému vytvoření repliky této osoby pomocí umělé inteligence.

To není sci-fi, ale základní cíl průlomové studie vědců ze Stanfordské univerzity a společnosti Google.

Google dokáže během pouhých 2 hodin pohovoru vytvořit umělou inteligenci, která myslí a jedná přesně jako vy (Foto: ZipRecruiter).

Výzkumníci vytvořili repliku umělé inteligence s více než 1 000 účastníky s využitím informací z rozhovorů trvajících pouhé 2 hodiny. Tyto umělé inteligence dokáží napodobit lidské chování.

Potenciální využití tohoto vynálezu je obrovské. Tvůrci politik a firmy by mohli tuto simulaci umělé inteligence využít k předpovídání reakcí veřejnosti na nové politiky nebo produkty, místo aby se spoléhali pouze na fokusní skupiny nebo opakované průzkumy.

Vědci se domnívají, že tato technologie by mohla pomoci zkoumat sociální struktury, pilotovat intervence a rozvíjet propracované teorie lidského chování.

S sebou to však nese i určitá rizika, například etické obavy ohledně zneužití klonů umělé inteligence. Zločinci by mohli tuto umělou inteligenci zneužít k manipulaci s veřejným míněním, vydávání se za jiné osoby nebo simulování veřejných preferencí na základě falešných syntetických dat.

Tyto obavy jsou také součástí dlouhodobých obav mnohých, že šíření podobných modelů umělé inteligence by mohlo mít negativní dopady na budoucnost lidstva.

Zdroj: https://dantri.com.vn/suc-manh-so/ai-sap-dat-duoc-buoc-dot-pha-moi-co-the-vuot-qua-tri-tue-con-nguoi-20250111132229246.htm

![[Fotografie] Kde historie odboje ožívá s moderními technologiemi na akci „95 let stranické vlajky osvětlující cestu“](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/12/81c1276f52b849c8b16e2d01dd1c85e4)

![[Foto] Generální tajemník To Lam předsedá pracovnímu zasedání politbyra se stálým výborem stranického výboru Národního shromáždění](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/11/e2033912ce7a4251baba705afb4d413c)

![[Námořní zprávy] Z nákladní lodi v přístavu Long Beach (USA) spadlo více než 60 kontejnerů](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/12/c091e4bb10e54291977aab80f5a41a9c)

Komentář (0)