Podvod s imitací hlasu pomocí deepfake hlasu

V éře rychle se rozvíjející umělé inteligence se hlas – jeden z faktorů, které byly kdysi považovány za autentický důkaz – stal nebezpečným nástrojem v rukou zločinců. Technologie Deepfake umožňuje, aby se falešné hlasy podobaly skutečným lidem, a vytvářely tak sofistikované falešné hovory za účelem podvodu a přivlastnění si majetku.

Proč je deepfake hlas děsivý?

Deepfake voice je technologie, která využívá umělou inteligenci (AI) a strojové učení k vytvoření falešného hlasu, který je identický s hlasem skutečné osoby.

S podporou moderních modelů, jako jsou Tacotron, WaveNet, ElevenLabs nebo platforem pro klonování hlasu, jako je Respeecher, potřebují podvodníci k vytvoření deepfakeu s 95% spolehlivostí pouze 3–10 sekund hlasových vzorků.

Deepfake voice se stává obzvláště nebezpečným kvůli své schopnosti téměř dokonale napodobovat hlasy, od výslovnosti, intonace až po jedinečné řečové návyky každého člověka.

To obětem velmi ztěžuje rozlišení mezi skutečným a falešným hlasem, zejména pokud hlas patří jejich příbuzným, přátelům nebo nadřízeným.

Těžba hlasu je také velmi snadná, protože většina lidí dnes zveřejňuje své zvuky prostřednictvím platforem, jako je TikTok, živých přenosů na sociálních sítích, podcastů nebo online schůzek. Ještě znepokojivější je, že deepfake hlasy nezanechávají vizuální stopy, jako jsou obrázky nebo videa , což ztěžuje vyšetřování a oběti jsou zranitelné a mohou přijít o peníze.

I pár sekund hlasového vzorku dokáže vytvořit deepfake

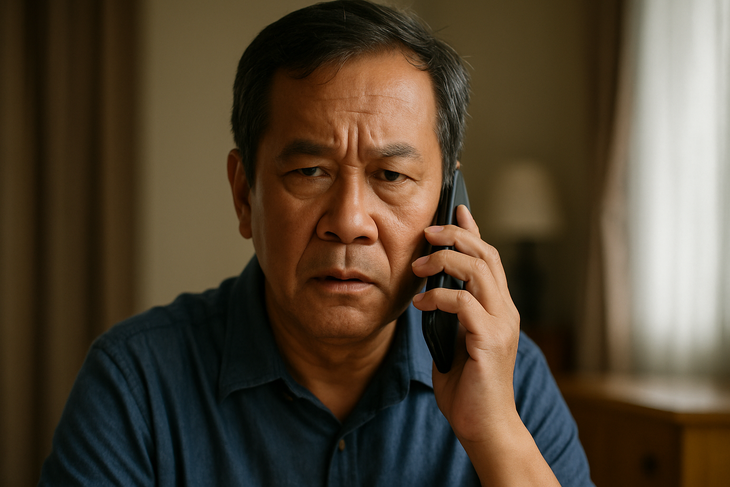

Podvody s deepfake hlasem jsou stále sofistikovanější a často využívají známý scénář: napodobování hlasu známého v nouzové situaci s cílem vyvolat paniku a donutit oběti k okamžitému převodu peněz.

Ve Vietnamu se stal případ, kdy matce zavolal její „syn“ a oznámil jí, že měl nehodu a naléhavě potřebuje peníze. Ve Spojeném království byl ředitel společnosti podveden o více než 240 000 USD poté, co si po telefonu vyslechl žádost svého „šéfa“ o převod peněz. Administrativní pracovník byl také podveden, když přijal hovor od „velkého šéfa“ s žádostí o platbu „strategickému partnerovi“...

Společným rysem těchto situací je, že falešný hlas je reprodukován přesně jako hlas příbuzného nebo nadřízeného, což oběti dává absolutní důvěru a nemá čas si to ověřit.

Vždy si to ověřte, nevěřte hned

S nárůstem počtu podvodů s deepfake hlasem se lidem doporučuje, aby nepřeváděli peníze pouze na základě hlasu po telefonu, i když zní přesně jako hlas blízké osoby. Místo toho zavolejte zpět na staré číslo nebo si před provedením jakékoli transakce ověřte informace prostřednictvím různých kanálů.

Mnoho odborníků také doporučuje nastavit si v domácnosti nebo firmě „interní heslo“ pro ověření v neobvyklých situacích.

Kromě toho je nutné omezit zveřejňování videí se zřetelnými hlasy na sociálních sítích, zejména u dlouhého obsahu. Zejména je nutné proaktivně varovat a vést zranitelné skupiny, jako jsou starší osoby nebo osoby s malým přístupem k technologiím, protože ty jsou prioritními cíli podvodů s využitím high-tech technologií.

Hlasy příbuzných, přátel a kolegů lze zfalšovat.

V mnoha zemích začaly úřady zpřísňovat řízení technologie deepfake pomocí vlastního právního rámce.

V USA několik států zakázalo používání deepfakes ve volebních kampaních nebo k šíření dezinformací. Evropská unie (EU) schválila zákon o umělé inteligenci, který vyžaduje, aby organizace byly transparentní a jasně varovaly, pokud je určitý obsah generován umělou inteligencí.

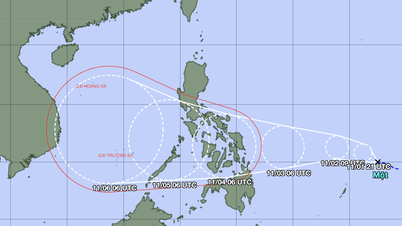

Mezitím ve Vietnamu, ačkoli neexistují žádné specifické předpisy pro deepfake hlasy, lze související činy řešit podle platných zákonů, včetně trestných činů, jako je podvod, přivlastnění si majetku, narušení soukromí nebo padělání identity.

Realita je však taková, že technologie se vyvíjí rychlostí, která dalece překračuje možnosti zákona sledovat, což zanechává mnoho mezer v legislativě, kterých mohou pachatelé zneužít.

Když hlas už není důkazem

Hlas býval něčím intimním a důvěryhodným, ale s deepfake hlasem už není platným důkazem. V době umělé inteligence musí mít každý jednotlivec znalosti o digitální obraně, proaktivně ověřovat a být vždy ostražitý, protože hovor může být pastí.

Zdroj: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

Komentář (0)