Der Umsatz von Nvidia stieg im letzten Quartal auf 44,1 Milliarden Dollar , aber eine der wichtigsten Kennzahlen des Chipgiganten ist nicht das Geld.

Stattdessen äußerten sich branchenführende Tech-CEOs, die auch Nvidias größte Kunden sind, den ganzen Mai über begeistert über das Wachstum des Tokens.

„OpenAI, Microsoft und Google erleben einen Quantensprung bei der Token-Erstellung. Microsoft hat im ersten Quartal über 100 Billionen Token verarbeitet, eine Verfünffachung im Vergleich zum Vorjahr“, sagte Colette Kress, Finanzvorstand von Nvidia.

Die grundlegendste Einheit der KI

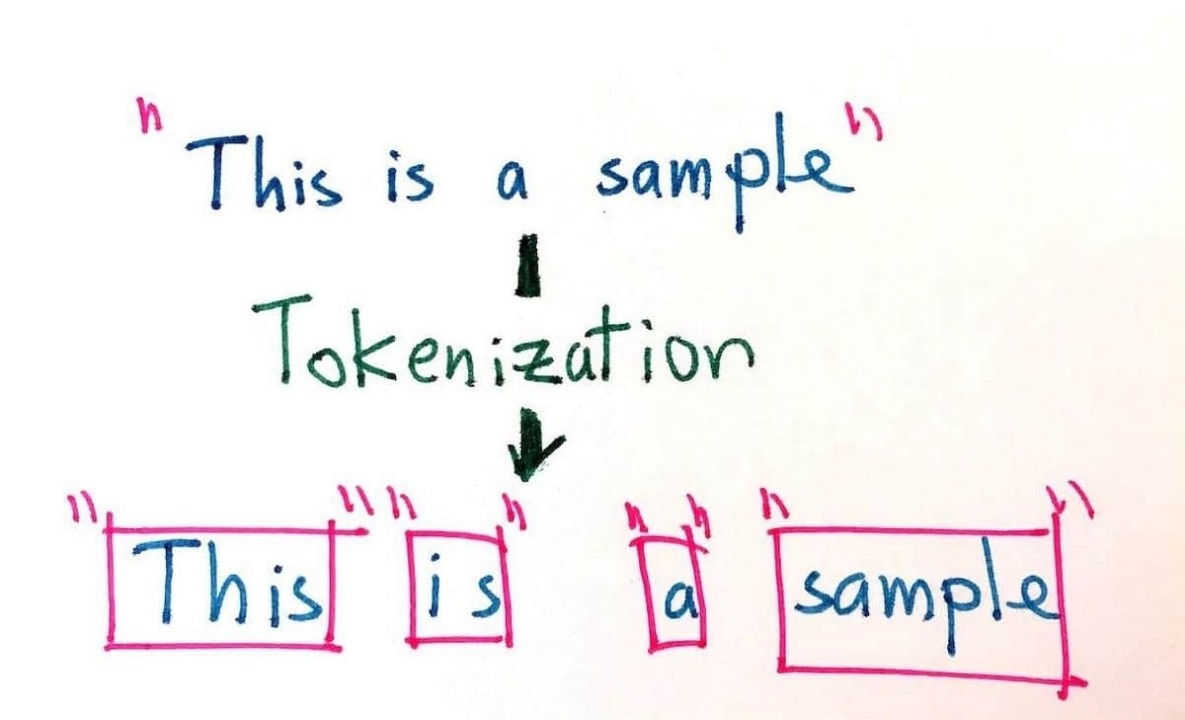

In der Welt der künstlichen Intelligenz (KI) sind Token einer der grundlegendsten Bausteine für die Sprachverarbeitung von Computern. Man kann sich Token als Legosteine vorstellen, die KI-Modellen helfen, wertvolle Sätze, Ideen und Interaktionen zu konstruieren.

Ob Wort, Satzzeichen oder sogar ein Audio-Schnipsel bei der Spracherkennung: Token sind die winzigen Bausteine, die es der KI ermöglichen, Inhalte zu verstehen und zu erstellen. Mit anderen Worten: Sie sind das Team hinter den Kulissen, das alles von der Textgenerierung bis zur Stimmungsanalyse ermöglicht.

Die Magie der Tokenisierung liegt in ihrer Flexibilität. Bei einfachen Aufgaben können große Sprachmodelle (LLMs) jedes Wort als eigenes Token behandeln. Wird es jedoch komplizierter, beispielsweise bei ungewöhnlichen oder neuen Wörtern, können LLMs diese in kleinere Teile (Unterwörter) zerlegen. So funktioniert die KI auch bei unbekannten Begriffen reibungslos.

|

Token sind einer der grundlegendsten Bausteine für die Fähigkeit von Computern, Sprache zu verarbeiten. Foto: CCN. |

Moderne Modelle wie GPT-4 arbeiten mit riesigen Vokabularen von etwa 50.000 Token. Jeder Eingabetext muss vor der Verarbeitung einen lexikalischen Segmentierungsprozess durchlaufen.

Dieser Schritt ist wichtig, da er dem KI-Modell hilft, die Art und Weise zu standardisieren, wie es Text interpretiert und generiert, sodass alles so reibungslos wie möglich abläuft. Durch die Aufteilung der Sprache in kleinere Teile gibt die Tokenisierung der KI alles, was sie braucht, um linguistische Aufgaben mit hoher Genauigkeit und Geschwindigkeit zu bewältigen.

Ohne diesen Prozess könnte moderne KI ihr volles Potenzial nicht entfalten. Da sich KI-Tools ständig weiterentwickeln, wächst die Anzahl der für die Ausgabe oder Inferenz generierten Token schneller als erwartet.

„Langfristig ist ein explosives Token-Wachstum das, was wirklich zählt“, sagten Analysten von Morgan Stanley.

Warum sind Token wichtig?

Im Gespräch mit hochrangigen Branchenvertretern sieht NVIDIA-CEO Jensen Huang den Anstieg des Tokens als Zeichen dafür, dass KI-Tools einen Mehrwert bieten.

„Unternehmen beginnen darüber zu sprechen, wie viele Token sie im letzten Quartal und im letzten Monat erstellt haben. Schon bald werden wir darüber sprechen, wie viele Token pro Stunde erstellt werden, genau wie in jeder Fabrik“, sagte Huang auf der Computex 2025, einem der weltweit größten Technologie-Events, insbesondere im Bereich Computer und Peripheriegeräte.

Tokens unterstützen KI-Systeme bei der Analyse und dem Verständnis von Sprache und ermöglichen so alles von der Textgenerierung bis zur Sentimentanalyse. Google Translate ist ein Paradebeispiel für die Bedeutung dieser Einheit.

Wenn KI Text von einer Sprache in eine andere übersetzt, zerlegt das System ihn zunächst in Token. Diese Token helfen der KI, die Bedeutung jedes Wortes oder jeder Phrase zu verstehen und stellen so sicher, dass die Übersetzung nicht nur wörtlich, sondern auch kontextuell korrekt ist.

|

Ob Wort, Satzzeichen oder sogar ein Audio-Schnipsel bei der Spracherkennung: Token sind die winzigen Bausteine, die es der KI ermöglichen, Inhalte zu verstehen und zu erstellen. Foto: Tony Grayson. |

Darüber hinaus helfen Token der KI auch sehr effektiv dabei, die Stimmung von Texten zu verstehen. Mithilfe der Sentimentanalyse untersucht KI, wie Text die Emotionen des Benutzers beeinflusst – sei es eine positive Produktbewertung, negatives Feedback oder ein neutraler Kommentar.

Durch die Aufteilung von Text in Token kann KI feststellen, ob ein Textstück einen positiven, negativen oder neutralen Ton hat. Dies ist besonders im Marketing oder Kundenservice nützlich, da das Verständnis der Nutzermeinungen zu einem Produkt oder einer Dienstleistung zukünftige Strategien beeinflussen kann.

Darüber hinaus ermöglichen Token der KI, subtile emotionale Hinweise in der Sprache zu erfassen, sodass Unternehmen auf der Grundlage von Feedback oder neuen Trends schnell reagieren können.

Da KI-Systeme immer leistungsfähiger werden, müssen auch die Tokenisierungstechniken weiterentwickelt werden, um den wachsenden Anforderungen an Effizienz, Genauigkeit und Flexibilität gerecht zu werden.

Ein Schwerpunkt liegt auf der Geschwindigkeit. Zukünftige Tokenisierungsmethoden sollten daher darauf abzielen, Token schneller zu verarbeiten, damit KI-Modelle in Echtzeit reagieren und gleichzeitig größere Datensätze verwalten können.

Noch wichtiger ist, dass das System in Zukunft nicht nur auf Text beschränkt ist. Die Anwendung multimodaler Tokenisierung wird KI durch die Integration verschiedener Datentypen wie Bilder, Videos und Audiodaten skalierbar machen.

Stellen Sie sich eine KI vor, die ein Foto nahtlos analysieren, wichtige Details extrahieren und eine Geschichte daraus erstellen kann. Dafür benötigt das System einen verbesserten Tokenisierungsprozess. Diese Innovation könnte Bereiche wie Bildung , Gesundheitswesen und Unterhaltung durch umfassendere Erkenntnisse revolutionieren.

Quelle: https://znews.vn/khong-phai-tien-day-moi-la-chi-so-quan-trong-nhat-voi-nvidia-post1557810.html

Kommentar (0)