Μιλώντας με τον Τύπο στο σεμινάριο «Επιστήμη για τη Ζωή», ο καθηγητής Toby Walsh σχολίασε ότι η απάτη με την τεχνητή νοημοσύνη αποτελεί μεγάλη πρόκληση σε πολλές χώρες, συμπεριλαμβανομένου του Βιετνάμ.

Σύμφωνα με τον καθηγητή Toby Walsh, ο απλούστερος τρόπος για να προστατευτείτε είναι να επαληθεύσετε την πηγή των πληροφοριών. Συνιστά, όταν λαμβάνετε μια κλήση, email ή μήνυμα κειμένου που ισχυρίζεται ότι προέρχεται από τράπεζα ή χρηματοπιστωτικό ίδρυμα, οι χρήστες να το ελέγχουν καλώντας απευθείας στην τηλεφωνική γραμμή, αποφεύγοντας να απαντούν σε οδηγίες από αγνώστους.

Είπε ότι ακόμη και οι βιντεοκλήσεις , τα email ή οι αριθμοί τηλεφώνου μπορούν να πλαστογραφηθούν με ολοένα και πιο εξελιγμένα εργαλεία τεχνητής νοημοσύνης. Για την οικογένειά του, εφαρμόζει μια «μυστική ερώτηση» που γνωρίζουν μόνο τα μέλη της οικογένειας για να επαληθεύσει την ταυτότητά του και να αποφύγει την εκμετάλλευση. Αυτή είναι μια μέθοδος που, σύμφωνα με τον ίδιο, κάθε βιετναμέζικη οικογένεια μπορεί επίσης να εφαρμόσει για να αυξήσει την προστασία των πληροφοριών.

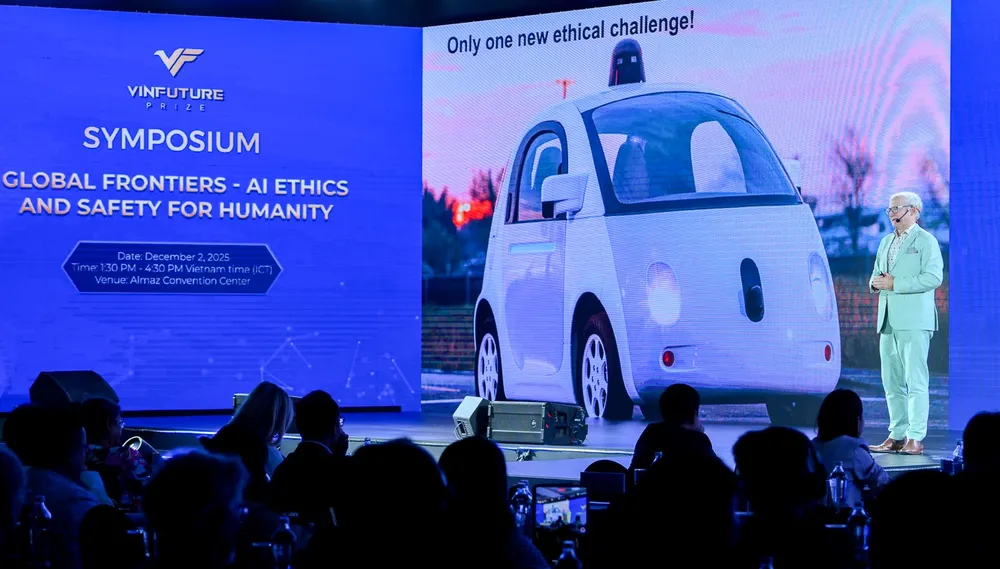

Συζητώντας ευρύτερα την ανάπτυξη της υπεύθυνης Τεχνητής Νοημοσύνης, ο καθηγητής Toby Walsh τόνισε ότι η ρύθμιση πρέπει να είναι υποχρεωτική. Με τόσα πολλά κέρδη από την Τεχνητή Νοημοσύνη, είπε ότι «μόνο ένα αυστηρό νομικό πλαίσιο μπορεί να διασφαλίσει την ορθή συμπεριφορά και να εξισορροπήσει το δημόσιο συμφέρον με τα εμπορικά συμφέροντα».

Απαντώντας σε ερώτηση σχετικά με την ευθύνη όταν η Τεχνητή Νοημοσύνη κάνει λάθη, επιβεβαίωσε: «Η Τεχνητή Νοημοσύνη δεν είναι άνθρωπος, δεν μπορεί να θεωρηθεί υπεύθυνη. Οι εταιρείες που αναπτύσσουν και λειτουργούν συστήματα Τεχνητής Νοημοσύνης πρέπει να είναι υπεύθυνες για τις συνέπειες». Αυτό είναι επίσης το σημείο που, σύμφωνα με τον ίδιο, οι εθνικοί νόμοι δεν έχουν καλύψει.

Καθώς το Βιετνάμ συντάσσει τον νόμο για την τεχνητή νοημοσύνη, ο καθηγητής Toby Walsh, ο οποίος έχει πολυετή εμπειρία στην έρευνα της τεχνητής νοημοσύνης, σημείωσε ότι δεν χρειάζονται πάντα νέοι νόμοι, επειδή πολλοί κανονισμοί για την ιδιωτικότητα ή τον ανταγωνισμό μπορούν ήδη να εφαρμοστούν στο ψηφιακό περιβάλλον. Ωστόσο, αναδύονται ορισμένοι νέοι κίνδυνοι, όπως το να βλέπουν οι χρήστες την τεχνητή νοημοσύνη ως «θεραπευτές», κάτι που οδηγεί σε ψυχολογική βλάβη. Σύμφωνα με τον ίδιο, οι εταιρείες τεχνητής νοημοσύνης πρέπει επίσης να είναι υπεύθυνες όταν τα προϊόντα τους προκαλούν βλάβη.

Ο καθηγητής Toby Walsh ανέφερε συγκεκριμένα τον κίνδυνο αρνητικής επίδρασης των παιδιών από την Τεχνητή Νοημοσύνη, όπως και τα μέσα κοινωνικής δικτύωσης. Ανέφερε ως παράδειγμα το επερχόμενο όριο ηλικίας στην Αυστραλία για τη χρήση των μέσων κοινωνικής δικτύωσης και πρότεινε ότι οι χώρες θα πρέπει να έχουν παρόμοια προστασία για την Τεχνητή Νοημοσύνη.

Όσον αφορά τα δεδομένα, το «καύσιμο» της Τεχνητής Νοημοσύνης, προειδοποίησε ότι η υπερβολική χαλαρότητα θα ήταν επιβλαβής. Η χρήση του έργου ενός συγγραφέα για την εκπαίδευση της Τεχνητής Νοημοσύνης χωρίς άδεια αποτελεί «κλοπή» και, χωρίς μια λύση όπως το μοντέλο ροής μουσικής , οι συγγραφείς θα χάσουν το κίνητρο για δημιουργία. Ο καθηγητής Τόμπι Γουόλς σημείωσε ότι το Βιετνάμ πρέπει να λάβει δραστικά μέτρα για να προστατεύσει τον πολιτισμό, τη γλώσσα και τα συμφέροντά του στην εποχή της Τεχνητής Νοημοσύνης.

Πηγή: https://www.sggp.org.vn/vien-si-cua-hiep-hoi-may-tinh-hoa-ky-chia-se-bi-kip-tranh-lua-dao-su-dung-ai-post826821.html

![[Φωτογραφία] Κατ Μπα - Πράσινος παράδεισος νησιού](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[VIMC 40 ημέρες αστραπιαίας ταχύτητας] Λιμάνι Ντα Νανγκ: Ενότητα - Αστραπιαία ταχύτητα - Επανάσταση προς τη γραμμή τερματισμού](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764833540882_cdn_4-12-25.jpeg)

Σχόλιο (0)