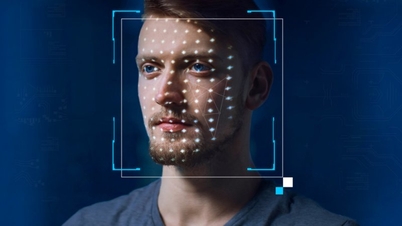

La red social X ha tenido que bloquear las búsquedas de Taylor Swift tras la viralización de imágenes pornográficas deepfake de la cantante. Al buscar a Taylor Swift en la plataforma X, los usuarios verán un mensaje de error y solicitarán que se recargue la página. Joe Benarroch, director de Operaciones Comerciales de X, afirmó que se trata de una medida preliminar y se está llevando a cabo con cautela.

Imágenes pornográficas de Taylor Swift generadas por IA comenzaron a circular en X el 24 de enero, lo que incitó a los fans de la cantante a publicar una serie de fotos reales de la estrella para "destruir" el deepfake. También pidieron a X que tomara medidas más contundentes para eliminar estas fotos y denunciar las cuentas que compartían fotos falsas. El lema "Protege a Taylor Swift" también se convirtió en tendencia en la plataforma.

Un día después, las cuentas denunciadas fueron suspendidas o restringidas, pero todavía era fácil encontrar pornografía de IA en X.

En un comunicado emitido el fin de semana, X afirmó que prohíbe compartir imágenes explícitas sin el permiso del sujeto y que mantiene una política de tolerancia cero para dicho contenido. El comunicado no mencionó a Swift por su nombre.

Nuestro equipo está eliminando activamente todas las imágenes identificadas y tomando las medidas pertinentes contra las cuentas que las publicaron. Seguiremos de cerca la situación para asegurarnos de que cualquier otra infracción se solucione de inmediato y se elimine el contenido, declaró X.

Los avances en IA generativa han facilitado la falsificación de imágenes pornográficas de otras personas. Con X, tras quedar bajo el control de Elon Musk en 2022, se han relajado muchas regulaciones de censura, al tiempo que este ha despedido a miles de empleados para estabilizar sus finanzas.

Según NBC News, se desconoce el origen de las imágenes deepfake de Taylor Swift, pero se les colocó una marca de agua para indicar que provenían de un sitio web conocido por distribuir imágenes pornográficas falsas de celebridades. El sitio web también cuenta con una sección dedicada a deepfakes de IA. Las fotos falsas de Swift fueron vistas más de 27 millones de veces y recibieron más de 260.000 "me gusta" tras 19 horas de publicación.

Tras el incidente, el director ejecutivo de Microsoft, Satya Nadella, exigió que se implementaran más medidas de seguridad para regular la IA. En una entrevista con NBC News, argumentó que tenemos la responsabilidad de monitorear esta tecnología emergente para que se pueda producir contenido más seguro.

En respuesta a una pregunta sobre el deepfake de Swift, el director de Microsoft afirmó: «Sí, debemos actuar. Creo que todos nos beneficiamos de un mundo en línea seguro. No creo que nadie quiera un mundo en línea completamente inseguro, tanto para los creadores como para los consumidores de contenido. Por eso, creo que debemos actuar con rapidez en este asunto».

Según 404 Media, un grupo de Telegram afirmó haber utilizado la herramienta Designer de Microsoft, generada con inteligencia artificial, para falsificar la foto de Taylor. El Sr. Nadella no comentó directamente sobre la información de 404 Media, pero en un comunicado enviado al sitio de noticias, Microsoft indicó que estaba investigando el informe y que tomaría las medidas pertinentes.

La administración del presidente estadounidense Joe Biden calificó de "alarmante" la difusión del deepfake pornográfico de Taylor Swift y pidió a las empresas de redes sociales que examinen su "papel vital" en la aplicación de las regulaciones para prevenir la difusión de información falsa e imágenes sensibles sin consentimiento.

En octubre de 2023, el presidente Biden firmó una orden ejecutiva sobre IA centrada en regular la tecnología emergente y sus riesgos.

(Según The Hill y WSJ)

[anuncio_2]

Fuente

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, mantiene conversaciones con el presidente de la Asamblea Nacional húngara, Kover Laszlo.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760952711347_ndo_br_bnd-1603-jpg.webp)

![[Foto] El Primer Ministro Pham Minh Chinh recibió al Sr. Yamamoto Ichita, Gobernador de la Provincia de Gunma (Japón).](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/21/1761032833411_dsc-8867-jpg.webp)

![[Foto] El primer ministro Pham Minh Chinh se reúne con el presidente de la Asamblea Nacional húngara, Kover Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

Kommentar (0)