Esta imagen de un astronauta a caballo se creó utilizando dos tipos de modelos de IA generativa. Foto: MIT News

Cuando la velocidad y la calidad ya no son un compromiso

En el campo de la obtención de imágenes mediante IA, actualmente existen dos enfoques principales:

Los modelos de difusión permiten obtener imágenes nítidas y detalladas. Sin embargo, son lentos y computacionalmente costosos, ya que requieren decenas de pasos de procesamiento para eliminar el ruido de cada píxel.

Los modelos autorregresivos son mucho más rápidos porque predicen pequeñas partes de una imagen secuencialmente. Sin embargo, suelen producir imágenes con menos detalle y son propensos a errores.

HART (transformador autorregresivo híbrido) combina ambos, ofreciendo lo mejor de ambos mundos. Primero, utiliza un modelo autorregresivo para construir la imagen general codificándola en tokens discretos. A continuación, un modelo de difusión ligero se encarga de completar los tokens residuales: la información detallada perdida durante la codificación.

Las imágenes resultantes son de una calidad comparable (o mejor) a la de los modelos de difusión de última generación, pero son 9 veces más rápidas de procesar y utilizan un 31% menos de recursos computacionales.

Nuevo enfoque para crear imágenes de calidad a alta velocidad

Una de las innovaciones notables de HART es cómo resuelve el problema de la pérdida de información al usar modelos autorregresivos. Convertir imágenes en tokens discretos acelera el proceso, pero también pierde detalles importantes como los bordes de los objetos, los rasgos faciales, el cabello, los ojos, la boca, etc.

La solución de HART consiste en que el modelo de difusión se centre únicamente en corregir estos detalles mediante tokens residuales. Y dado que el modelo autorregresivo ya ha realizado la mayor parte del trabajo, el modelo de difusión solo necesita 8 pasos de procesamiento en lugar de los más de 30 pasos anteriores.

"El modelo de difusión es más fácil de implementar, lo que conduce a una mayor eficiencia", explica el coautor Haotian Tang.

En concreto, la combinación de un modelo de transformador autorregresivo con 700 millones de parámetros y un modelo de difusión ligero con 37 millones de parámetros proporciona a HART el mismo rendimiento que un modelo de difusión con hasta 2 mil millones de parámetros, pero 9 veces más rápido.

Inicialmente, el equipo también intentó integrar el modelo de difusión en las primeras etapas del proceso de generación de imágenes, pero esto generó errores. El enfoque más eficaz fue dejar que el modelo de difusión se encargara del paso final y centrarse únicamente en las partes faltantes de la imagen.

Abriendo el futuro de la IA multimedia

El siguiente paso del equipo es construir modelos de IA visual-lingüística de última generación basados en la arquitectura HART. Dado que HART es escalable y adaptable a una amplia gama de tipos de datos (multimodal), esperan poder aplicarlo a la generación de video , la predicción de audio y muchas otras áreas.

Esta investigación fue financiada por varias organizaciones, entre ellas el Laboratorio de IA Watson del MIT-IBM, el Centro de Ciencias del MIT-Amazon, el Programa de Hardware de IA del MIT y la Fundación Nacional de Ciencias de EE. UU. NVIDIA también donó infraestructura de GPU para entrenar el modelo.

(Según MIT News)

Fuente: https://vietnamnet.vn/cong-cu-ai-moi-tao-anh-chat-luong-cao-nhanh-gap-9-lan-2384719.html

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, asiste a la ceremonia de entrega de premios VinFuture 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

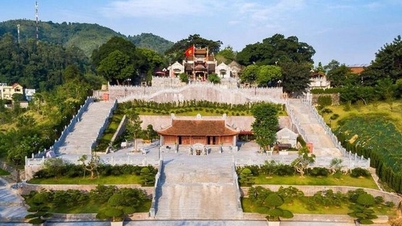

![[Foto] 60º aniversario de la fundación de la Asociación de Artistas Fotográficos de Vietnam](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

Kommentar (0)