Los investigadores de DeepSeek han anunciado un nuevo modelo experimental llamado V3.2-exp, diseñado para reducir significativamente el coste de la inferencia cuando se utiliza en operaciones de contexto largo.

DeepSeek anunció el modelo en una publicación en Hugging Face, y también publicó un artículo académico vinculado en GitHub.

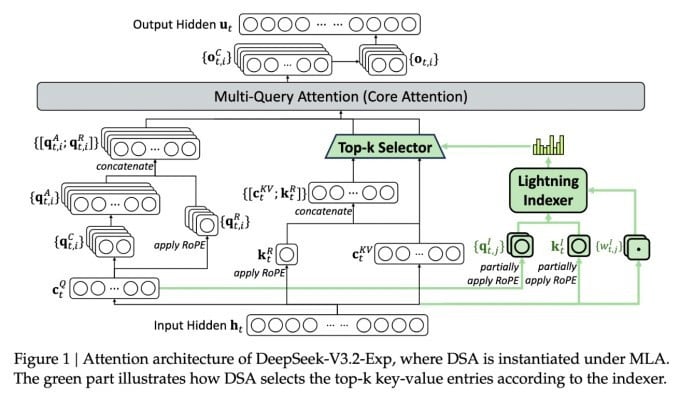

La característica más importante del nuevo y complejo modelo se denomina DeepSeek Sparse Attention. Básicamente, el sistema utiliza un módulo llamado "indexador relámpago" para priorizar fragmentos específicos de la ventana de contexto.

DeepSeek anuncia un modelo de inferencia rentable.

Un sistema independiente, denominado «sistema de selección de tokens de grano fino», selecciona tokens específicos de esos fragmentos para cargarlos en la ventana de atención limitada del módulo. En conjunto, permiten que los modelos de Atención Esparsa operen con contextos extensos con una carga de servidor relativamente baja.

Para operaciones de contexto extenso, las ventajas del sistema son significativas. Las pruebas preliminares de DeepSeek demuestran que el coste de una llamada a una función de inferencia simple (API) puede reducirse hasta la mitad en escenarios de contexto extenso.

Se necesitan más pruebas para elaborar una evaluación más sólida, pero dado que el modelo es abierto y está disponible gratuitamente en Hugging Face, no debería pasar mucho tiempo antes de que pruebas de terceros puedan evaluar las afirmaciones del artículo.

A diferencia de otros modelos de chatbots de IA que consumen mucha energía, DeepSeek se orienta hacia el ahorro de costes, desde el entrenamiento hasta el funcionamiento.

El nuevo modelo de DeepSeek es uno de una serie de avances recientes que abordan el problema del coste de inferencia; esencialmente, el coste del servidor para ejecutar un modelo de IA preentrenado, en contraposición al coste de entrenarlo.

En el caso de DeepSeek, los investigadores buscaban formas de hacer más eficiente la arquitectura básica del transformador y descubrieron que era necesario realizar mejoras significativas.

Con sede en China, DeepSeek es una figura atípica en el auge de la IA, sobre todo para quienes ven la investigación en IA como una competencia entre Estados Unidos y China. La empresa causó sensación a principios de este año con su modelo R1, entrenado principalmente mediante aprendizaje por refuerzo a un coste mucho menor que el de sus competidores estadounidenses.

Sin embargo, el modelo no logró desencadenar la revolución a gran escala en el entrenamiento de IA que algunos predijeron, y la empresa se fue retirando lentamente del foco mediático en los meses siguientes.

Es poco probable que el nuevo enfoque de “atención dispersa” cause tanta indignación como R1, pero aún así podría enseñar a los proveedores de servicios estadounidenses algunos trucos muy necesarios para ayudar a mantener bajos los costos de inferencia.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Fuente: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Foto] El secretario general To Lam recibe al presidente del Senado de la República Checa, Milos Vystrcil.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763723946294_ndo_br_1-8401-jpg.webp&w=3840&q=75)

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, conversa con el presidente del Senado de la República Checa, Milos Vystrcil.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763715853195_ndo_br_bnd-6440-jpg.webp&w=3840&q=75)

![[Foto] Visita Hung Yen para admirar la pagoda, una "obra maestra de madera", en el corazón del Delta del Norte.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763716446000_a1-bnd-8471-1769-jpg.webp&w=3840&q=75)

![[Foto] El presidente Luong Cuong recibe al presidente de la Asamblea Nacional de Corea, Woo Won Shik](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F21%2F1763720046458_ndo_br_1-jpg.webp&w=3840&q=75)

Kommentar (0)