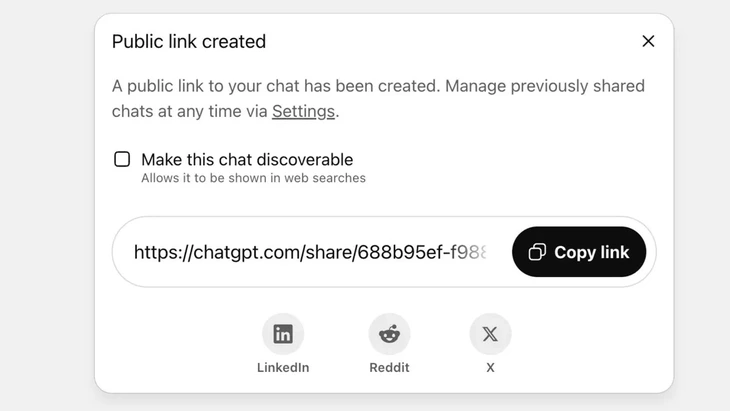

Función para compartir chats mediante enlace público en ChatGPT - Foto: Techradar

ChatGPT recibe actualmente más de 2.500 millones de consultas diarias de usuarios globales, lo que demuestra la creciente popularidad de este chatbot.

Sin embargo, esta herramienta está recibiendo fuertes críticas por parte de los usuarios, ya que la función de "compartir" ha provocado que miles de conversaciones filtren información confidencial a Google y a algunos motores de búsqueda en Internet.

Alto riesgo para la seguridad

El Sr. Vu Ngoc Son, jefe del departamento de tecnología de la Asociación Nacional de Ciberseguridad (NCA), evaluó que el incidente mencionado anteriormente muestra un alto nivel de riesgo de seguridad para los usuarios de ChatGPT.

“El incidente anterior no se debe necesariamente a un fallo técnico, ya que existe cierta iniciativa por parte del usuario al hacer clic en el botón de compartir. Sin embargo, se puede afirmar que el problema reside en el diseño del chatbot de IA, que ha confundido a los usuarios y no cuenta con medidas de advertencia suficientemente sólidas sobre el riesgo de filtración de datos personales al compartir contenido”, analizó el Sr. Vu Ngoc Son.

En ChatGPT, esta función se implementa después de que el usuario elige compartir el chat a través de un enlace público; el contenido se almacenará en el servidor de OpenAI como un sitio web público (chatgpt.com/share/...), sin necesidad de iniciar sesión ni contraseña para acceder.

Los rastreadores de Google escanean e indexan automáticamente estas páginas, haciendo que aparezcan en los resultados de búsqueda, incluyendo texto confidencial, imágenes o datos de chat.

Muchos usuarios desconocían el riesgo, creyendo que simplemente compartían el chat con amigos o contactos. Esto provocó la exposición de miles de conversaciones, algunas de las cuales contenían información personal sensible.

Aunque OpenAI eliminó rápidamente esta función a finales de julio de 2025 tras las críticas de la comunidad, aún requirió tiempo coordinar con Google la eliminación de los índices antiguos. Esto se debe, en particular, a la complejidad del sistema de almacenamiento, que incluye los servidores caché de Google, lo que dificulta su ejecución.

No trates a los chatbots de IA como una "caja negra de seguridad".

Vu Ngoc Son, experto en seguridad de datos y jefe de tecnología de la Asociación Nacional de Ciberseguridad (NCA). Foto: CHI HIEU

La filtración de miles de registros de chat puede suponer riesgos para los usuarios, como la revelación de secretos personales y comerciales; daños a la reputación, riesgos financieros o incluso peligros para la seguridad debido a la revelación de direcciones particulares.

“Los chatbots con inteligencia artificial son útiles, pero no una ‘caja negra’, ya que los datos compartidos pueden permanecer indefinidamente en la web si no se controlan.”

El incidente anterior constituye sin duda una lección tanto para proveedores como para usuarios. Otros proveedores de servicios de IA pueden aprender de esta experiencia y diseñar funciones con advertencias más claras y transparentes.

Al mismo tiempo, los usuarios también deben limitar de forma proactiva la publicación incontrolada de información personal o de identificación en plataformas de IA”, recomendó el experto en seguridad Vu Ngoc Son.

Según expertos en seguridad de datos, el incidente mencionado demuestra la necesidad de establecer marcos legales y estándares de ciberseguridad para la IA. Los proveedores y desarrolladores de IA también deben diseñar sistemas que garanticen la seguridad, evitando riesgos de fuga de datos como: fugas por vulnerabilidades; vulnerabilidades de software que permiten ataques a bases de datos; y controles deficientes que pueden provocar envenenamiento o abuso de datos para responder preguntas falsas o distorsionadas.

Los usuarios también deben controlar el intercambio de información personal con la IA, evitando compartir información sensible. En caso de ser estrictamente necesario, se recomienda usar el modo anónimo o cifrar activamente la información para evitar que los datos se vinculen directamente con personas específicas.

Fuente: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Foto] "Cementerio de barcos" en la bahía de Xuan Dai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Vídeo] Los monumentos de Hue reabren para recibir visitantes](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Kommentar (0)