Los gigantes tecnológicos han gastado miles de millones de dólares creyendo que “más es mejor” en inteligencia artificial (IA).

Sin embargo, el avance de DeepSeek demuestra que modelos más pequeños pueden lograr un rendimiento similar a un coste mucho menor.

A fines de enero, DeepSeek anunció que el costo final del entrenamiento del modelo R1 fue de solo 5,6 millones de dólares , una fracción de lo que cobran las empresas estadounidenses.

“Piratas de la tecnología”

El salto de DeepSeek a las filas de los principales fabricantes de IA también ha provocado acalorados debates en Silicon Valley sobre un proceso llamado “destilación”.

Se trata de una técnica que se refiere al aprendizaje del nuevo sistema a partir del sistema existente formulando cientos de miles de preguntas y analizando las respuestas.

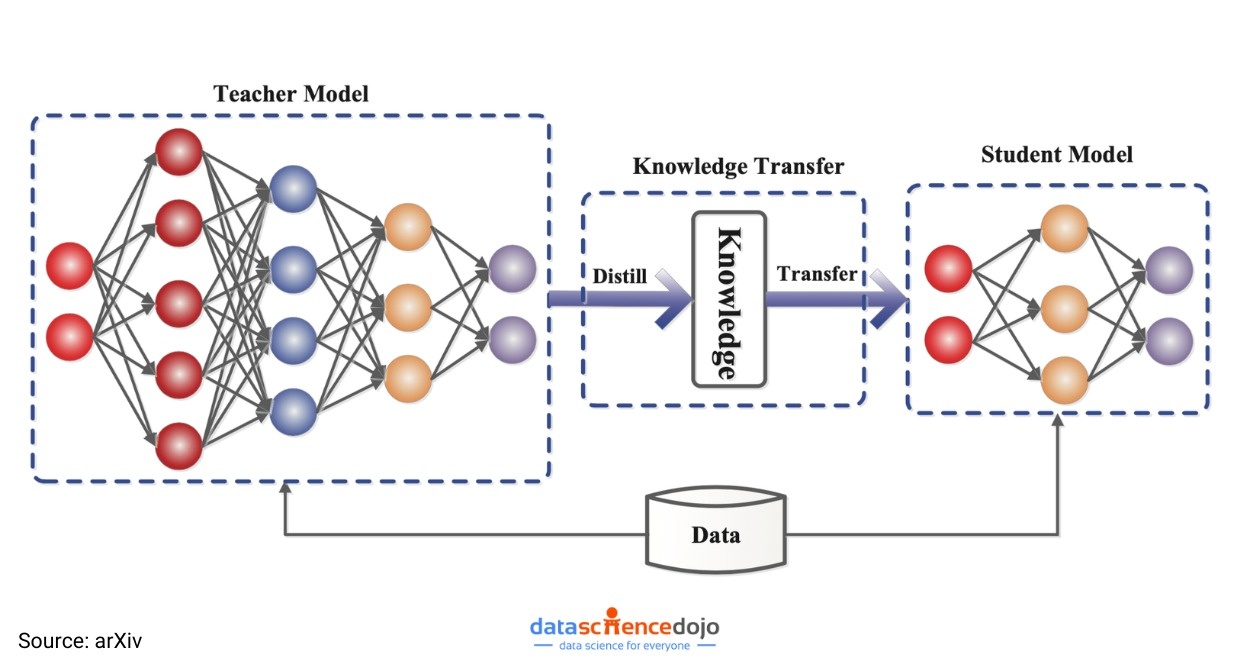

A través de la destilación, las empresas tomarán un modelo de lenguaje grande (LLM), llamado modelo “maestro”, que es capaz de predecir la siguiente palabra que tiene más probabilidades de aparecer en una oración.

El modelo del profesor genera datos que luego se utilizan para entrenar un modelo de estudiante más pequeño. Este proceso permite una rápida transferencia de conocimientos y capacidades predictivas del modelo más grande al modelo más pequeño.

|

En lugar de invertir miles de millones de dólares en entrenar un modelo, la técnica de "destilación" permite a DeepSeek lograr los mismos resultados simplemente aprendiendo de un modelo existente de gran tamaño. Foto: Mint. |

Si bien la destilación se ha utilizado ampliamente durante años, los avances recientes han llevado a los expertos de la industria a creer que se convertirá cada vez más en una ventaja importante para nuevas empresas como DeepSeek.

A diferencia de gigantes de la industria como OpenAI, estas empresas siempre buscan soluciones rentables para desarrollar aplicaciones basadas en IA.

La destilación es realmente mágica. Es el proceso de tomar un modelo de borde grande e inteligente y usarlo para entrenar un modelo más pequeño. Es muy potente para tareas específicas, muy económico y rapidísimo de ejecutar, afirma Olivier Godement, líder de producto de OpenAI.

Signos de interrogación sobre la efectividad de miles de millones de dólares en capital

Los LLM como GPT-4 de OpenAI, Gemini (Google) o Llama (Meta) son conocidos por requerir enormes cantidades de datos y potencia informática para su desarrollo y mantenimiento.

Aunque las empresas no revelan los costos exactos, se estima que entrenar estos modelos podría costar cientos de millones de dólares.

Entre ellos se encuentran Google, OpenAI, Anthropic y xAI de Elon Musk. Tras la toma de posesión de Trump, OpenAI anunció una alianza con SoftBank y otros socios para invertir 500 000 millones de dólares en infraestructura de IA durante los próximos cinco años.

Sin embargo, gracias a la destilación, los desarrolladores y las empresas pueden acceder a las potentes capacidades de los modelos grandes a un costo mucho menor. Esto permite que las aplicaciones de IA se ejecuten rápidamente en dispositivos como computadoras portátiles o teléfonos inteligentes.

|

Modelo de la técnica de "destilación" en el entrenamiento de modelos de IA. Foto: arXiv. |

De hecho , el WSJ sugiere que después del éxito de DeepSeek, los ejecutivos e inversores de Silicon Valley están repensando sus modelos de negocio y cuestionando si el liderazgo en la industria todavía vale la pena.

“¿Vale la pena económicamente ser el primero si cuesta ocho veces más que ser un seguidor?”, pregunta Mike Volpi, veterano ejecutivo tecnológico y capitalista de riesgo de Hanabi Capital.

Los CIO esperan ver muchas aplicaciones de IA de alta calidad creadas utilizando la técnica de “destilación” en los próximos años.

En concreto, investigadores de la empresa de inteligencia artificial Hugging Face han comenzado a intentar construir un modelo similar al de DeepSeek. «Lo más fácil de replicar es el proceso de destilación», afirmó el investigador principal Lewis Tunstall.

Los modelos de IA de OpenAI y Google siguen liderando las listas de ampliamente utilizados en Silicon Valley.

Los gigantes tecnológicos logran mantener una ventaja en los sistemas más avanzados gracias a la investigación más original. Sin embargo, muchos consumidores y empresas están dispuestos a conformarse con tecnología ligeramente inferior a un precio mucho menor.

|

La técnica de "destilación" no es nueva, pero el éxito de DeepSeek ha demostrado que los modelos de IA de bajo coste pueden ser tan eficaces como los modelos que cuestan miles de millones de dólares. Foto: Shutterstock. |

Si bien la destilación puede producir modelos que funcionen bien, muchos expertos también advierten que tiene ciertas limitaciones.

La destilación conlleva una interesante contrapartida. Al reducir el tamaño del modelo, inevitablemente se reducen sus capacidades, explica Ahmed Awadallah, de Microsoft Research.

Según Awadallah, un modelo de destilación puede ser muy bueno para resumir correos electrónicos, pero al mismo tiempo no es bueno para ninguna otra tarea.

Mientras tanto, David Cox, vicepresidente de modelado de IA en IBM Research, dijo que la mayoría de las empresas no necesitan modelos gigantes para ejecutar sus productos.

Los modelos destilados ahora son lo suficientemente potentes como para cumplir funciones como chatbots para servicio al cliente o funcionar en dispositivos pequeños como teléfonos.

“Siempre que se puedan reducir costos y al mismo tiempo lograr el rendimiento deseado, no hay razón para no hacerlo”, añadió Cox.

Fuente: https://znews.vn/ky-thuat-chung-cat-ai-dang-dat-ra-cau-hoi-lon-post1535517.html

Kommentar (0)