Microsoft afirma que no tiene planes de comercializar los chips de IA. En su lugar, el gigante tecnológico estadounidense los utilizará para uso interno en sus productos de software, así como en su servicio de computación en la nube Azure.

|

| La autoproducción de chips es una tendencia que ayuda a las empresas tecnológicas a reducir los costosos costos de la IA. |

Los ejecutivos de Microsoft afirman que planean abordar el creciente coste de la IA mediante un modelo de plataforma común para integrarla a fondo en todo el ecosistema de software. Y el chip Maia está diseñado precisamente para eso.

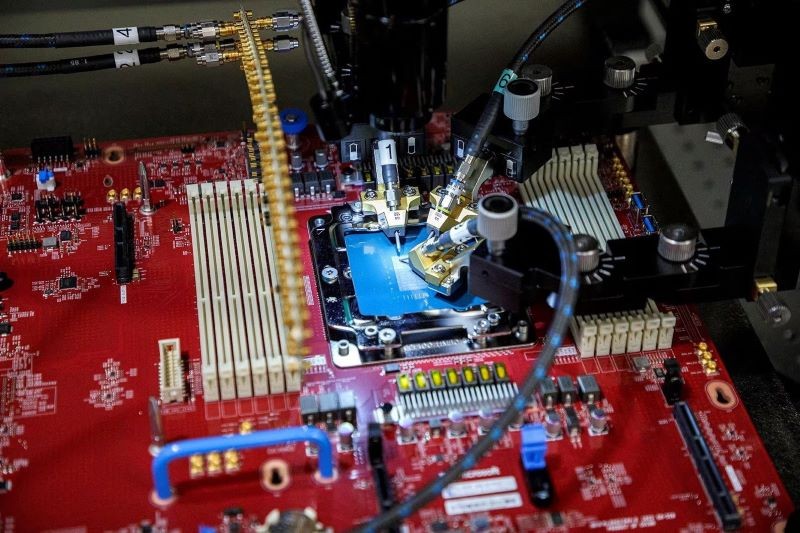

El chip Maia fue diseñado por Microsoft para ejecutar modelos de lenguaje grandes (LLM), la base del servicio Azure OpenAI, una colaboración entre Microsoft y la empresa propietaria de ChatGPT.

Microsoft también anunció que el próximo año ofrecerá a los clientes de Azure servicios en la nube con los chips líderes más recientes de Nvidia y Advanced Micro Devices (AMD). Actualmente, está probando GPT-4 en chips AMD.

Mientras tanto, el segundo chip, cuyo nombre en código es Cobalt, fue lanzado por Microsoft para ahorrar costos internos y competir con el servicio en nube AWS de Amazon, que utiliza su propio chip de diseño propio, "Graviton".

Cobalt es una unidad central de procesamiento (CPU) basada en Arm que actualmente se está probando para impulsar el software de mensajería empresarial Teams.

AWS dice que su chip Graviton actualmente tiene alrededor de 50.000 clientes y la compañía organizará una conferencia para desarrolladores a finales de este mes.

Rani Borkar, vicepresidente corporativo de hardware e infraestructura de Azure, dijo que ambos nuevos chips de IA se fabrican utilizando el proceso de 5 nm de TSMC.

El chip Maia está emparejado con cables Ethernet estándar, en lugar de utilizar la tecnología de red Nvidia personalizada más costosa que Microsoft ha utilizado en las supercomputadoras que construyó para OpenAI.

[anuncio_2]

Fuente

Kommentar (0)