از هر زاویهای حمله کنید.

گوگل محصول هوش مصنوعی (AI) جدیدی به نام «Gemini Nano Banana» عرضه کرده است که یک هوش مصنوعی زبانی (LLM) در مقیاس بزرگ با قابلیت نوشتن و استدلال نیست، بلکه یک هوش مصنوعی متخصص در ویرایش عکس است... بسیاری از کاربران از این ابزار هیجانزده هستند، اما این ابزار معایبی نیز به همراه دارد.

نگوین هونگ فوک، مدیر ارشد علمی Conductify AI، با ابراز نظر شخصی خود گفت: «این مانند یک «گام به عقب» در فناوری هوش مصنوعی و محدودیتهای اخلاقی است.» فوک گفت: «Gemini Nano Banana قابلیتهای ویرایش تصویر موثری دارد. اما سانسور نکردن Gemini Nano Banana توسط گوگل، با از بین بردن موانع و مکانیسمهای محدودکننده، به این هوش مصنوعی اجازه میدهد تصاویری ایجاد کند که فوقالعاده شبیه به افراد مشهور، تصاویر وسوسهانگیز، تصاویر حساس و غیره هستند.»

به گفته آقای نگوین هونگ فوک، این قابلیت، جمینی نانو موز را به ابزاری برای ایجاد تصاویر جعلی واقعگرایانه تبدیل میکند، تا جایی که حتی متخصصان هوش مصنوعی نیز نمیتوانند آنها را تشخیص دهند و این امر منجر به خطرات جدید کلاهبرداری و امنیت سایبری میشود، مانند ایجاد عکسهای جعلی با سیاستمداران مشهور برای انتشار اطلاعات نادرست، و حتی قرار گرفتن افراد در معرض دستکاری عکسهای تولید شده توسط هوش مصنوعی و افترا در رسانههای اجتماعی...

علاوه بر این، با وجود دهها ابزار ویرایش عکس هوش مصنوعی دیگر که اینترنت را به تسخیر خود درآوردهاند، کلاهبرداریهای دیپفیک هیچ نشانهای از توقف نشان نمیدهند. آمار سازمانهای امنیتی نشان میدهد که فناوری دیپفیک، کمپینهای فیشینگ را ایجاد میکند که افراد باارزش، به ویژه رهبران تجاری را هدف قرار میدهند. در سال ۲۰۲۴، ۱۴۰،۰۰۰ تا ۱۵۰،۰۰۰ مورد در سطح جهان وجود داشت که ۷۵٪ آنها مدیران عامل و مدیران ارشد را هدف قرار میدادند... دیپفیک میتواند ضررهای اقتصادی جهانی را ۳۲٪ افزایش دهد، تقریباً ۴۰ میلیارد دلار در سال تا سال ۲۰۲۷.

اخیراً، شرکت هوش مصنوعی آنتروپیک، یک کمپین حمله سایبری انجام شده توسط هکرهای خارجی را شناسایی و خنثی کرد که برای اولین بار استفاده از هوش مصنوعی برای هماهنگی فعالیتهای حمله خودکار را ثبت کرد. به طور خاص، هکرها از سیستمهای هوش مصنوعی برای برنامهریزی، هدایت و استقرار عملیات نفوذ استفاده کردند - یک تحول «نگرانکننده» که خطر گسترش مقیاس و سرعت کمپینهای حمله سایبری را به همراه دارد...

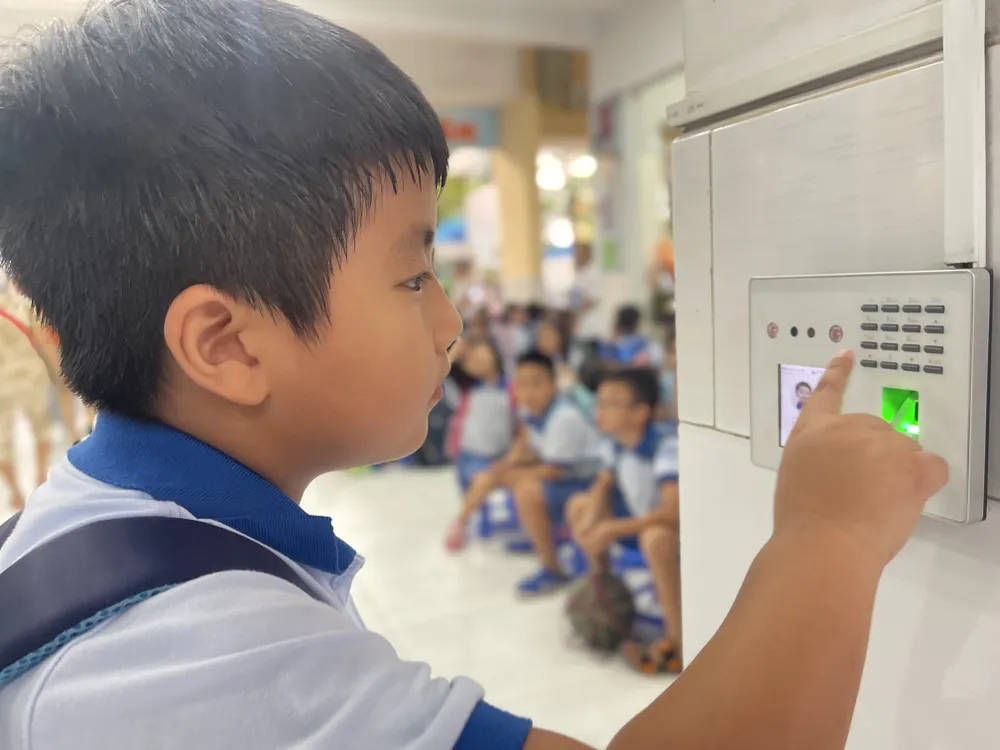

آقای نگو مین هیو، مدیر سازمان مبارزه با کلاهبرداری انجمن ملی امنیت سایبری، اظهار داشت که ابزارهای یکپارچه با هوش مصنوعی، سرعت کلاهبرداری را در مقایسه با استفاده از افراد واقعی حدود ۲۰ برابر افزایش میدهند. کلاهبرداران سناریوی کلاهبرداری را برای تجزیه و تحلیل در اختیار هوش مصنوعی قرار میدهند و سیستم بلافاصله به طور خودکار با قربانیان چت میکند. هوش مصنوعی میتواند از دادههای اولیه، خواستههای قربانی را درک کند و در زمان واقعی با آنها ارتباط برقرار کند. پیچیدهترین تاکتیک، حمله "مرد میانی" است که در آن وقتی کاربر احراز هویت ویدیویی (مانند ضبط چهره یا دادن دستورات) را انجام میدهد، هکر مداخله میکند تا در دادههای منتقل شده اختلال ایجاد کند. سپس مجرمان سایبری ویدیوهای دیپفیک از پیش آماده شده را وارد میکنند و جریان دادههای واقعی کاربر را جایگزین میکنند تا فرآیند احراز هویت را دور بزنند. با این روش، سیستمهای امنیتی بانکها و موسسات مالی نیز در معرض خطر فریب خوردن قرار میگیرند.

مدیریت بهتر دادهها

با رواج روزافزون هوش مصنوعی، خطرات امنیتی و حریم خصوصی نیز به طور قابل توجهی افزایش مییابد. دادههای ذخیره شده و پردازش شده روی سرورهای از راه دور به هدفی جذاب برای هکرها و مجرمان سایبری تبدیل خواهند شد. طبق دادههای انجمن ملی امنیت سایبری، تنها در سه ماهه دوم سال 2025، تعداد حملات سایبری مبتنی بر هوش مصنوعی 62 درصد افزایش یافته و باعث خسارات جهانی تا 18 میلیارد دلار شده است...

کارشناسان معتقدند حفاظت از دادهها بسیار مهم است. با این حال، جمعآوری و فروش دادهها به صورت آشکار در بسیاری از پلتفرمهای "بازار سیاه" با قیمتی در حدود 20 دلار در ماه ادامه دارد. مجرمان سایبری میتوانند از ابزارهایی استفاده کنند که مدلهای زبانی را تقلید میکنند اما برای اهداف مجرمانه سفارشی شدهاند. این ابزارها قادر به تولید بدافزار و حتی دور زدن نرمافزارهای آنتیویروس هستند.

در ویتنام، فرمان شماره 13/2023/ND-CP (که از 17 آوریل 2023 لازمالاجرا است) حفاظت از دادههای شخصی را تنظیم میکند. علاوه بر این، قانون حفاظت از دادههای شخصی که انتظار میرود از اول ژانویه 2026 لازمالاجرا شود، سازوکار قانونی قویتری را برای مقابله با خطر نشت و سوءاستفاده از دادههای شخصی ایجاد خواهد کرد. با این حال، طبق گفته انجمن ملی امنیت سایبری، اثربخشی اجرای قانون هنوز باید در سه ستون تقویت شود: افزایش آگاهی عمومی، افزایش مسئولیت شرکتها و بهبود ظرفیت پردازش سازمانهای نظارتی. فراتر از اقدامات فنی، هر فرد باید توانایی شناسایی علائم غیرمعمول و مشکوک را در خود ایجاد کند و به طور پیشگیرانه از خود در برابر تعاملات دیجیتال خطرناک محافظت کند...

کسپرسکی در مورد سوءاستفاده از هوش مصنوعی تاریک (اصطلاحی که به استقرار مدلهای زبانی بزرگ (LLM) اشاره دارد که خارج از کنترلهای امنیتی استاندارد عمل میکنند و اغلب اقداماتی مانند فیشینگ، دستکاری، حملات سایبری یا سوءاستفاده از دادهها را امکانپذیر میکنند) هشدار داده است. سازمانها و افراد باید به دلیل ظهور هوش مصنوعی تاریک در منطقه آسیا و اقیانوسیه، برای مقابله با حملات سایبری که به طور فزایندهای پیچیده و دشوار تشخیص داده میشوند، آماده شوند.

سرگئی لوژکین، رئیس تیم تحقیق و تحلیل جهانی (GReAT) برای مناطق خاورمیانه، ترکیه، آفریقا و آسیا و اقیانوسیه در کسپرسکی، اظهار داشت که یکی از مظاهر سوءاستفاده فعلی از هوش مصنوعی، ظهور مدلهای GPT کلاه سیاه است. اینها مدلهای هوش مصنوعی هستند که بهطور خاص برای اهداف غیراخلاقی و غیرقانونی، مانند ایجاد بدافزار، ساخت ایمیلهای فیشینگ روان و متقاعدکننده برای حملات در مقیاس بزرگ، ایجاد صداها و ویدیوهای دیپفیک و حتی پشتیبانی از حملات شبیهسازی شده، توسعه یافته یا اصلاح شدهاند.

کارشناسان کسپرسکی توصیه میکنند که افراد و کسبوکارها از راهحلهای امنیتی نسل بعدی برای شناسایی بدافزارهای تولید شده توسط هوش مصنوعی استفاده کنند، ضمن اینکه حفاظت از دادهها را نیز در اولویت قرار دهند. کسبوکارها باید ابزارهای نظارتی بلادرنگ را برای ردیابی سوءاستفاده از آسیبپذیریهای مبتنی بر هوش مصنوعی پیادهسازی کنند؛ کنترل دسترسی و آموزش کارکنان را تقویت کنند تا هوش مصنوعی را در منطقه تاریک و خطر نشت دادهها محدود کنند؛ و یک مرکز عملیات امنیت سایبری برای نظارت بر تهدیدات و پاسخ سریع به حوادث ایجاد کنند.

منبع: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

![[عکس] شکوفههای گلابی سفید در مرز فو بنگ شکوفا میشوند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/24/1771927665653_a8-8280-jpg.webp)

![[تصویر] یک «شهر قابل سکونت» رویایی زیر ابرهای صورتی](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/24/1771930060937_tp4-jpg.webp)

![[عکس] رئیس اداره مرکزی تبلیغات و بسیج مردمی از وزارت بهداشت و موسسه طب سنتی نظامی بازدید و به آنها تبریک میگوید.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/24/1771938483290_img-2682-3562-jpg.webp)

نظر (0)