حوادث اخیر مربوط به سوگیری و جعل اسناد، باعث شده است که محققان در مورد سطح مناسب مشارکت هوش مصنوعی در تحقیقات تجدید نظر کنند.

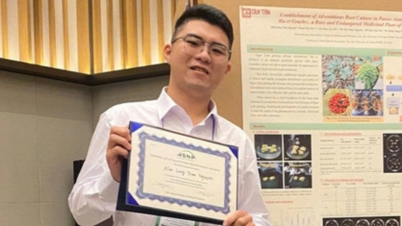

اخیراً، پروفسور نگوین ون هیپ، دکترای زبانشناسی، در صفحه شخصی خود داستانی را به اشتراک گذاشت که خوانندگان را شوکه کرد. او کشف کرد که هوش مصنوعی اسناد او را در اطلاعاتی که توسط یکی از دوستانش ارسال شده بود، جعل کرده است. او همچنین به طور تصادفی متوجه شد که مقاله دانشیار، دکترای علوم تران ون کو نیز توسط هوش مصنوعی جعل شده است.

هوش مصنوعی به بخش جداییناپذیر زندگی بشر تبدیل شده است، با این حال، کارشناسان همیشه تأکید میکنند که ما باید هوش مصنوعی را فقط به عنوان یک ابزار پشتیبانی ببینیم. کاربران هوش مصنوعی همیشه باید هوشیار و آگاه باشند تا دادهها را پردازش کرده و نتایج به دست آمده پس از "همکاری" با هوش مصنوعی را ارزیابی کنند. به ویژه در تحقیقات علمی، بسیاری از مطالعات نشان دادهاند که بزرگترین مشکلی که باید هوشیار بود، سوگیری در دادهها و مدلها است. هوش مصنوعی میتواند سوگیری داشته باشد، نتایج تحلیل را تحریف کند، تعصب یا تبعیض ایجاد کند و اگر به خوبی کنترل نشود، اطلاعات را دستکاری کند.

به طور خاص، استفاده از هوش مصنوعی در تحقیقات علوم اجتماعی نیاز به احتیاط بسیار بیشتری دارد. از آنجا که حوزههای علوم اجتماعی مانند فلسفه، زبانشناسی، قومشناسی، تاریخ و غیره همگی رفتار، فرهنگ و سلوک انسانی را به عنوان موضوعات تحقیقاتی در نظر میگیرند، دادهها اغلب با عمق و دقت به بافت اجتماعی-فرهنگی ویتنام گره خوردهاند. اگر دادههای آموزشی هوش مصنوعی منعکسکننده تعصبات تاریخی باشند، خطری که میتواند رخ دهد این است که هوش مصنوعی میتواند نتیجهگیریهایی کند که مشکلات نابرابری بین جنسیت، طبقه، نژاد یا منطقه جغرافیایی را تشدید کند. این خطر زمانی که از هوش مصنوعی برای تحلیل رفتار انسان، پاسخ به نظرسنجیهای آزاد یا مشارکت در محتوای رسانهای استفاده شود، حتی بیشتر است.

به گفته برخی از کارشناسان علوم اجتماعی، هوش مصنوعی در حال حاضر در دسترسی به منابع داده دارای حق چاپ یا پرداخت شده مشکل دارد و در نتیجه اطلاعات به طور ناقص بهروزرسانی میشوند.

پدیده جعل اسناد برای ایجاد داستانهای باورپذیر اغلب در موضوعات کمطرفدارتر، در زبانهایی با منابع داده محدود مانند ویتنامی، رخ میدهد و باید به کاربران هشدار داده شود. سیستمهای هوش مصنوعی به طور کلی در حال حاضر در درک زمینههای اجتماعی و فرهنگی بسیار محدود هستند، بنابراین کمک آنها در تفسیر دانش مبهم و غنی از استعاره علوم اجتماعی واقعاً قابل اعتماد نیست.

اگرچه هوش مصنوعی پتانسیل زیادی در تحقیقات علمی به ارمغان میآورد، اما کاربرد آن باید بسیار دقیق باشد، محدودیتهایی دارد و همیشه باید با توانایی تفکر انتقادی محقق همراه باشد.

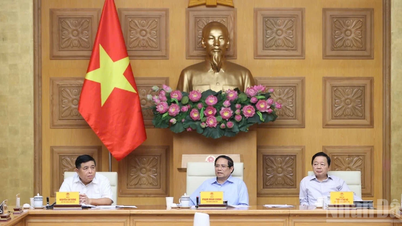

میتوان مشاهده کرد که اگرچه هوش مصنوعی پتانسیل زیادی در تحقیقات علمی به همراه دارد، اما کاربرد آن باید بسیار محتاطانه، محدود و همیشه با ظرفیت انتقادی محقق همراه باشد. فردی که از هوش مصنوعی استفاده میکند باید این محدودیتها را در استفاده از آن به وضوح شناسایی کند و اطمینان حاصل کند که هوش مصنوعی ارزشهای اصلی علم را تغییر نمیدهد. برای محافظت از یکپارچگی تحقیقات علمی، نقش و مسئولیت دانشمندان باید به سطح جدیدی ارتقا یابد. علاوه بر این، لازم است یک چارچوب اخلاقی الزامآور برای هوش مصنوعی در چارچوب فرهنگ، سنتها و هنجارهای اجتماعی ویتنام پیشنهاد شود.

ما سیستمی متشکل از نه اصل برای ترویج تحقیق و توسعه سیستمهای هوش مصنوعی ایمن و مسئولانه، محدود کردن تأثیرات منفی و کنترل خطرات ارائه شده توسط وزارت علوم و فناوری داریم که بر امنیت دادهها و همچنین احترام به حقوق و کرامت انسانی و پاسخگویی کاربران هوش مصنوعی تأکید دارد. به ویژه در تحقیقات علمی، شورای دولتی اساتید نیز در سال 2023 بیانیه رسمی شماره 25/HDGSNN را صادر کرد و از شوراهای عنوان اساتید صنعت و مراکز ارزیابی کیفیت آثار علمی درخواست کرد که توجه ویژهای به شناسایی و ارزیابی آثاری که از فناوری هوش مصنوعی استفاده میکنند یا به آن کمک میکنند، داشته باشند. هدف این الزامات اطمینان از این است که نتایج تحقیقات با استفاده از هوش مصنوعی همچنان مطابق با استانداردهای علمی باشد و از سوءاستفاده از هوش مصنوعی در تحقیقات و انتشارات علمی جلوگیری شود.

در آینده، زمانی که قانون هوش مصنوعی، با مقررات سختگیرانه مربوط به اخلاق و مسئولیت در استفاده از هوش مصنوعی، صادر شود، به ایجاد محیطی سالم برای توسعه هوش مصنوعی کمک خواهد کرد و پشتیبانی فعالتر و مسئولانهتری را برای دانشمندان در کارهای تحقیقاتی فراهم خواهد کرد.

منبع: https://nhandan.vn/canh-giac-voi-mat-trai-cua-ai-post916545.html

![[عکس] مراسم افتتاحیه رسمی دهمین دوره مجلس شورای ملی، پانزدهمین دوره](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760937111622_ndo_br_1-202-jpg.webp)

![[عکس] کمیته راهبری نمایشگاه پاییزی ۲۰۲۵ پیشرفت این سازمان را بررسی میکند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760918203241_nam-5371-jpg.webp)

![[ویدئو] بازار گل و هدایا در شهر هوشی مین به مناسبت بیستم اکتبر شلوغ است](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/20/1760931107653_720-jpg.webp)

![[ویدئو] رهبران حزب و ایالت و نمایندگان مجلس ملی از مقبره رئیس جمهور هوشی مین بازدید کردند](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/20/1760929911350_img-1885-4872-png.webp)

![[عکس] رئیس پارلمان مجارستان از مقبره رئیس جمهور هوشی مین بازدید کرد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760941009023_ndo_br_hungary-jpg.webp)

نظر (0)