ما در دوران انقلاب صنعتی ۴.۰ زندگی میکنیم، جایی که هوش مصنوعی (AI) به تدریج به بخش جداییناپذیر بسیاری از حوزههای زندگی اجتماعی تبدیل میشود. رسانهها، به عنوان پل ارتباطی اطلاعات بین مردم و رویدادها، نمیتوانند از این روند خارج باشند.

|

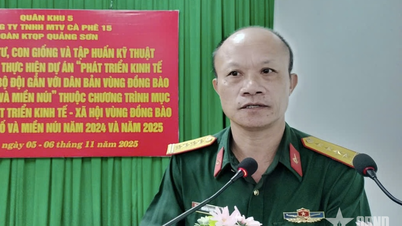

| خانم نگوین تی های ون - مدیر مرکز آموزش روزنامهنگاری، انجمن روزنامهنگاران ویتنام در کارگاه فناوری هوش مصنوعی. (منبع: انجمن روزنامهنگاران ویتنام) |

برای بهرهبرداری حداکثری از مزایای هوش مصنوعی، ارتباطگران باید خود را به دانش لازم برای استفاده مؤثر از هوش مصنوعی مجهز کنند، ضمن اینکه از قابلیت اطمینان و اخلاق در انتقال اطلاعات اطمینان حاصل کنند.

از «داغ بودن» هوش مصنوعی

کاملاً واضح است که هوش مصنوعی (AI) یکی از داغترین کلمات کلیدی امروز است. در سپتامبر 2024، جستجوی کلمه کلیدی "AI" در گوگل در 0.3 ثانیه، 15 میلیارد و 900 میلیون نتیجه را ثبت کرد؛ با کلمه کلیدی "ابزارهای هوش مصنوعی"، در 0.4 ثانیه بیش از 3 میلیارد و 400 میلیون نتیجه ثبت شد. این اعداد عظیم، پوشش و علاقه به هوش مصنوعی و ابزارهای مبتنی بر هوش مصنوعی را در سطح جهانی نشان میدهد.

در حال حاضر، ابزارهای هوش مصنوعی بیشتری برای زمینههای مختلف، از جمله صنعت رسانه، ظاهر میشوند. علاوه بر ChatGPT که به طور گسترده شناخته شده است، برنامههای هوش مصنوعی بسیاری در یک جهت تخصصی توسعه یافتهاند و وظایف تخصصی را انجام میدهند. فهرست کردن بسیاری از ابزارها در اینجا کار دشواری نیست، به عنوان مثال: Bing AI، Clause، Zapier Central برای گروه کاری Chatbot؛ Jasper، Copy.ai، Anyword برای وظایف ایجاد محتوا؛ Descript، Wondershare، Runway برای وظایف تولید و ویرایش ویدیو ؛ DALL-E3، Midjourney، Stable Diffusion برای وظایف ایجاد تصویر؛ Murf، AIVA برای وظایف محتوای صوتی و غیره. و اخیراً، غول آمازون نیز ابزارهای هوش مصنوعی توسعه یافته خود، Video Generator و Image generator را با هدف "الهام بخشیدن به خلاقیت و ایجاد ارزش بیشتر" معرفی کرده است.

اگرچه ابزارهای هوش مصنوعی از نظر مقیاس یا سطح تخصص بسیار متنوع هستند، اما در اصل این فناوری دو چیز مشترک دارد: ابزارهای هوش مصنوعی بر اساس الگوریتمها و دادهها برای «آموزش» ابزارهای هوش مصنوعی توسعه داده میشوند.

کنترل اخلاقی استفاده از هوش مصنوعی در رسانهها

نمیتوان منکر راحتیهایی شد که ابزارهای هوش مصنوعی به ارمغان میآورند و با سرعت بالای بهروزرسانیهای فناوری، ابزارهای تخصصیتر و بیشتری در هر گوشه و کنار وجود خواهند داشت که به وظایف ساده تا پیچیده در صنعت رسانه پاسخ میدهند. در کنار این توسعهی عظیم، سوالات زیادی در مورد مسئلهی کنترل اخلاقی در توسعه و استفاده از ابزارهای هوش مصنوعی در صنعت رسانه مطرح میشود؟ اگر الگوریتمها و دادههای آن ابزار هوش مصنوعی به گونهای دستکاری شوند که برای جامعه مضر باشد، چه اتفاقی خواهد افتاد؟ چه کسی حقوق مالکیت معنوی دادههای ورودی که ابزار هوش مصنوعی برای آموزش استفاده میکند را تضمین میکند؟ چه کسی میزان آسیبی را که ایجاد میکنند ارزیابی میکند؟

آیا بین گروهی از افرادی که به ابزارهای هوش مصنوعی دسترسی دارند و گروهی که در همان کار به آنها دسترسی ندارند، نابرابری وجود دارد؟ حتی سوالاتی در مورد سطح بالقوه آسیب کنترل نشده از ابزارهای هوش مصنوعی، به ویژه در حوزههای حساس که میتوانند بسیاری از افراد را در مقیاس وسیع تحت تأثیر قرار دهند، مانند رسانهها و شبکههای اجتماعی، مطرح شده است.

با درک نگرانیهای فوق، بسیاری از سازمانها، انجمنها، دولتها و حتی شرکتها و موسساتی که ابزارهای هوش مصنوعی را توسعه میدهند، توصیهها، توضیحات و حتی ضوابط رفتاری مربوط به موضوع کنترل اخلاقی در فناوری هوش مصنوعی را صادر کردهاند. اعلامیه اخلاق هوش مصنوعی - توصیه یونسکو - سازمان آموزشی ، علمی و فرهنگی سازمان ملل متحد که در سال ۲۰۲۱ توسط ۱۹۳ کشور تصویب شد، به وضوح بیان میکند که "ظهور سریع هوش مصنوعی (AI) فرصتهای بسیاری را در سطح جهانی ایجاد کرده است، از کمک به تشخیصهای مراقبتهای بهداشتی گرفته تا امکان ارتباط انسانی از طریق رسانههای اجتماعی و ایجاد بهرهوری نیروی کار از طریق وظایف خودکار."

با این حال، این تغییرات سریع نگرانیهای اخلاقی عمیقی را نیز ایجاد میکند. چنین خطراتی مرتبط با هوش مصنوعی، نابرابریهای موجود را تشدید کرده و منجر به آسیب بیشتر به گروههای محروم شده است...» و از آنجا «از یونسکو درخواست میشود ابزارهایی را برای حمایت از کشورهای عضو، از جمله روش ارزیابی آمادگی، ابزاری برای دولتها برای ایجاد تصویری جامع از آمادگی خود برای استقرار اخلاقی و مسئولانه هوش مصنوعی برای همه شهروندان خود، توسعه دهد.

یونسکو در رویکرد جهانی خود، رصدخانه جهانی اخلاق و حکومتداری هوش مصنوعی را راهاندازی کرده است که به گفته آن «اطلاعاتی در مورد آمادگی کشورها برای پذیرش اخلاقی و مسئولانه هوش مصنوعی ارائه میدهد. این سازمان همچنین میزبان آزمایشگاه اخلاق و حکومتداری هوش مصنوعی است که مشارکتها، تحقیقات تأثیرگذار، ابزارها و شیوههای مثبت را در طیف گستردهای از مسائل اخلاق هوش مصنوعی گرد هم میآورد...»

علاوه بر سازمانهای جهانی مانند یونسکو، بسیاری از انجمنهای حرفهای نیز در حال تلاش برای تدوین استانداردهای خود هستند، به عنوان مثال، IABC - انجمن بینالمللی ارتباطات تجاری، انجمنی با هزاران عضو از سراسر جهان، مجموعهای از اصول را برای هدایت استفاده اخلاقی از هوش مصنوعی توسط متخصصان ارتباطات تدوین کرده است که هدف آن راهنمایی اعضای IABC در مورد ارتباط کد اخلاق IABC با هوش مصنوعی است. این دستورالعملها ممکن است به موازات توسعه فناوری هوش مصنوعی، به مرور زمان بهروزرسانی و تکمیل شوند. در این مجموعه اصول، نکات خاص بسیاری وجود دارد که یک متخصص ارتباطات باید به آنها پایبند باشد، مانند:

«منابع هوش مصنوعی مورد استفاده باید توسط انسان هدایت شوند تا تجربیات مثبت و شفافی ایجاد کنند که باعث احترام و ایجاد اعتماد در حرفه رسانه شود. مهم است که در مورد فرصتها و خطرات حرفهای که ابزارهای هوش مصنوعی ارائه میدهند، آگاه باشید. اطلاعات باید به طور دقیق، عینی و منصفانه منتقل شوند. ابزارهای هوش مصنوعی میتوانند در معرض خطاها، تناقضات و سایر مسائل فنی زیادی قرار گیرند. این امر مستلزم قضاوت انسانی است تا به طور مستقل تأیید کند که محتوای تولید شده توسط هوش مصنوعی من دقیق، شفاف و دارای کپیبرداری است.»

از اطلاعات شخصی و/یا محرمانه دیگران محافظت میکند و بدون اجازه آنها از آنها استفاده نخواهد کرد. خروجیهای هوش مصنوعی خود را بر اساس تعامل انسانی و درک جامعهای که قصد خدمت به آن را دارد، ارزیابی میکند. تا حد امکان تعصب را از بین میبرد و نسبت به ارزشها و باورهای فرهنگی دیگران حساس است.

باید به طور مستقل خروجیهای خود را با دقت حرفهای لازم، راستیآزمایی و تأیید کنند تا اطمینان حاصل شود که اسناد، اطلاعات یا مراجع شخص ثالث دقیق هستند، دارای ارجاع و تأیید لازم هستند و به درستی مجوز یا مجوز استفاده دارند. سعی در پنهان کردن یا تغییر ظاهر استفاده از هوش مصنوعی در خروجی حرفهای خود ندارند. ماهیت منبع باز هوش مصنوعی و مسائل مربوط به محرمانگی، از جمله ورود اطلاعات نادرست، گمراهکننده یا فریبنده را تشخیص دهند.

شرکتها و موسساتی که ابزارهای هوش مصنوعی را در اختیار دارند، توسعه میدهند و معامله میکنند، کسانی هستند که جزئیات ابزارهای هوش مصنوعی را بهتر از هر کس دیگری درک میکنند، آنها الگوریتمهای اساسی که ابزارهای هوش مصنوعی بر اساس آنها کار میکنند و دادههایی که ابزارهای هوش مصنوعی از آنها آموزش میبینند را میشناسند. بنابراین، این شرکتها همچنین باید اطلاعاتی در رابطه با اصول اخلاق در توسعه هوش مصنوعی ارائه دهند. در واقع، شرکتهایی وجود دارند که به این موضوع علاقهمند هستند.

گوگل متعهد است که ابزارهای هوش مصنوعی را برای مناطقی که خطر آسیب قابل توجهی وجود دارد، توسعه ندهد. ما فقط در مواردی که معتقدیم مزایای آن به طور قابل توجهی از خطرات بیشتر است و حفاظهای مناسب را در نظر میگیریم، اقدام خواهیم کرد. سلاحها یا سایر فناوریهایی که هدف اصلی یا استقرار آنها ایجاد یا تسهیل مستقیم آسیب انسانی است. فناوریهایی که اطلاعات را برای نظارت جمعآوری یا استفاده میکنند و هنجارهای پذیرفته شده بینالمللی را نقض میکنند. فناوریهایی که هدف آنها نقض اصول پذیرفته شده عمومی حقوق بینالملل و حقوق بشر است.

در حوزه امنیت و ایمنی، گوگل متعهد میشود: «ما به توسعه و اجرای اقدامات امنیتی و ایمنی قوی برای جلوگیری از پیامدهای ناخواستهای که خطرات آسیبزا ایجاد میکنند، ادامه خواهیم داد. ما سیستمهای هوش مصنوعی خود را به گونهای طراحی خواهیم کرد که به طور مناسب محتاط باشند و به دنبال توسعه آنها مطابق با بهترین شیوهها در تحقیقات ایمنی هوش مصنوعی خواهیم بود. ما اصول حریم خصوصی خود را در توسعه و استفاده از فناوریهای هوش مصنوعی خود لحاظ خواهیم کرد. ما فرصتهایی را برای اطلاعرسانی و رضایت فراهم خواهیم کرد، معماریهای محافظت از حریم خصوصی را تشویق خواهیم کرد و شفافیت و کنترلهای مناسبی را بر استفاده از دادهها فراهم خواهیم کرد.»

مشابه گوگل، مایکروسافت نیز بیانیهای در مورد اصول و رویکرد هوش مصنوعی منتشر کرد و تأکید کرد: «ما متعهد هستیم که اطمینان حاصل کنیم سیستمهای هوش مصنوعی مسئولانه و به گونهای توسعه مییابند که اعتماد مردم را تضمین کند...». علاوه بر این، به هر طریقی، شرکتهای بزرگ فناوری مانند آمازون و OpenAI که سرمایهگذاریهای هنگفتی در توسعه ابزارهای هوش مصنوعی انجام میدهند نیز تعهدات خود را پذیرفتهاند.

نمونههای زیادی در تاریخ، دوگانگی فناوری، شامل عوامل مثبت و منفی، را ثابت کردهاند. گذشته از همه اینها، اگرچه هوش مصنوعی یک پلتفرم فناوری بسیار «پیشرفته» است، اما همچنان مبتنی بر الگوریتمها و دادههایی است که توسط انسانها توسعه یافته و جمعآوری شدهاند؛ در عین حال، اکثر محصولات هوش مصنوعی بخشی از برنامههای تجاری شرکتهای مالک آنها هستند.

بنابراین، همیشه خطرات بالقوهای از طرف فنی و همچنین از طرف خود تیم توسعه و مدیریت محصول وجود دارد. مشکل اینجا میزان تأثیری است که ابزارهای هوش مصنوعی میتوانند بر اکثریت، حتی بر سطح اجتماعی-اقتصادی یک جامعه داشته باشند. توجه به موقع به کنترل اخلاقی هنگام استفاده از فناوری هوش مصنوعی، با مشارکت سازمانهای بینالمللی بزرگ مانند سازمان ملل متحد، دولتها، انجمنهای صنعتی و مهمتر از همه، درست در واحدهای توسعه فناوری، نشانهی خوشایندی است.

با این حال، از آنجایی که فهرست ابزارهای هوش مصنوعی به طور مداوم نسخههای جدیدی را منتشر میکند که هر کدام پیچیدهتر و پیشرفتهتر از نسخه قبلی هستند، ضوابط، اصول یا دستورالعملها نیز باید به موقع بهروزرسانی و تکمیل شوند و علاوه بر این، باید در پیشگیری، محدود کردن و کنترل توسعهدهندگان و کاربران محصول در چارچوبی که در آن توانایی رعایت کنترل اخلاقی در فناوری هوش مصنوعی به طور کلی و به ویژه در کارکنان رسانه میتواند به بالاترین بهرهوری دست یابد، پیشگیرانه عمل کنند.

منبع

![[عکس] اختتامیه چهاردهمین کنفرانس سیزدهمین کمیته مرکزی حزب](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762404919012_a1-bnd-5975-5183-jpg.webp)

![[عکس] نخست وزیر فام مین چین، هیئت نمایندگی شرکت بینالمللی تولید نیمههادی (SEMI) را به حضور پذیرفت.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/06/1762434628831_dsc-0219-jpg.webp)

نظر (0)