دفتر دادستان کل نیوهمپشایر روز دوشنبه اعلام کرد که پس از شکایاتی مبنی بر وجود صدای جعلی که دقیقاً شبیه صدای جو بایدن، رئیس جمهور آمریکا بود و از رأی دهندگان میخواست در انتخابات مقدماتی این ایالت رأی ندهند، در حال بررسی احتمال دستکاری آرای رأی دهندگان است.

محققان همچنین در مورد استفاده از صدای دیپفیک برای تقلید از سیاستمداران و رهبران هشدار دادند و موارد برجستهای از آن در سال ۲۰۲۳ در بریتانیا، هند، نیجریه، سودان، اتیوپی و اسلواکی رخ داده است.

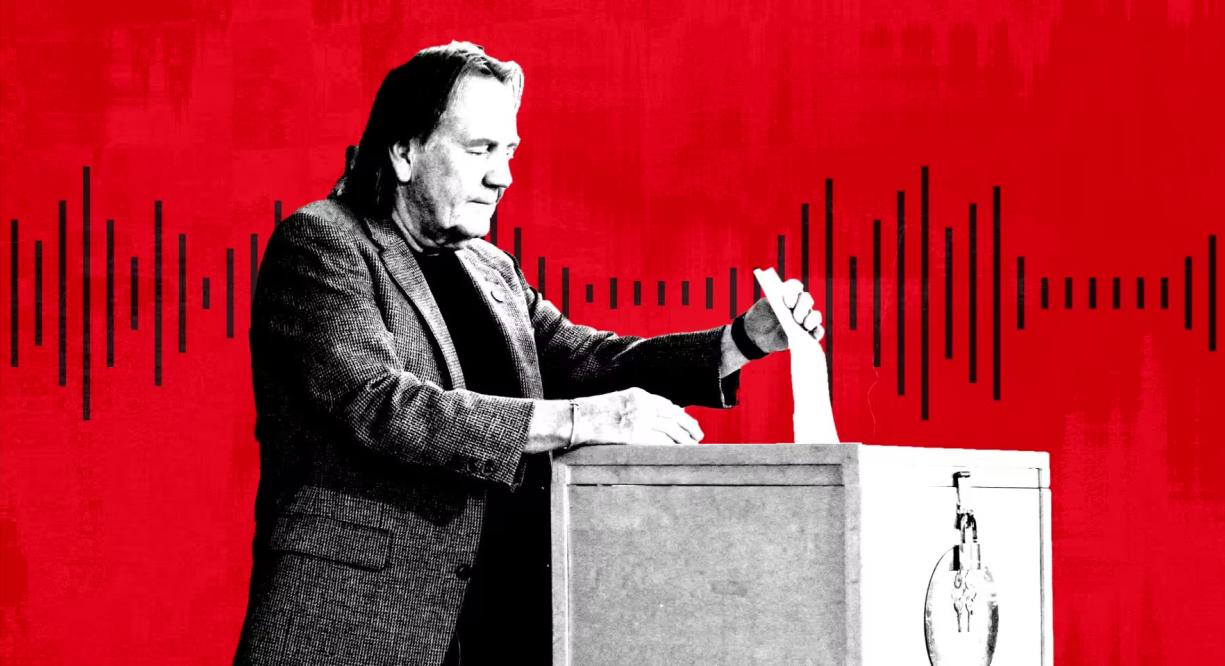

فردی در انتخابات مقدماتی در نیوهمپشایر، ایالات متحده آمریکا رأی میدهد. عکس: گتی

به گفته کارشناسان، به دلیل ظهور طیف وسیعی از ابزارهای هوش مصنوعی ارزان و مؤثر از سوی استارتآپها، صدای دیپفیک به نوعی محبوب از اطلاعات نادرست تبدیل شده است. مایکروسافت همچنین یک مدل هوش مصنوعی جدید توسعه داده است که میتواند صداها را تنها از سه ثانیه ضبط کپی کند.

هنری آجدر، متخصص هوش مصنوعی و جعل عمیق و مشاور ادوبی، متا و EY، گفت: «وقتی صحبت از دستکاری بصری میشود، همه با فتوشاپ آشنا هستند یا حداقل میدانند که وجود دارد. آگاهی بسیار کمی در مورد چگونگی دستکاری صدا وجود دارد، بنابراین به نظر من این واقعاً ما را آسیبپذیر میکند.»

در ماه سپتامبر، NewsGuard، سیستمی که کیفیت و قابل اعتماد بودن سایتهای خبری را ارزیابی میکند، شبکهای از حسابهای TikTok را کشف کرد که خود را به عنوان سایتهای خبری معتبر جا میزدند و از محتوای تولید شده توسط هوش مصنوعی برای انتشار نظریههای توطئه و اطلاعات نادرست سیاسی استفاده میکردند. فایلهای ضبط شده با دیپفیک، از جمله صدای باراک اوباما، رئیس جمهور سابق آمریکا، صدها میلیون بازدید به دست آوردند.

به گفتهی NewsGuard، به نظر میرسد این صداهای جعلی توسط ابزاری که توسط ElevenLabs، شرکت تحت حمایت Andreessen Horowitz، ارائه شده، تولید شدهاند، در حالی که این کلیپها صدها میلیون بازدید داشتهاند.

ElevenLabs گفت: «بیش از ۹۹٪ از کاربران پلتفرم ما محتوای جالب، خلاقانه و مفید تولید میکنند، اما ما میدانیم که مواردی از سوءاستفاده وجود دارد و به طور مداوم اقدامات حفاظتی را برای محدود کردن آنها توسعه داده و معرفی کردهایم.»

شرکت ElevenLabs که دو سال پیش توسط کارمندان سابق گوگل و پالانتیر، پیوتر دابکوفسکی و ماتی استانیشوسکی، تأسیس شد، ابزارهای تولید صدای هوش مصنوعی ابتدایی را تنها با یک کلیک به صورت رایگان ارائه میدهد. طرحهای اشتراک از ۱ دلار در ماه تا ۳۳۰ دلار در ماه و بیشتر برای کسانی که به دنبال خدمات پیچیدهتر هستند، متغیر است.

سال گذشته، سازمانهای اطلاعاتی ایالات متحده در گزارشی هشدار دادند که «کلاهبرداریهای شخصیسازیشده با هوش مصنوعی به دلیل انتشار مدلهای شبیهسازی صدای پیشرفته و آموزشدیده هوش مصنوعی، به طور قابل توجهی افزایش یافته است.»

علاوه بر کلاهبرداریهای با انگیزه مالی، کارشناسان سیاسی اکنون زنگ خطر را در مورد کلیپهای صوتی دیپفیک ویروسی و همچنین استفاده از دیپفیک برای تماسهای رباتیک یا کمپینها به صدا درآوردهاند. ایجی نش، معاون رئیس و عضو برجسته اطلاعاتی در گروه امنیت سایبری زیرو فاکس، گفت: «شما میتوانید با هدف قرار دادن تلفنها، یک کمپین قدرتمند و گسترده برای انتشار اطلاعات نادرست ایجاد کنید.»

برخی از این شرکتها در یافتن راههای دیگری برای مبارزه با اطلاعات نادرست، پیشگام بودهاند. مایکروسافت بیانیهای اخلاقی صادر کرده و از کاربران خواسته است هرگونه سوءاستفاده از ابزار صوتی هوش مصنوعی خود را گزارش دهند. ElevenLabs ابزارهای تشخیص خود را برای شناسایی ضبطهای صوتی ایجاد شده توسط سیستم خود ساخته است.

به گفته گروه حقوق بشری فریدم هاوس، در جریان انتخابات ۲۰۲۳ نیجریه، کلیپی که با هوش مصنوعی دستکاری شده بود، در رسانههای اجتماعی به سرعت پخش شد و «گویا حاکی از آن بود که یک نامزد مخالف قصد دارد در آرا تقلب کند».

در اسلواکی، یک فایل صوتی جعلی از نامزد اپوزیسیون، میخال شیمچکا، که ظاهراً در حال توطئه برای تقلب در انتخابات است، تنها چند روز قبل از انتخابات ریاست جمهوری این کشور در ماه سپتامبر، به سرعت در فضای مجازی پخش شد.

رابرت وایزمن، رئیس گروه غیرانتفاعی حمایت از مصرفکنندگان پابلیک سیتیزن، گفت: «دیپفیک نیوهمپشایر یادآور روشهای مختلفی است که دیپفیک میتواند افراد را گیج و فریب دهد. لحظه سیاسی دیپفیک فرا رسیده است. سیاستگذاران باید به سرعت اقدامات حفاظتی را انجام دهند، در غیر این صورت با هرج و مرج انتخاباتی مواجه خواهیم شد.»

مای آن (طبق گزارش فایننشال تایمز)

منبع

![[عکس] رسوبات شن و ماسه در اعماق دریا، کشتی چوبی باستانی آن بنگ دوباره در معرض خطر دفن شدن قرار دارد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/13/1763033175715_ndo_br_thuyen-1-jpg.webp)

![[عکس] پانوراما از دومین تبادل دوستی دفاع مرزی ویتنام و کامبوج](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/13/1763033233033_image.jpeg)

![گذار دونگ نای OCOP: [ماده 3] پیوند گردشگری با مصرف محصولات OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

نظر (0)