مقررات باید باز باشند.

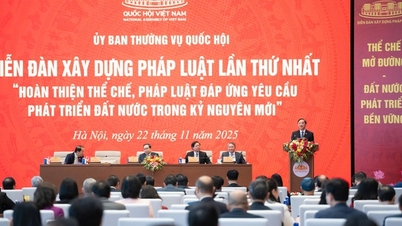

در ادامه دهمین جلسه، صبح روز ۲۱ نوامبر، مجلس ملی به صورت گروهی پیشنویس قانون هوش مصنوعی را مورد بحث قرار داد.

نمایندگان گروه ۴ (شامل هیئتهای مجلس ملی از استانهای خان هوا ، لای چائو و لائو کای) با ارائه نظرات خود، اساساً با ضرورت اعلام قانون موافقت کردند.

به گفته نگوین هو توآن ( لای چائو )، معاون مجلس ملی، تصویب قانون هوش مصنوعی (AI) در حال حاضر بسیار ضروری است. «ما مقدمات نسبتاً خوبی را برای ارائه این قانون به مجلس ملی فراهم کردهایم.»

نگوین تی لان آن (لائو کای)، معاون مجلس ملی، گفت که در حال حاضر، تعداد بسیار کمی از کشورها قانون هوش مصنوعی را صادر کردهاند، بنابراین ارجاعات در روند ابلاغ قانون نیز محدود است. با این حال، این نماینده تأکید کرد: «این بدان معنا نیست که ما نباید آن را ابلاغ کنیم».

با این حال، نماینده نگوین تی لان آنه خاطرنشان کرد که اعلام این قانون باید عامل «باز بودن» را در نظر بگیرد، زیرا فناوری همیشه روز به روز و ساعت به ساعت در حال توسعه است. «اگر این قانون در یک چارچوب محدود اعلام شود، ما بدون احتیاط قادر به ترویج حوزه فناوری نوآورانه نخواهیم بود.»

در نظر گرفتن مقررات ایالتی برای تضمین حق بهرهمندی از مزایای هوش مصنوعی

نماینده نگوین هوو توآن با ارائه نظرات خاص گفت که پیشنویس قانون، موضوعات مورد اجرا (ماده ۲) را به شرح زیر تصریح میکند: آژانسها، سازمانها، افراد ویتنامی و سازمانها و افراد خارجی که فعالیتهایی در زمینه توسعه، ارائه، استقرار و استفاده از سیستمهای هوش مصنوعی در ویتنام دارند، یا سیستمهای هوش مصنوعی دارند که نتایجی را تولید میکنند که در ویتنام استفاده میشود .

با این حال، دامنه مقررات (بند ۲، ماده ۱) تصریح میکند: این قانون در مورد سیستمهای هوش مصنوعی که منحصراً برای اهداف دفاعی، امنیتی، اطلاعاتی و رمزنگاری توسعه، ارائه، مستقر و استفاده میشوند، اعمال نمیشود.

به گفته این نماینده، اجرای این قانون همچنان باید دفاع و امنیت ملی را تضمین کند، زیرا محصولات هوش مصنوعی از خارج از مرز به ویتنام ارائه میشوند.

بنابراین، پیشنویس قانون نباید «سیستمهای هوش مصنوعی توسعهیافته، ارائهشده، مستقرشده و منحصراً برای اهداف دفاعی، امنیتی، اطلاعاتی و رمزنگاری» را به عنوان یک نکتهی استثنا در نظر بگیرد. در عوض، باید به گونهای تنظیم شود که تحقیق، توسعه، ارائه، استقرار و استفاده از سیستمهای هوش مصنوعی برای اهداف دفاعی، امنیتی، اطلاعاتی و رمزنگاری به وزارت دفاع ملی یا وزارت امنیت عمومی برای راهنمایی واگذار شود.

همچنین در بند ۲، ماده ۱ تصریح میکند: این قانون در مورد سیستمهای هوش مصنوعی یا مدلهای هوش مصنوعی که فقط در محدوده داخلی تأسیسات تحقیقات علمی، آموزشی و توسعهای توسعه یافته، ارائه شده، مستقر شده و مورد استفاده قرار گرفتهاند و به بهرهبرداری نرسیده یا در اختیار اشخاص ثالث قرار نگرفتهاند، اعمال نمیشود.

نماینده نگوین هو توآن با تأیید اینکه سیستمهای هوش مصنوعی مورد استفاده در محدوده تأسیسات تحقیقاتی مشمول قانون نیستند، خاطرنشان کرد که اگر سیستمی قانون را نقض کند، باید با آن برخورد شود.

در واقع، سیستمهای داخلی بسیار کوچک و همچنین سیستمهای داخلی بسیار بزرگی وجود دارند. نماینده تأکید کرد: «استفاده داخلی باید مطابق با شرایط و مقررات باشد» و قانون باید دارای مقررات باشد.

پیشنویس قانون به طور خاص هشت سیاست ایالتی در مورد هوش مصنوعی را تصریح میکند (ماده ۵). نماینده نگوین هو توآن، با موافقت اساسی با این سیاستها، پیشنهاد داد که برخی نکات باید روشن شوند.

به طور خاص، بند ۳، ماده ۵ تصریح میکند: دولت حق سازمانها و افراد را برای دسترسی، یادگیری و بهرهمندی از مزایای هوش مصنوعی تضمین میکند؛ توسعه یک جامعه دیجیتال جامع و فراگیر را ترویج میدهد.

به گفته این نماینده، مناسب است که دولت حق دسترسی به هوش مصنوعی را تضمین کند. با این حال، برای بهرهمندی از مزایای هوش مصنوعی، کاربران باید پول خود را نیز برای سرمایهگذاری و بهکارگیری آن در محیط تولید و کسبوکار هزینه کنند...؛ دولت موظف به تضمین کامل این امر نیست. بنابراین، لازم است این آییننامه بر این اساس اصلاح شود.

در مورد سطح ریسک سیستمهای هوش مصنوعی، ماده ۷ پیشنویس قانون، آنها را به ۴ نوع تقسیم میکند: ریسک غیرقابل قبول؛ ریسک بالا؛ ریسک متوسط؛ ریسک پایین.

با این حال، به گفته نماینده نگوین هو توآن، با این طبقهبندی موافق است و کاربرد آن در عمل برای گروههای هدف مختلف متفاوت است. به عنوان مثال، نوعی خطر متوسط وجود دارد که بزرگسالان را تحت تأثیر قرار نمیدهد اما کودکان را تحت تأثیر قرار میدهد؛ یا در مناطقی با شرایط دسترسی نامناسبتر، به یک خطر بالا تبدیل میشود...

بنابراین، نمایندگان پیشنهاد کردند که هر نوع خطر باید به وضوح تعریف و برای هر موضوع اعمال شود و باید هشدارهایی وجود داشته باشد، به عنوان مثال، چترهای کمخطری وجود دارند که فقط برای بزرگسالان ارائه میشوند، نه کودکان.

ساخت سیستم نظارت و هشدار حادثه

یکی از مسائلی که نمایندگان به آن بسیار علاقهمند هستند، مربوط به مدیریت و رسیدگی به حوادث هوش مصنوعی است. پیشنویس قانون تعریف میکند: حادثه جدی، حادثهای فنی در فعالیتهای هوش مصنوعی است که باعث ایجاد یا تهدید به ایجاد عواقب جدی برای زندگی، سلامت، اموال، دادهها، امنیت یا نظم اجتماعی انسان میشود.

نماینده نگوین تی لان آنه تحلیل کرد که در حوزه پزشکی سطوح مختلفی وجود دارد، و امنیت نیز همینطور است.

«بنابراین روند ارزیابی این حادثه چگونه است؟ کدام طرف، کدام سازوکار اطلاعرسانی خواهد کرد؟ زیرا مواردی وجود دارد که وقتی پس از وقوع حادثه کشف میشوند، بسیار خطرناک هستند. به خصوص در حوزه پزشکی که مستقیماً با جان انسان مرتبط است.»

نماینده نگوین تی لان آن با طرح این موضوع گفت که ما باید یک سیستم فرآیندی طراحی کنیم. اول از همه، باید در مورد فرآیند پردازش صحبت کنیم، چه کسی آن را مدیریت میکند و در چه سطحی هشدار وجود خواهد داشت؟ دوم، باید یک سیستم نظارت و هشدار اولیه وجود داشته باشد. این بسیار مهم است و اگر هشدار اولیه میخواهیم، باید از ورود دادههای ورودی اطمینان حاصل کنیم.

همچنین به گفته نماینده نگوین تی لان آن، موضوع مسئولیت باید بسیار واضح باشد: آیا این مسئولیت بر عهده توسعهدهنده مدل است، یا سازمان مدیریت، یا کاربر نهایی؟

به طور خلاصه، به گفته نمایندگان، طبقهبندی و تعریف انواع خاصی از حوادث هوش مصنوعی ضروری است. یک سیستم نظارت و هشدار برای حوادث ایجاد کنید؛ فرآیند رسیدگی را بر اساس هر گروه سطح ریسک مشخص کنید، پشتیبانی فنی و قانونی طرفهای ذیربط را افزایش دهید؛ و در مورد مسئولیتهای قانونی مربوط به مکانیسمهای جبران خسارت شفافتر باشید. این امر هم امنیت و هم ایمنی شبکه را تضمین میکند.

بند ۲، ماده ۱۰ پیشنویس قانون تصریح میکند: هنگامی که یک سیستم هوش مصنوعی دچار حادثه جدی میشود، توسعهدهنده سیستم، تأمینکننده و طرف پیادهسازی سیستم هوش مصنوعی مسئول موارد زیر خواهند بود: الف) توسعهدهنده و تأمینکننده سیستم باید فوراً اقدامات فنی را برای رفع، تعلیق یا لغو سیستم اعمال کرده و به مرجع ذیصلاح اطلاع دهند؛ ب) طرف پیادهسازی و کاربر موظفند فوراً حادثه را ثبت و اطلاع دهند و در فرآیند اصلاح هماهنگی لازم را انجام دهند.

«خب، اگر حادثه کمتر جدی باشد چه؟» نماینده نگوین هو توآن با زیر سوال بردن این سوال، پیشنهاد داد که به جای اینکه منتظر بمانیم تا حادثه جدی شود و سپس به آن رسیدگی کنیم، باید هشداری وجود داشته باشد. زیرا در کاربرد هوش مصنوعی، اگر حادثهای در سطح جدی رخ دهد، سرعت انتشار آن بسیار سریع و زیاد است.

نماینده نگوین هو توآن پیشنهاد داد که پایینتر از این سطح، باید هشدارهایی برای کاربران و تأمینکنندگان وجود داشته باشد. این نماینده افزود: «نظارت و بررسی استفاده از هوش مصنوعی در آینده برای تضمین امنیت، نظم، ایمنی اجتماعی و همچنین شادی برای همه بسیار مهم است.»

در مورد مسائل اخلاقی در هوش مصنوعی، پیشنویس قانون به وضوح چارچوب اخلاقی ملی هوش مصنوعی (ماده ۲۷) و مسئولیتهای اخلاقی و ارزیابی تأثیر هنگام بهکارگیری هوش مصنوعی در بخش عمومی (ماده ۲۸) را تصریح میکند.

«پس چگونه برای بخش خصوصی یا سایر حوزههایی که بر مردم یا سایر سازمانها و سیاستها تأثیر میگذارند، محاسبه میشود؟»

نماینده نگوین تی لان آن پیشنهاد داد که لازم است مسئولیت اخلاقی به بخش خصوصی گسترش یابد و کسب و کارها ملزم شوند که به طور عمومی یک آییننامه اخلاقی داخلی تدوین کنند؛ اصول اخلاقی و تعهدات قانونی را به وضوح از هم متمایز کنند تا از ثبات و امکانسنجی در اجرا اطمینان حاصل شود.

در عین حال، پیشنویس قانون باید اصول اخلاقی اساسی مانند احترام به مردم، انصاف، شفافیت را تکمیل کند و سازوکارهای ارزیابی تأثیر اجباری را برای سیستمهای هوش مصنوعی پرخطر ایجاد کند.

منبع: https://daibieunhandan.vn/du-an-luat-tri-tue-nhan-tao-mo-rong-trach-nhiem-dao-duc-sang-khu-vuc-tu-nhan-10396512.html

نظر (0)