डीपफेक आवाज से नकल करके घोटाला

तेज़ी से विकसित हो रहे कृत्रिम बुद्धिमत्ता के युग में, आवाज़ - जिसे कभी प्रामाणिक प्रमाण माना जाता था - अब बदमाशों के हाथों में एक खतरनाक हथियार बन गई है। डीपफेक वॉयस तकनीक नकली आवाज़ों को असली लोगों से हूबहू मिलाने की अनुमति देती है, जिससे धोखाधड़ी और संपत्ति हड़पने के लिए परिष्कृत नकली कॉल किए जा सकते हैं।

डीपफेक आवाज डरावनी क्यों है?

डीपफेक वॉयस एक ऐसी तकनीक है जो कृत्रिम बुद्धिमत्ता (एआई) और मशीन लर्निंग का उपयोग करके एक नकली आवाज तैयार करती है जो वास्तविक व्यक्ति की आवाज के समान होती है।

टैकोट्रॉन, वेवनेट, इलेवनलैब्स जैसे आधुनिक मॉडलों या रिस्पीचर जैसे वॉयस क्लोनिंग प्लेटफार्मों के समर्थन से, धोखेबाजों को 95% विश्वसनीय डीपफेक बनाने के लिए केवल 3 - 10 सेकंड के वॉयस सैंपल की आवश्यकता होती है।

डीपफेक आवाज विशेष रूप से खतरनाक हो जाती है, क्योंकि इसमें आवाज की लगभग पूरी तरह से नकल करने की क्षमता होती है, उच्चारण, स्वर से लेकर प्रत्येक व्यक्ति की अद्वितीय बोलने की आदतों तक।

इससे पीड़ितों के लिए असली और नकली के बीच अंतर करना बहुत मुश्किल हो जाता है, खासकर जब आवाज उनके रिश्तेदारों, दोस्तों या वरिष्ठों की हो।

वॉइस माइनिंग भी बहुत आसान है, क्योंकि आजकल ज़्यादातर लोग टिकटॉक, सोशल मीडिया लाइवस्ट्रीम, पॉडकास्ट या ऑनलाइन मीटिंग जैसे प्लेटफ़ॉर्म के ज़रिए अपनी आवाज़ सार्वजनिक करते हैं। इससे भी ज़्यादा चिंताजनक बात यह है कि डीपफ़ेक आवाज़ें तस्वीरों या वीडियो जैसे दृश्य निशान नहीं छोड़तीं, जिससे जाँच मुश्किल हो जाती है और पीड़ितों को पैसे गंवाने का ख़तरा रहता है।

कुछ सेकंड के वॉयस सैंपल से डीपफेक बनाया जा सकता है

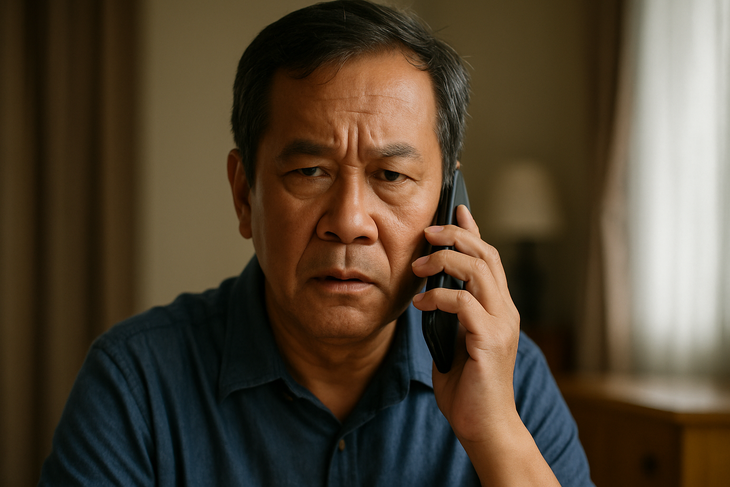

डीपफेक वॉयस घोटाले तेजी से परिष्कृत होते जा रहे हैं, जिनमें अक्सर एक परिचित परिदृश्य का उपयोग किया जाता है: किसी आपातकालीन स्थिति में किसी परिचित की आवाज की नकल करके, आतंक पैदा करना और पीड़ितों पर तुरंत धन हस्तांतरित करने का दबाव बनाना।

वियतनाम में, एक माँ को उसके "बेटे" का फ़ोन आया जिसमें बताया गया कि उसका एक्सीडेंट हो गया है और उसे तुरंत पैसों की ज़रूरत है। ब्रिटेन में, एक कंपनी के निदेशक को अपने "बॉस" द्वारा फ़ोन पर पैसे ट्रांसफर करने का अनुरोध सुनने के बाद 2,40,000 अमेरिकी डॉलर से ज़्यादा की ठगी का शिकार होना पड़ा। एक प्रशासनिक कर्मचारी को भी एक "बड़े बॉस" से एक "रणनीतिक साझेदार" को भुगतान करने का अनुरोध मिलने पर ठगा गया...

इन स्थितियों में आम बात यह है कि नकली आवाज हूबहू रिश्तेदार या वरिष्ठ की तरह सुनाई जाती है, जिससे पीड़ित को पूरी तरह से भरोसा हो जाता है और उसे सत्यापन का समय नहीं मिल पाता।

हमेशा सत्यापित करें, तुरंत विश्वास न करें

डीपफेक वॉयस स्कैम के बढ़ते मामलों को देखते हुए, लोगों को सलाह दी जाती है कि वे फ़ोन पर सिर्फ़ आवाज़ के आधार पर पैसे ट्रांसफर न करें, भले ही वह आवाज़ किसी प्रियजन की ही क्यों न हो। इसके बजाय, कोई भी लेन-देन करने से पहले पुराने नंबर पर कॉल करें या विभिन्न माध्यमों से जानकारी की जाँच करें।

कई विशेषज्ञ असामान्य परिस्थितियों में सत्यापन के लिए घर या व्यवसाय में "आंतरिक पासवर्ड" स्थापित करने की भी सलाह देते हैं।

इसके अलावा, सोशल नेटवर्क पर स्पष्ट आवाज़ वाले वीडियो, खासकर लंबी सामग्री, पोस्ट करने पर रोक लगाना ज़रूरी है। ख़ास तौर पर, कमज़ोर समूहों, जैसे बुज़ुर्गों या तकनीक से कम परिचित लोगों को सक्रिय रूप से चेतावनी देना और उनका मार्गदर्शन करना ज़रूरी है, क्योंकि ये हाई-टेक घोटालों के प्राथमिक लक्ष्य होते हैं।

रिश्तेदारों, मित्रों और सहकर्मियों की आवाजें भी नकली हो सकती हैं।

कई देशों में, प्राधिकारियों ने अपने स्वयं के कानूनी ढांचे के साथ डीपफेक प्रौद्योगिकी के प्रबंधन को कड़ा करना शुरू कर दिया है।

अमेरिका में, कई राज्यों ने चुनाव अभियानों में या गलत सूचना फैलाने के लिए डीपफेक के इस्तेमाल पर प्रतिबंध लगा दिया है। यूरोपीय संघ (ईयू) ने एआई अधिनियम पारित किया है, जिसके तहत संगठनों को पारदर्शी होना होगा और अगर कोई सामग्री कृत्रिम बुद्धिमत्ता से उत्पन्न होती है, तो स्पष्ट रूप से चेतावनी देनी होगी।

इस बीच, वियतनाम में, हालांकि डीपफेक आवाजों के लिए कोई विशिष्ट नियम नहीं हैं, लेकिन संबंधित कृत्यों को वर्तमान कानून के अनुसार नियंत्रित किया जा सकता है, जिसमें धोखाधड़ी, संपत्ति विनियोग, गोपनीयता का उल्लंघन या पहचान जालसाजी जैसे अपराध शामिल हैं।

हालांकि, वास्तविकता यह है कि प्रौद्योगिकी का विकास इतनी तेजी से हो रहा है कि उस पर निगरानी रखना कानून की क्षमता से परे है, जिससे कई खामियां रह जाती हैं, जिनका गलत लोग फायदा उठा सकते हैं।

जब आवाज़ सबूत नहीं रह जाती

आवाज़ पहले एक अंतरंग और भरोसेमंद चीज़ हुआ करती थी, लेकिन डीपफेक आवाज़ के साथ, यह अब कोई ठोस सबूत नहीं रह गया है। एआई के युग में, प्रत्येक व्यक्ति को डिजिटल सुरक्षा का ज्ञान होना चाहिए, सक्रिय रूप से सत्यापन करना चाहिए और हमेशा सतर्क रहना चाहिए क्योंकि कॉल एक जाल बन सकती है।

स्रोत: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

![[फोटो] ह्यू सिटाडेल के प्रवेश द्वार के दाईं ओर बाढ़](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/28/1761660788143_ndo_br_gen-h-z7165069467254-74c71c36d0cb396744b678cec80552f0-2-jpg.webp)

![[फोटो] प्रधानमंत्री फाम मिन्ह चीन्ह ने मध्य प्रांतों में बाढ़ के परिणामों पर काबू पाने के समाधानों पर चर्चा करने के लिए एक बैठक की अध्यक्षता की।](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761716305524_dsc-7735-jpg.webp)

![[फोटो] ह्यू: उस रसोई के अंदर जो बाढ़ प्रभावित इलाकों में लोगों को रोज़ाना हज़ारों लोगों का खाना मुहैया कराती है](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761738508516_bepcomhue-jpg.webp)

![[इन्फोग्राफिक] 5 वर्षों 2021-2025 में वियतनाम की सामाजिक-आर्थिक स्थिति: प्रभावशाली संख्याएँ](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/29/1761730747150_anh-man-hinh-2025-10-29-luc-16-38-55.png)

टिप्पणी (0)