これを受けて、人工知能(AI)が作成したペンタゴン付近の爆発写真が5月22日に米国のソーシャルネットワーク上で共有され、株価が瞬く間に急落するなど、AIによるフェイクニュースへの懸念が高まっている。

|

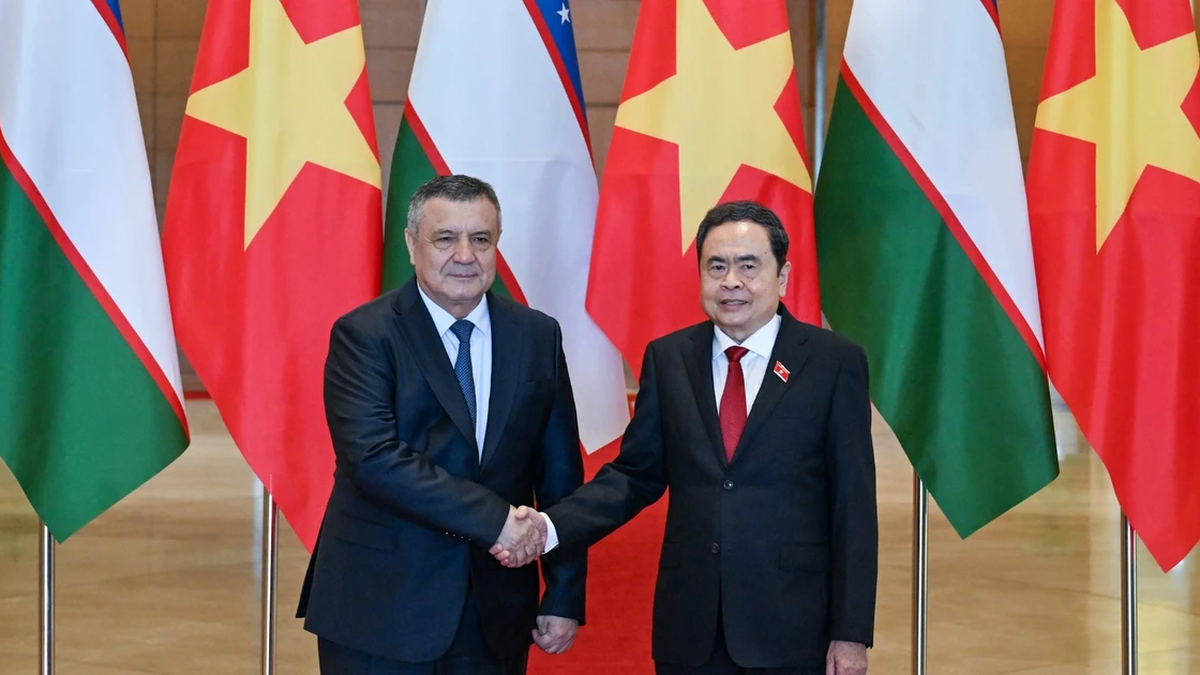

| ペンタゴン付近の爆発をAIが偽造した写真。 |

オンラインのファクトチェック団体「ベリングキャット」のニック・ウォーターズ氏は、この写真の顕著な問題点をすぐに指摘した。まず、事件を裏付ける目撃者がいない。写真に写っている建物もペンタゴンには見えない。目立つ街灯や歩道から突き出た黒い柱など、いくつかの不自然な点は、写真が本物ではないことを示している。

Midjourney、Dall-e 2、Stable Diffusionなど、リアルな画像を作成できる人工知能(AI)再構成ツールは数多く存在します。ただし、これらのツールはデータが不足している場合に不足部分を補うものです。

アルジャジーラは、主要な出来事に関するAI生成画像と実際の写真がインターネット上に掲載される際に、それらを区別するための次のような対策を講じている。

- 爆発や重大な事件が発生した場合、通常、複数の人々から、複数の視点からの事実情報が得られます。

- 誰がコンテンツを投稿していますか?彼らはどこに住んでいて、イベントはどこで開催されていますか?彼らはどのアカウントをフォローしていて、誰が彼らをフォローしていますか?彼らに連絡を取ったり、話したりすることはできますか?

- 画像と周囲の状況を分析する: 近くの場所や交通標識などの手がかりを画像から探し、イベントがいつどこで発生する可能性があるかを判断します。

- 人物の画像では、目、手、そして全体的な姿勢に注目してください。ディープフェイクと呼ばれる、人間を模倣したAI生成動画は、ほとんどのトレーニングデータセットに目を閉じた顔が含まれていないため、まばたきに問題が生じる傾向があります。手は物体を適切に掴むことができません。

- AI が生成した画像に映る人物の肌は滑らかであることが多く、髪の毛や歯までもが超完璧なものになります。

[広告2]

ソース

![[写真] 中央党機関の党委員会が決議第18-NQ/TW号の実施と党大会の方向性を総括](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/27/1761545645968_ndo_br_1-jpg.webp)

コメント (0)